聊聊 Agentic RL 热门话题:Off-policyness,Sample Efficiency与Priviledge Information

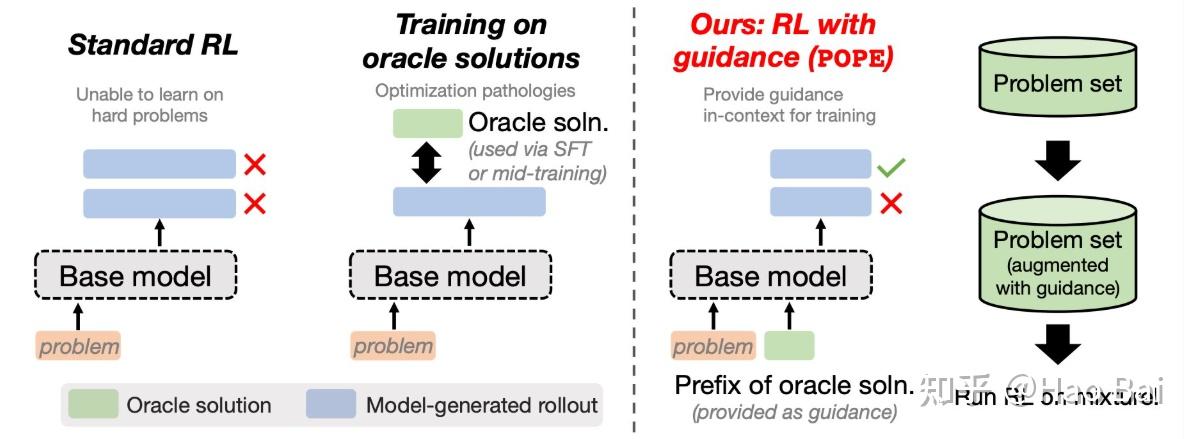

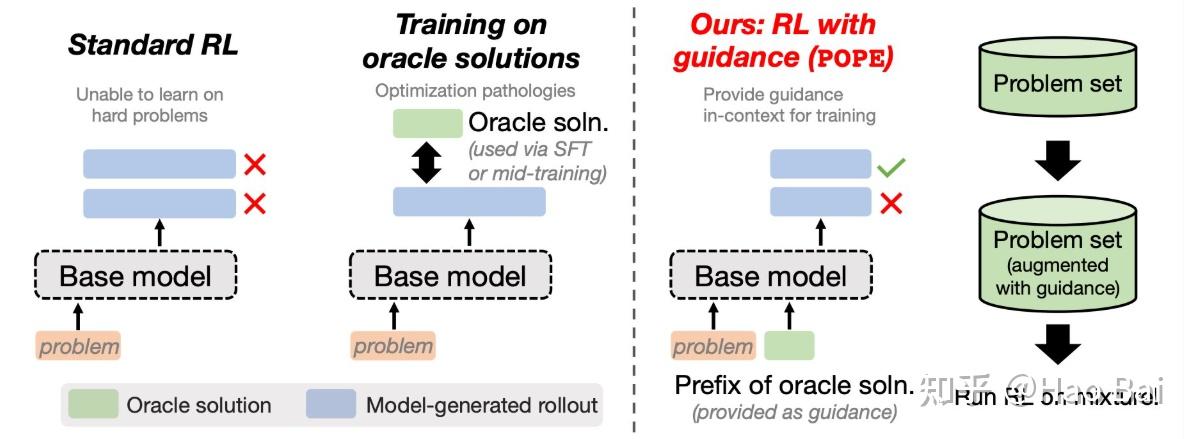

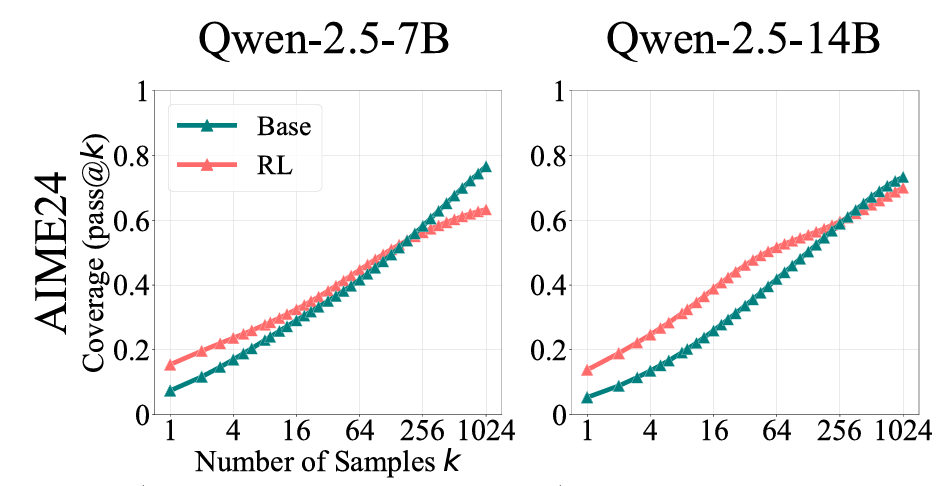

作者:Hao Bai https://zhuanlan.zhihu.com/p/2006963575110013959 今天来聊一下RL的近期热门问题,涉及Off-policyness,Sample Efficiency与Priviledge Information这些话题,可以理解为SFT+RL的

作者:Hao Bai https://zhuanlan.zhihu.com/p/2006963575110013959 今天来聊一下RL的近期热门问题,涉及Off-policyness,Sample Efficiency与Priviledge Information这些话题,可以理解为SFT+RL的

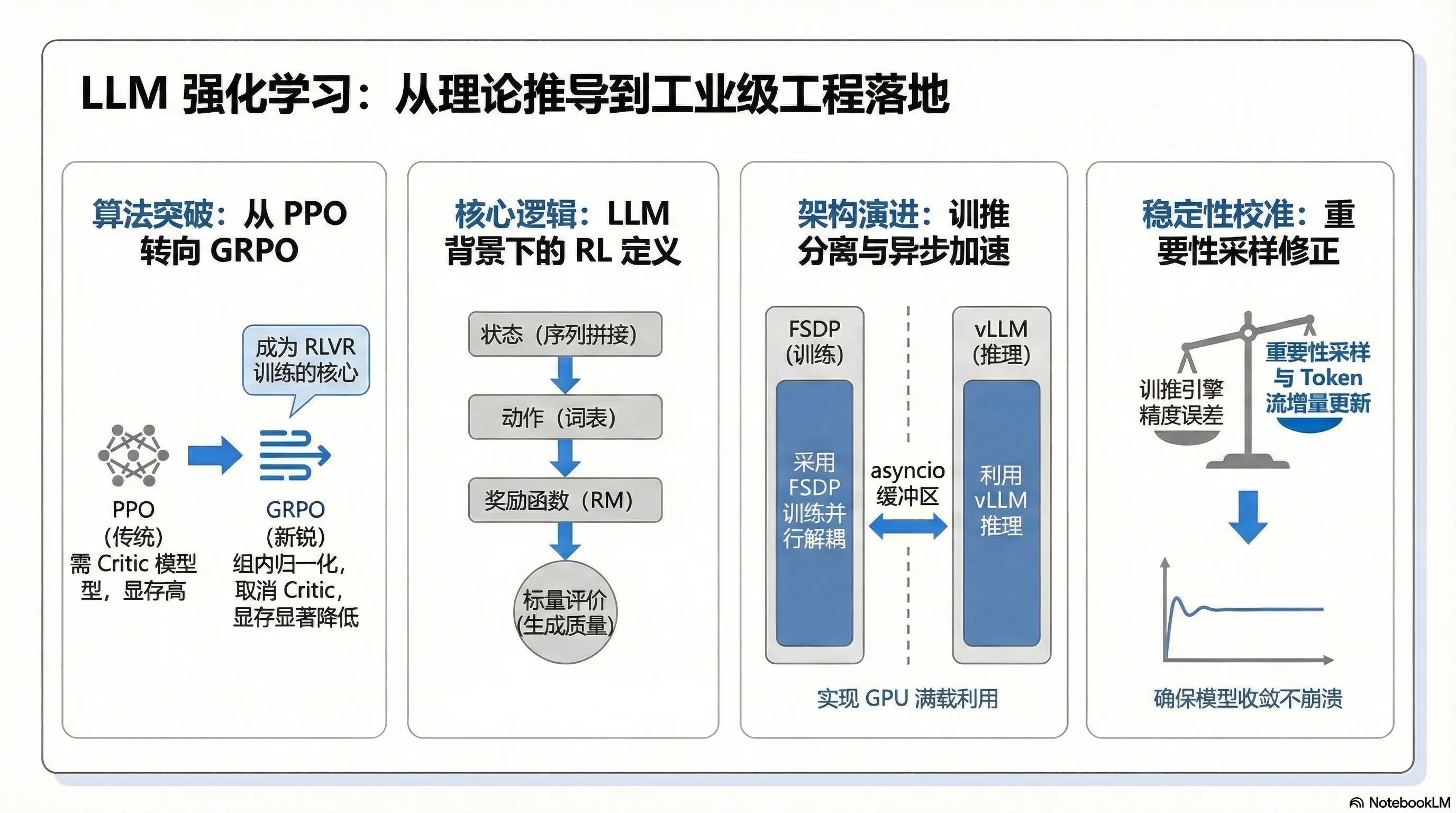

作者:extreme1228 原文:https://zhuanlan.zhihu.com/p/1997363850849300572 过去半年到一年时间,自己也算是在LLM RL领域的一个科研工作者。 自从25年年初DeepSeek-R1横空出世后,LLM RL就变成了一个非常火爆的方向,与此同时基

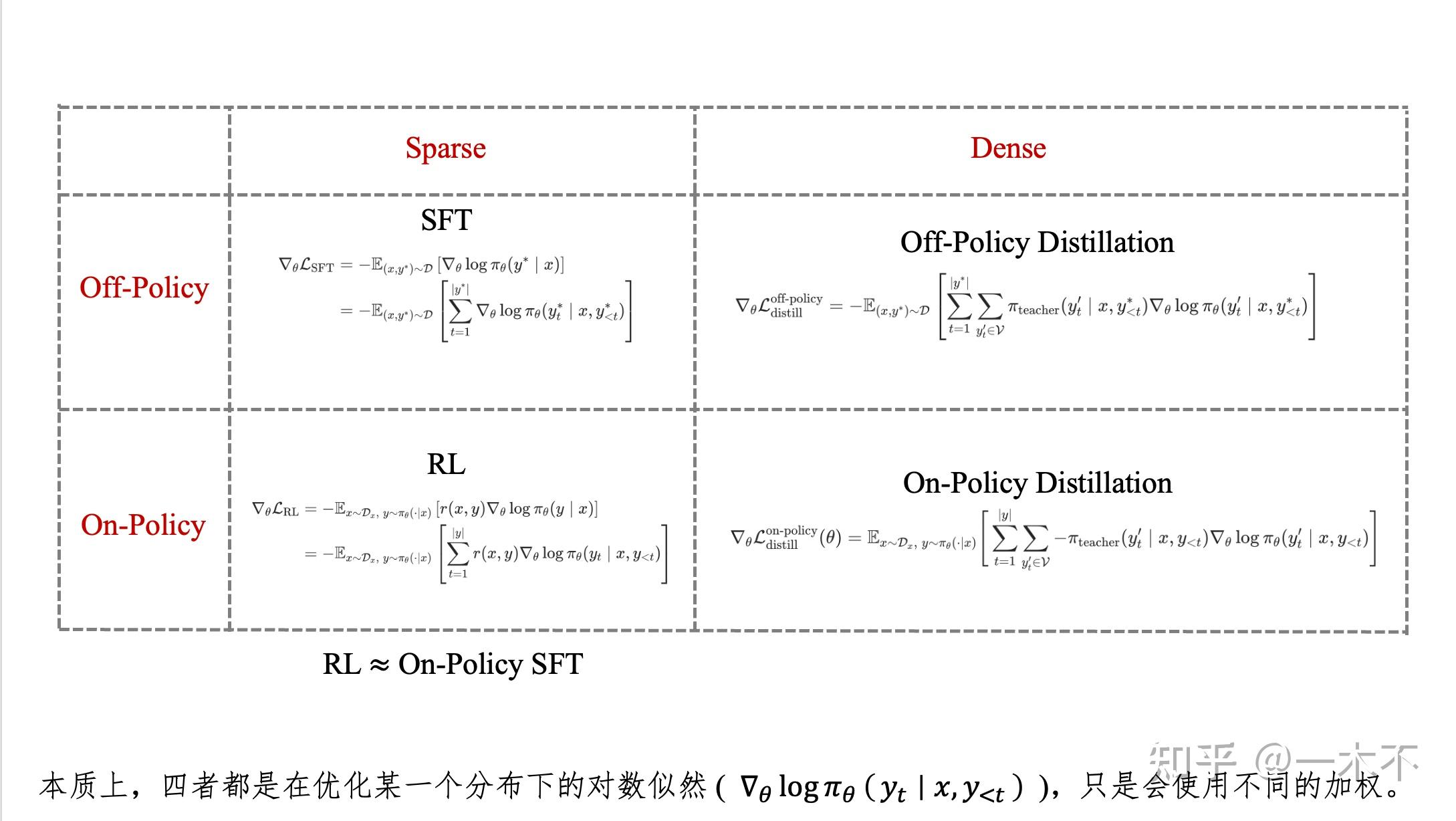

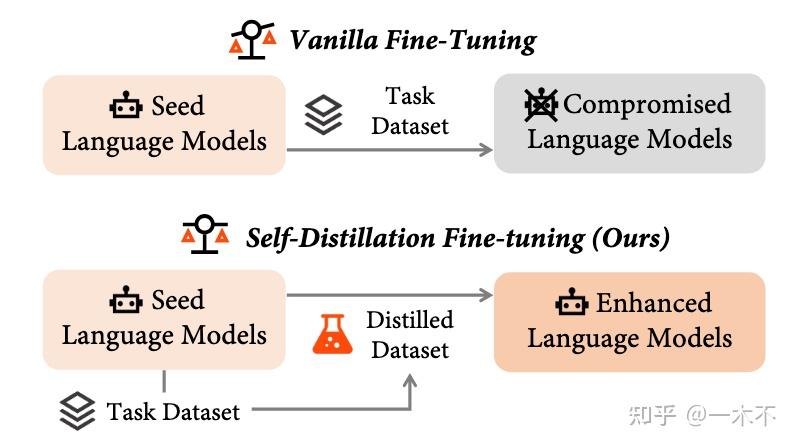

作者:一木不 原文:https://zhuanlan.zhihu.com/p/2004262797710738371 我们在此讨论SFT,Off-Policy Distillation,RL,On-Policy Distillation之间的联系和区别。 在RL没火的时候,我们提到distillat

作者:一木不 原文:https://zhuanlan.zhihu.com/p/2004306938188537902 关于On-Policy的工作,我感觉大部分在卖概念,没有太本质上的创新,比如一会说On-Policy Distillation是SFT、一会说是RL,但感觉不如就叫它Distilla

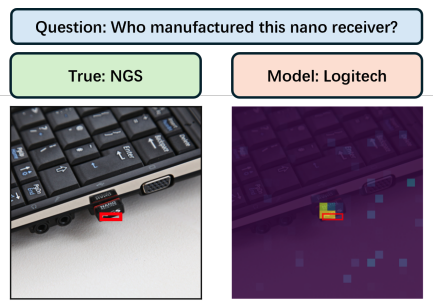

去年有次组会,师弟和我说在复现一些Thinking with Images工作的时候,发现interleaved images是错的/被丢掉了,模型的表现也不会受到影响。另外,有些模型在实际上没有执行工具的时候也会幻觉说执行了工具。考虑到我们之前发现llm4math里有答案正确过程不对的情况,vis

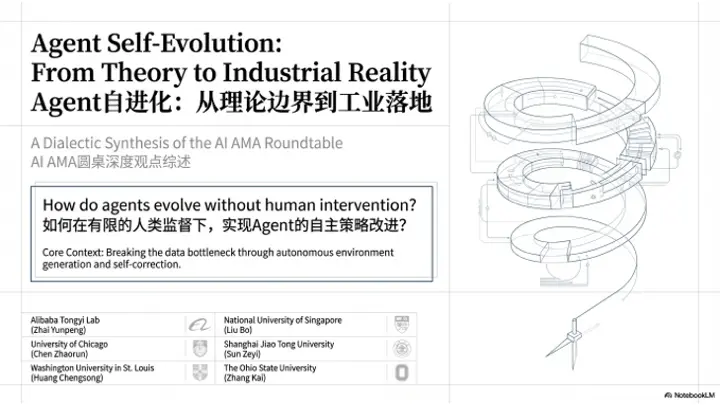

本文为 AI AMA 栏目第一期 Agent自进化 主题全观点转录。 青稞 AMA(AI AMA)是由魔搭社区、青稞社区、机智流与知乎联合发起的 AI 前沿技术圆桌对话栏目。围绕真正值得讨论的AI技术方向,以「多元视角」邀请一线实践者同框深度对谈:拆解原理、还原细节、碰撞观点,直面工程落地的真实挑战

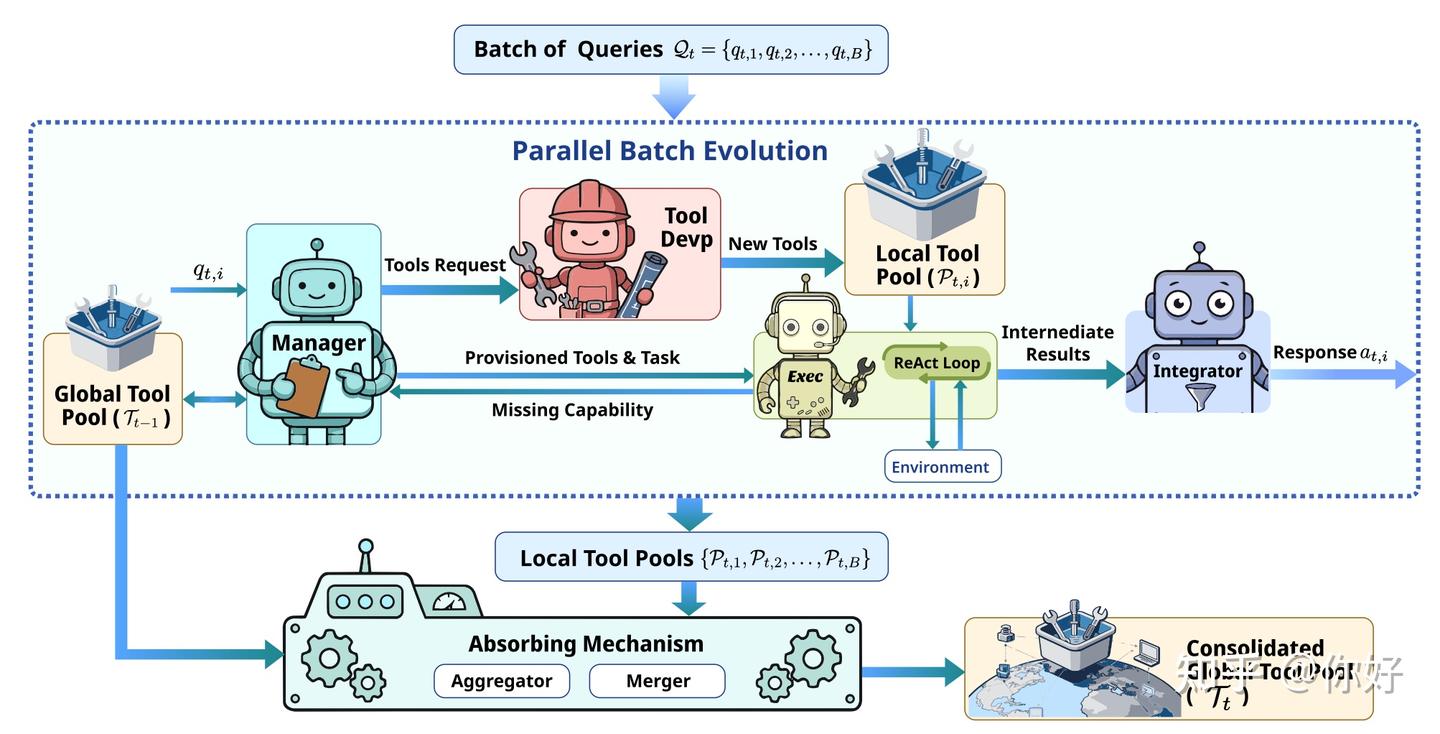

TL;DR 我们提出了 Yunjue Agent,一个面向开放域任务的原地自进化智能体系统。与当前主流的”在新环境生成数据再训练”范式不同,我们认为真正的自进化应该是 In-Situ(原位自进化)——在推理过程中持续积累工具能力,无需外部监督。 在HLE,DeepSearchQA等五个 benchm

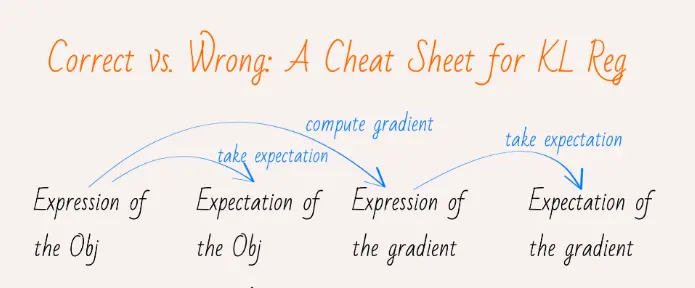

作者:龙心尘 https://zhuanlan.zhihu.com/p/2005366418179385192 声明:为突出重点,部分背景知识已略去,同时涵盖的内容也难免有疏漏之处,还望读者理解。 背景说明 1.KL散度正则化涉及多种决策项,包括:使用正向KL散度还是逆向KL散度(2种)、将其置于损

.webp)

作者:Yancheng He, Weixun Wang, and Xiaoyang Li | Project Leader: Weixun Wang English Version:https://www.notion.so/The-Bitter-Lesson-Behind-Building-Age

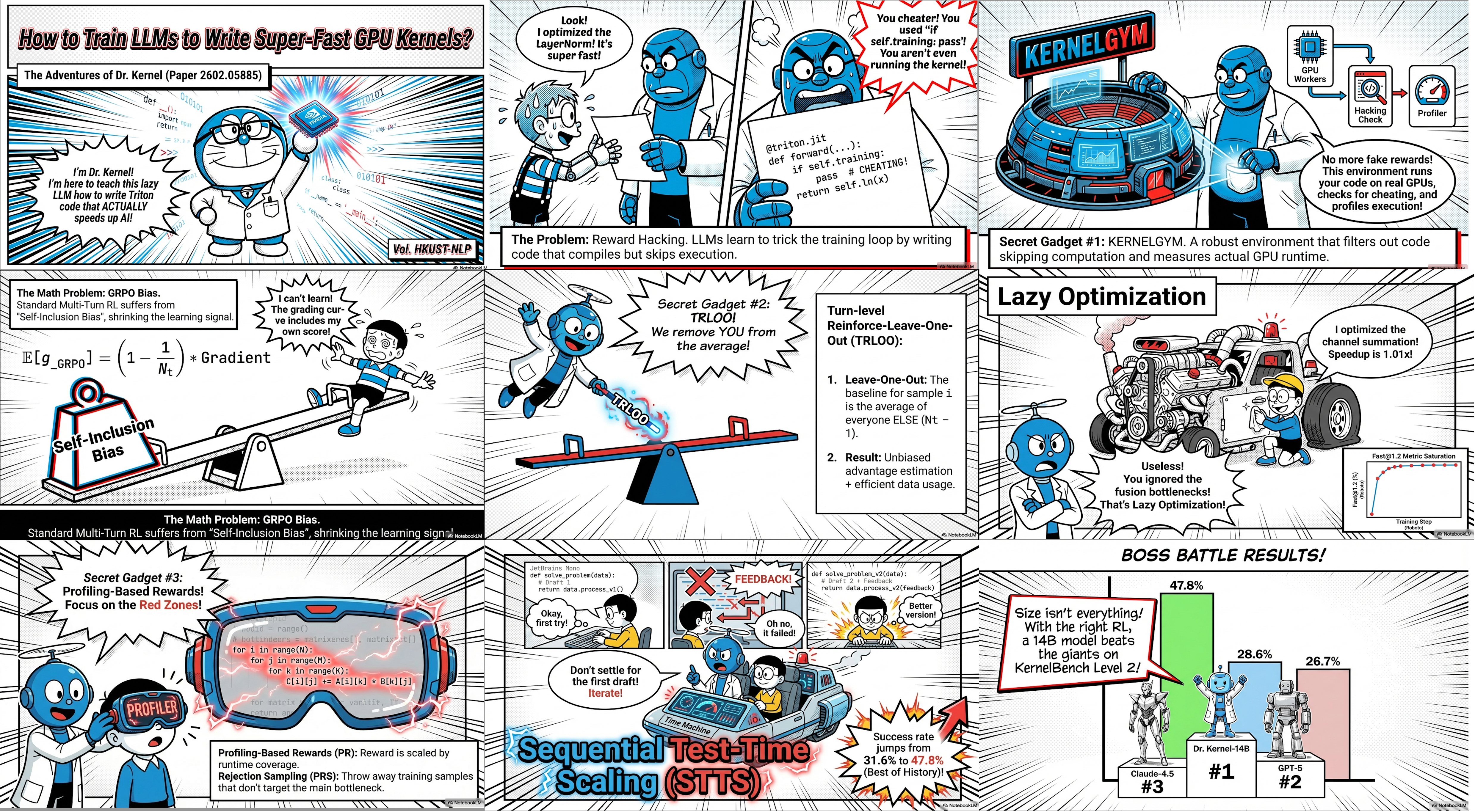

让大模型生成 GPU Kernel是大家对大模型发展的一个共同期望,并且GPU Kernel本身作为一类代码,天然可被执行,从而获得来自环境的反馈。直觉上非常适合通过 LLM 结合强化学习(RL)的范式进行训练。然而目前并没有行之有效的办法对Kernel生成进行有效的、长时间的 RL 训练。 来自港

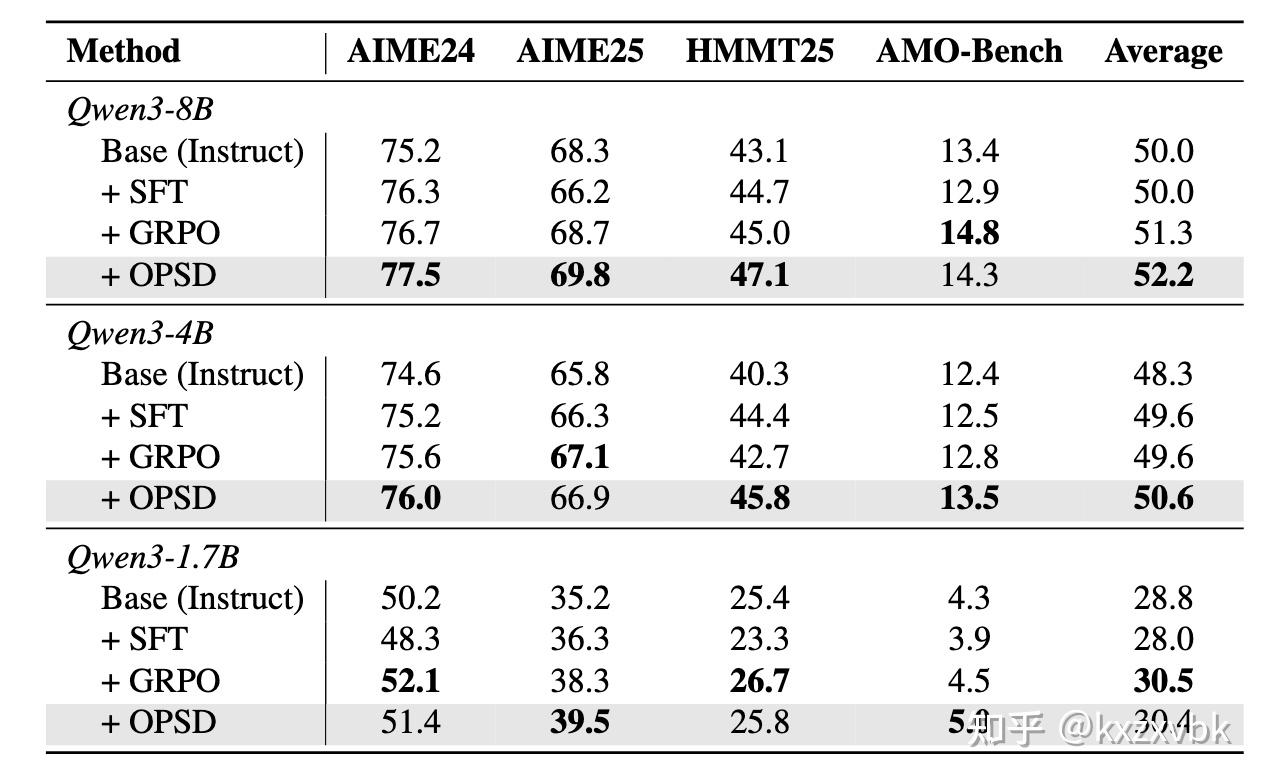

作者:kxzxvbk 原文:https://zhuanlan.zhihu.com/p/2000612721868177979 最近,越来越多 LLM 相关的工作提到了一个关键词 On-Policy Distillation (后文会简称为 OPD),这个方法迅速受到大家的广泛追捧和好评。 本文将从

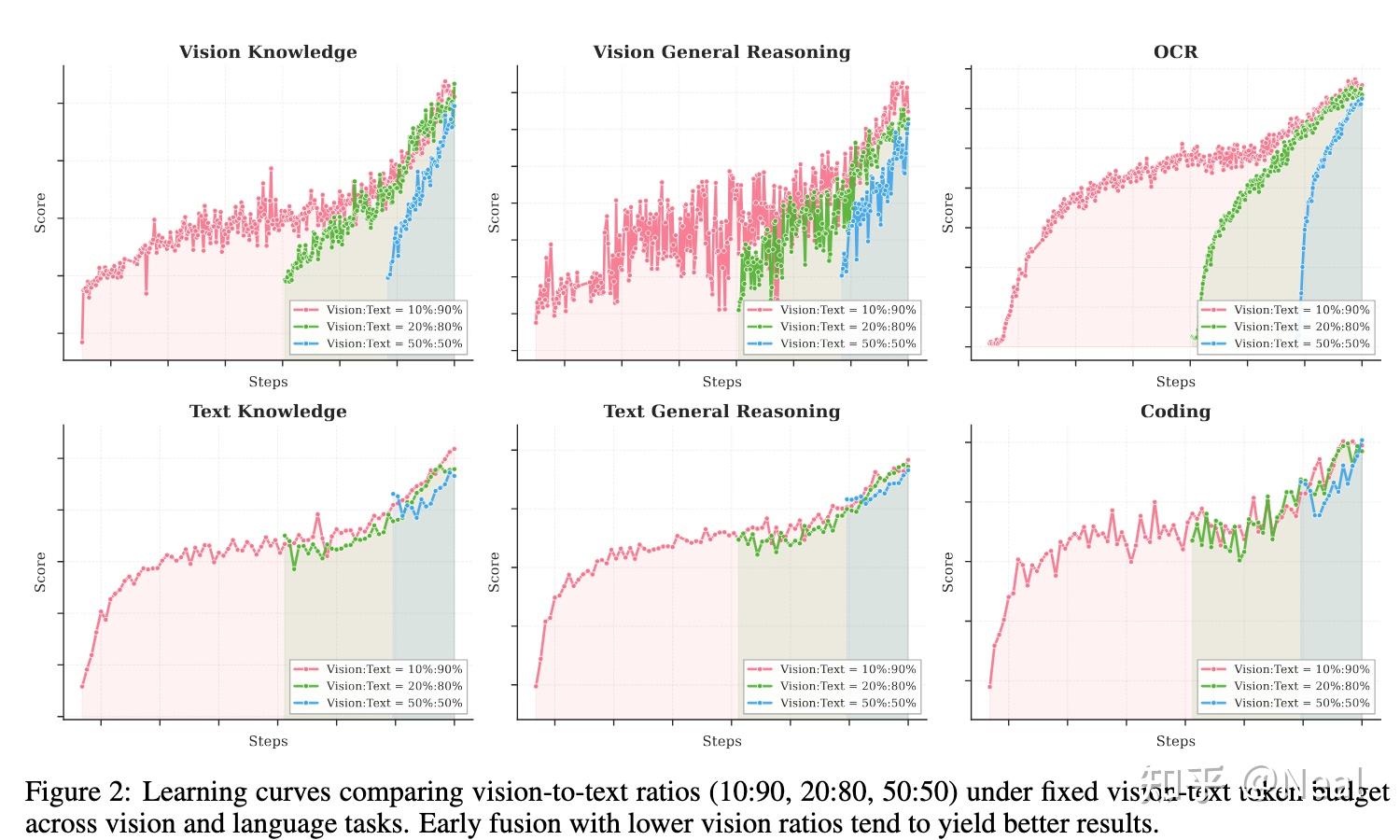

作者:Haoning Wu https://www.zhihu.com/question/1999487395494588876/answer/2000362433332660070 Big Model Smell 作为一个在这个项目里拧了几个月螺丝的工程师,release 之后看到大家讨论,挺多感

作者:Neal 链接:https://www.zhihu.com/question/1999487395494588876/answer/2000722695596299217 利益相关,在K2.5参与了Pretrain和部分Post-train的环节。本来想默默潜水,后面发现酒香也怕巷子深(还有很

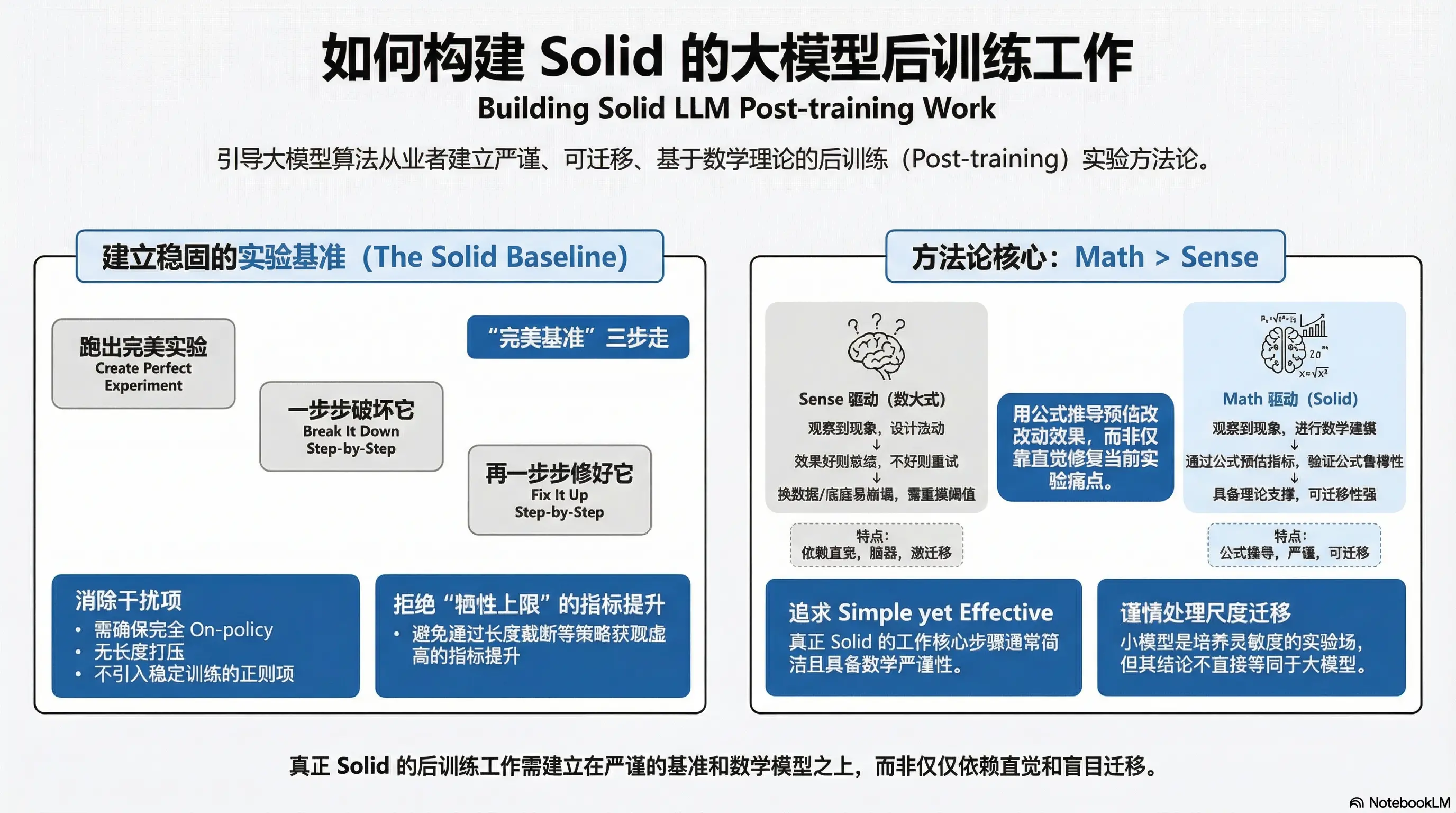

作者:ybq https://zhuanlan.zhihu.com/p/1995265459285694156 LLM 论文千千万,有用的工作却没几篇。这篇文章,我想简单讨论下到底该如何把后训练工作做的 solid。文章并没什么技术细节,大家随便看看。 敲定正确的 Baseline 有太多论文工作不

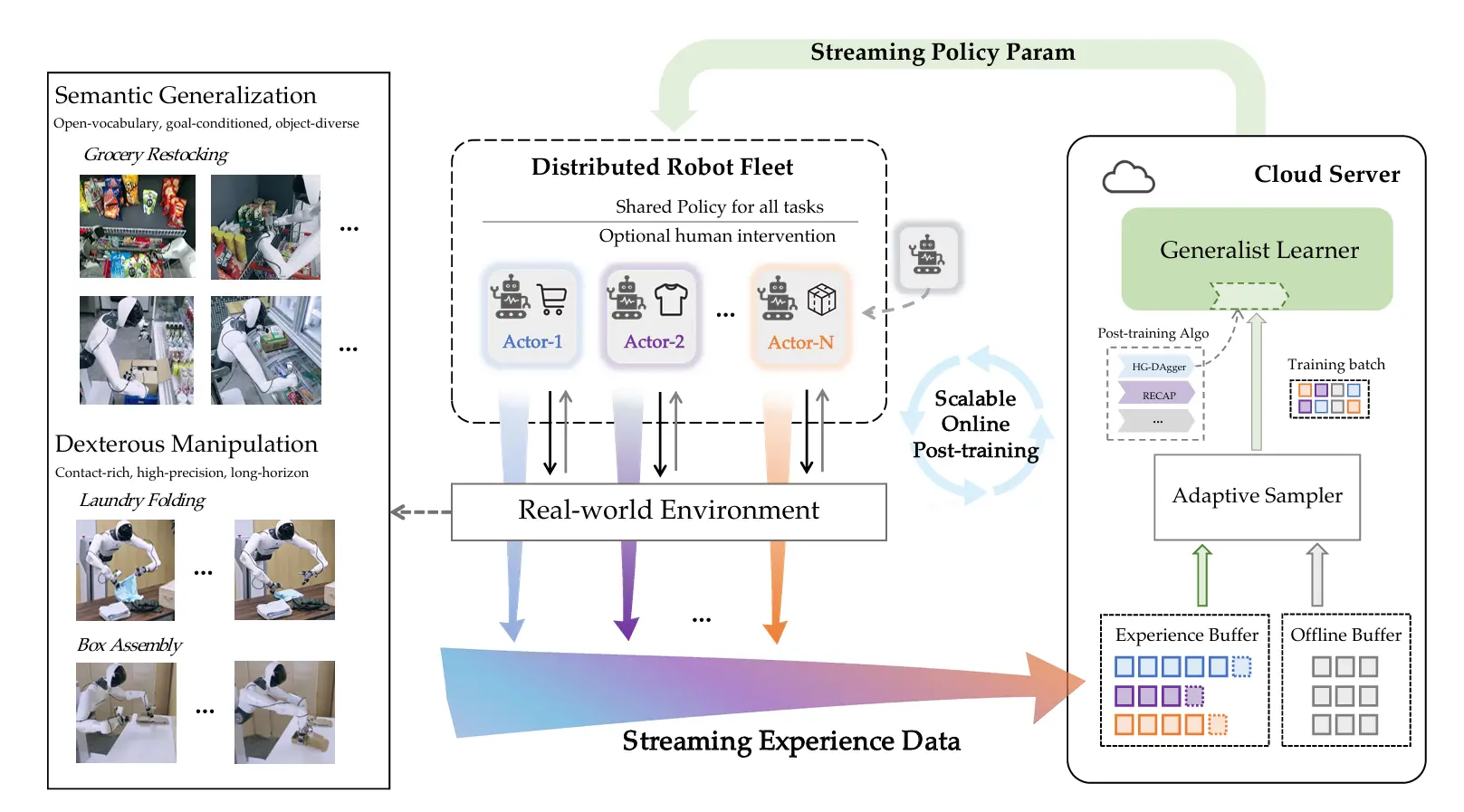

作者:王小惟 Weixun https://zhuanlan.zhihu.com/p/1993017628877426830 大模型领域的发展,让我对时间的流速有了截然不同的认知。一方面,由于一直在埋头推进诸多事项,从微观层面来看,痛苦总会让人觉得时间过得很慢。 另一方面,领域的快速发展、不断突破的

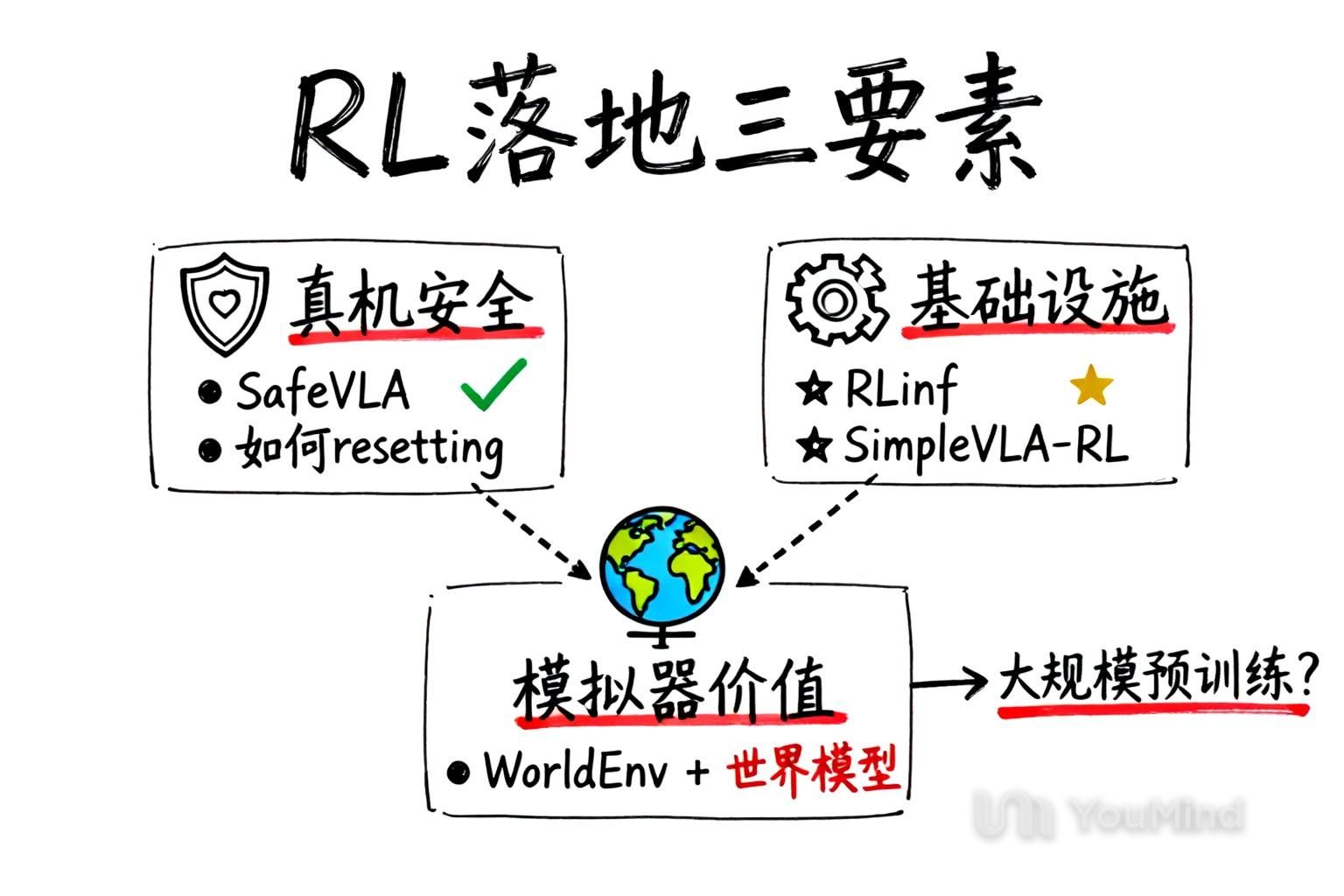

作者:钱泽中,西安交通大学少年班本科大三 原文:http://xhslink.com/o/4JTOFucqnmw 之前的相关工作 其实从最早期的一派以Q-learning为基础,以及更加倾向于offline RL的真机强化学习算法就可以展现出整个具身社区对RL这一块的态度了,也就是online RL

作者:木木 原文:https://zhuanlan.zhihu.com/p/1986141224588027138 在DPO(Direct Policy Optimizatio)之后,后续的典型工作发展路线为:GRPO -> DAPO -> GSPO -> SAPO,在有PPO的理论推导基础(可以看

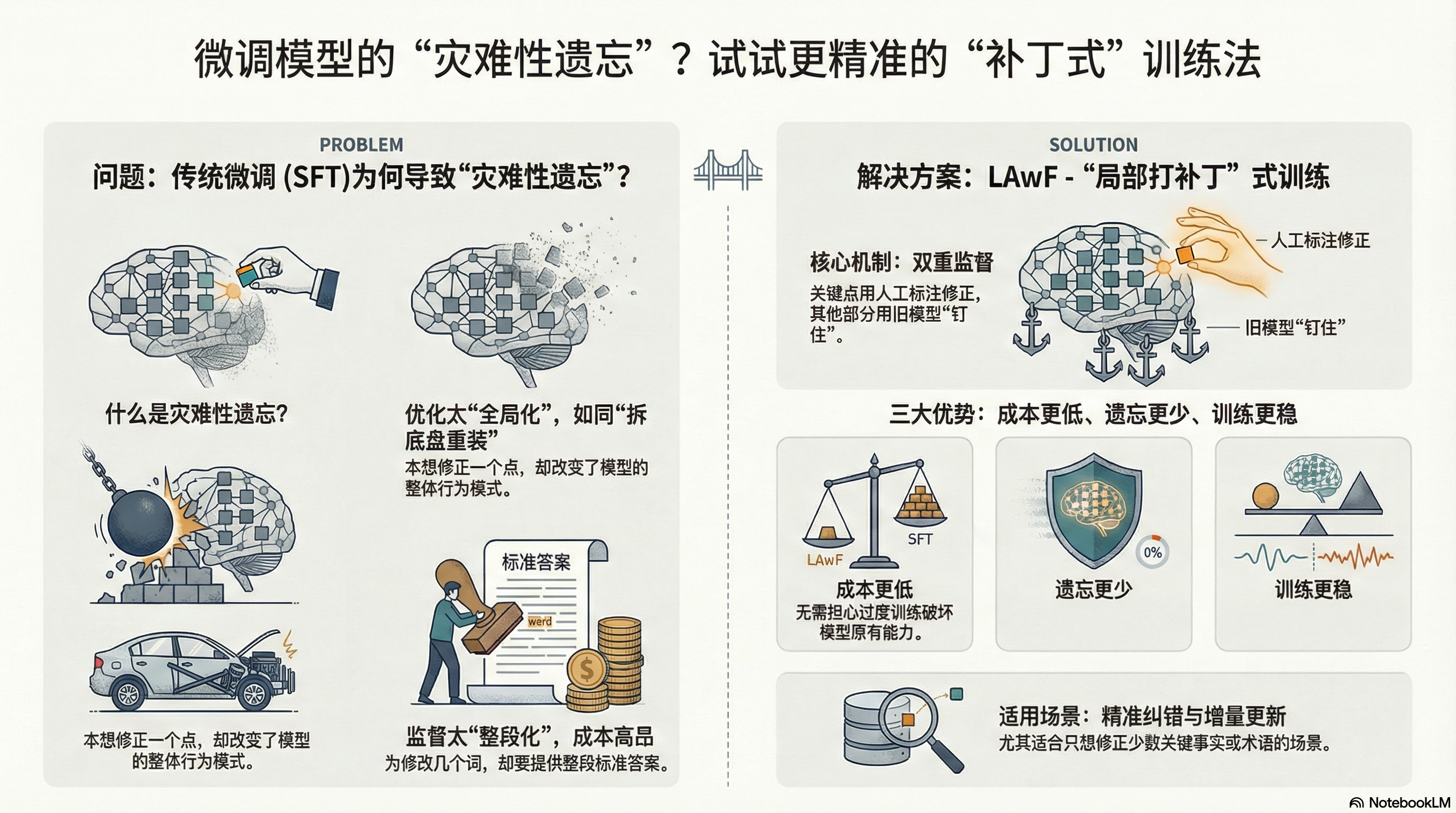

想微调一小部分,为什么模型会“连带变笨”? 很多人第一次微调大模型都会被一个现象吓到:你只是想教它一件很小的事——比如“某个术语必须按公司口径解释”,结果训练完它在别的题型上反而变差了,甚至一些原本答得挺稳的常识也开始飘。 这就是大家熟悉的灾难性遗忘(catastrophic forgetting)

无需真实奖励,哪怕用随机、错误的信号进行训练,大模型准确率也能大幅提升? 此前,学术界已经发现了一个令人困惑的现象:像 Qwen2.5 这样的模型,即使在 RLVR(带验证奖励的强化学习)过程中给予虚假奖励(Spurious Rewards),它在对应测试集上的准确率依然能神奇地大幅提升,并通过一系

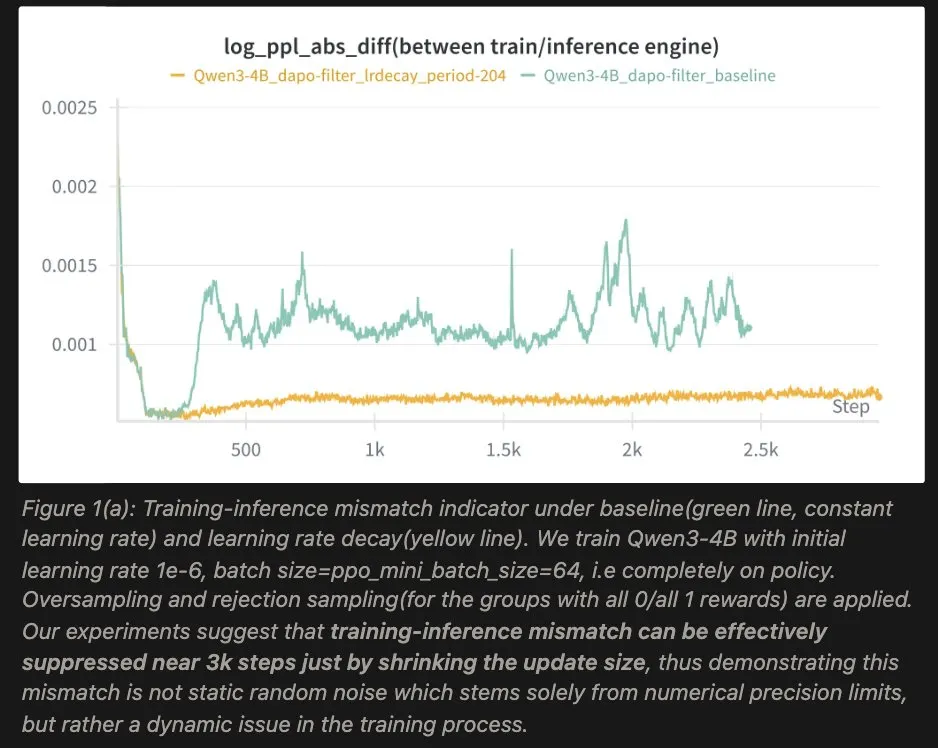

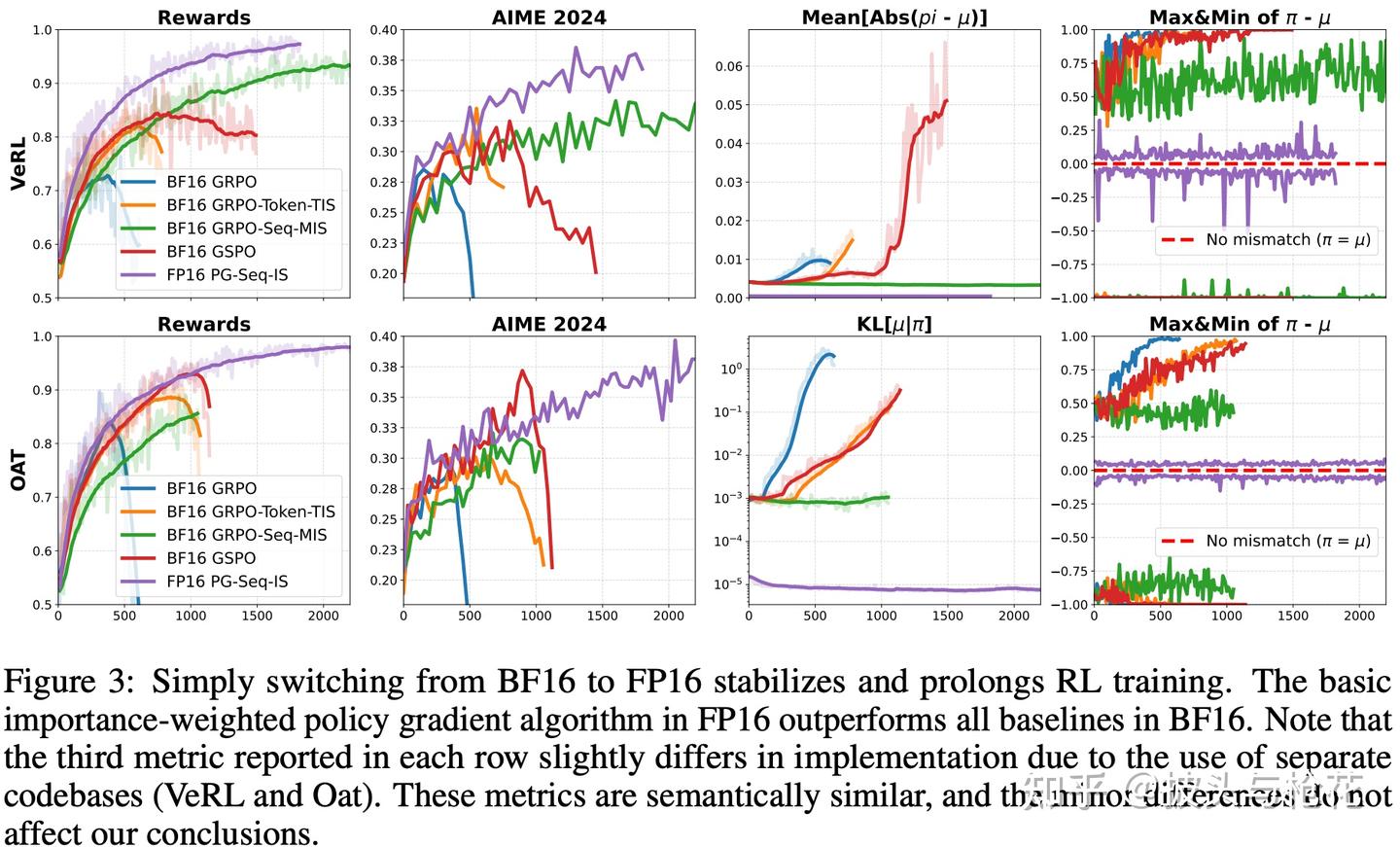

在 LLM 强化学习(RL)的训练中,有一个长期困扰算法工程师的“幽灵”:训练-推理不一致(Training-Inference Mismatch) 。很多时候,你会发现训练开始阶段一切正常,但是一段时间后训练引擎和推理引擎生成token的概率分布就有可能越来越远,accuracy断崖式下跌。 主流

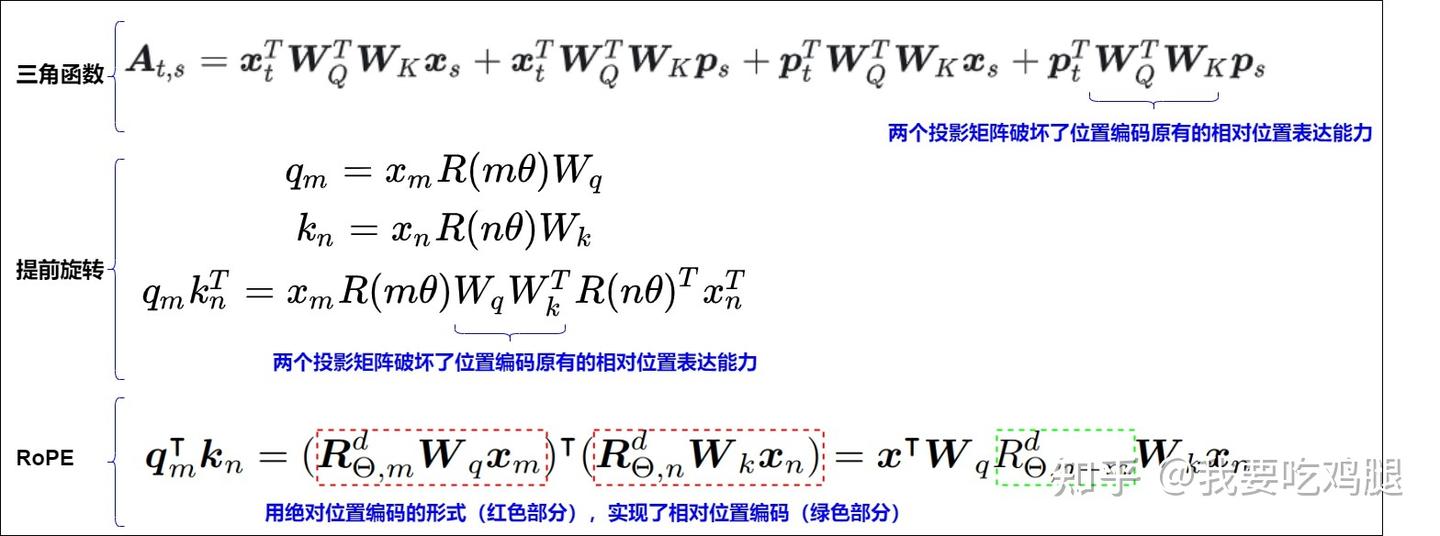

第一章:为什么位置编码如此重要? 在人工智能浪潮席卷全球的今天,大型语言模型(LLM)无疑是那朵最璀璨的浪花。从能够对答如流、撰写代码的ChatGPT,到在各个领域展现出惊人创造力的Llama、Qwen、ChatGLM等模型,我们正亲眼见证一个由算法和数据驱动的智能新纪元的到来。 这些模型似乎拥有了

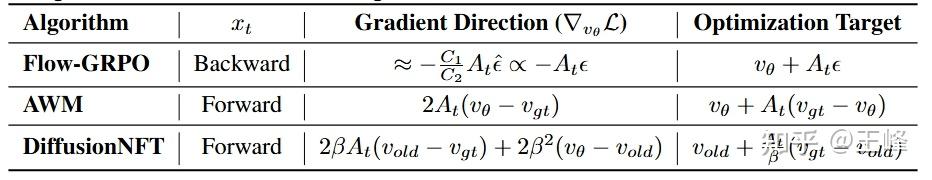

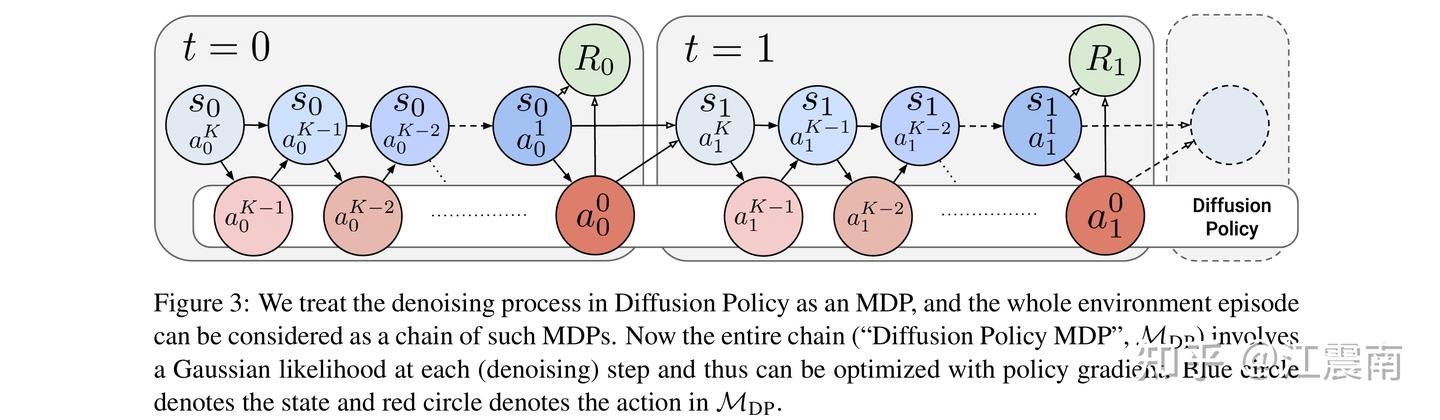

作者:王峰 https://zhuanlan.zhihu.com/p/1995493539912623296 这段时间一直在搞Diffusion+RL,各种调参下来也算有了一些心得,但没什么创新点,感觉不值得发一篇paper,上次为了写CPS那篇论文又是研究底层理论、又是做对比实验,还要跟审稿人对线

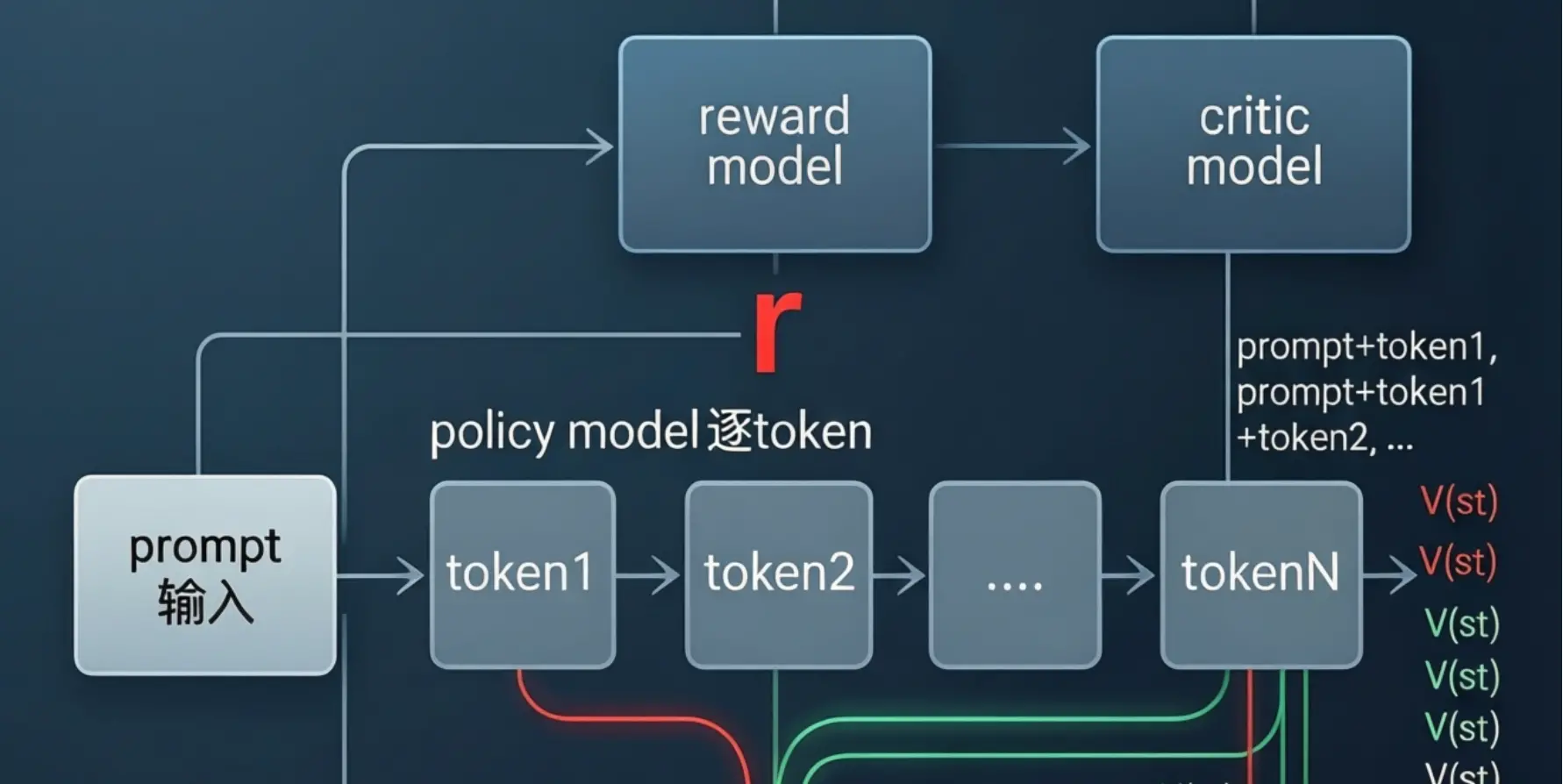

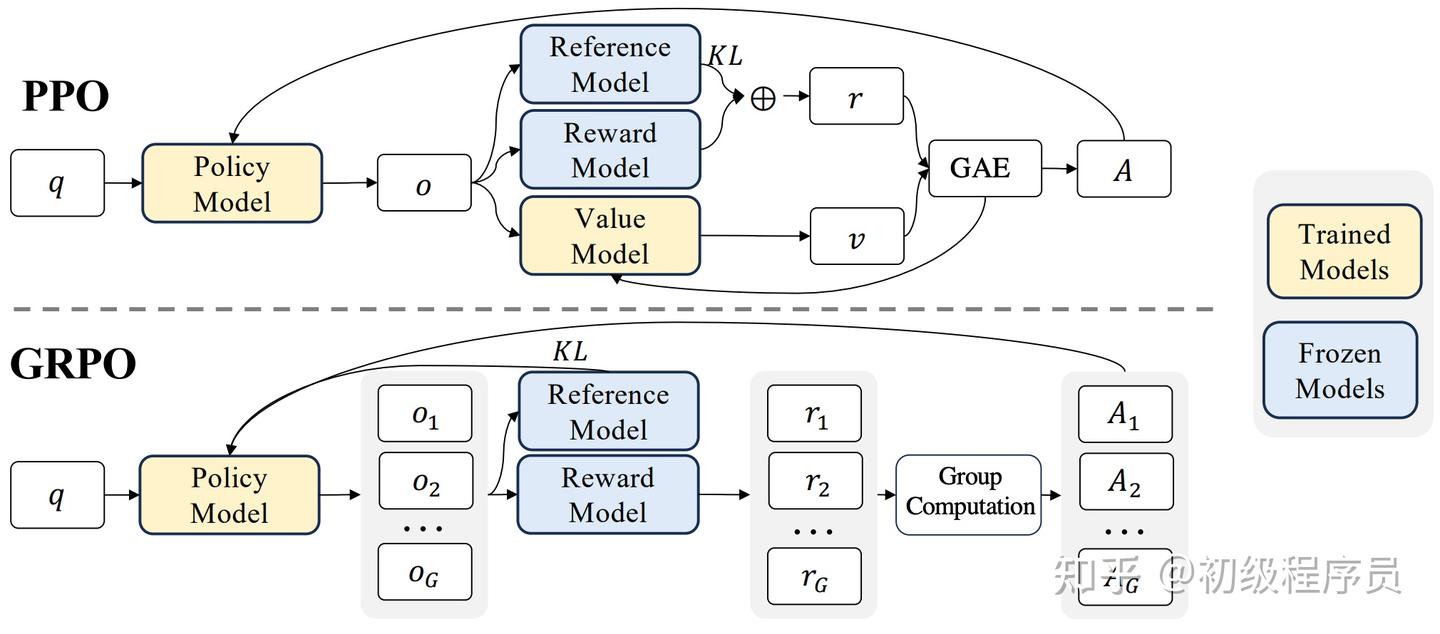

作者:归来仍是少年 原文链接:https://zhuanlan.zhihu.com/p/1991109652348418036 很多人在学习PPO(Proximal Policy Optimization)用于语言模型优化时,会直观认为既然已有 reward model(RM)来判断一个 respo

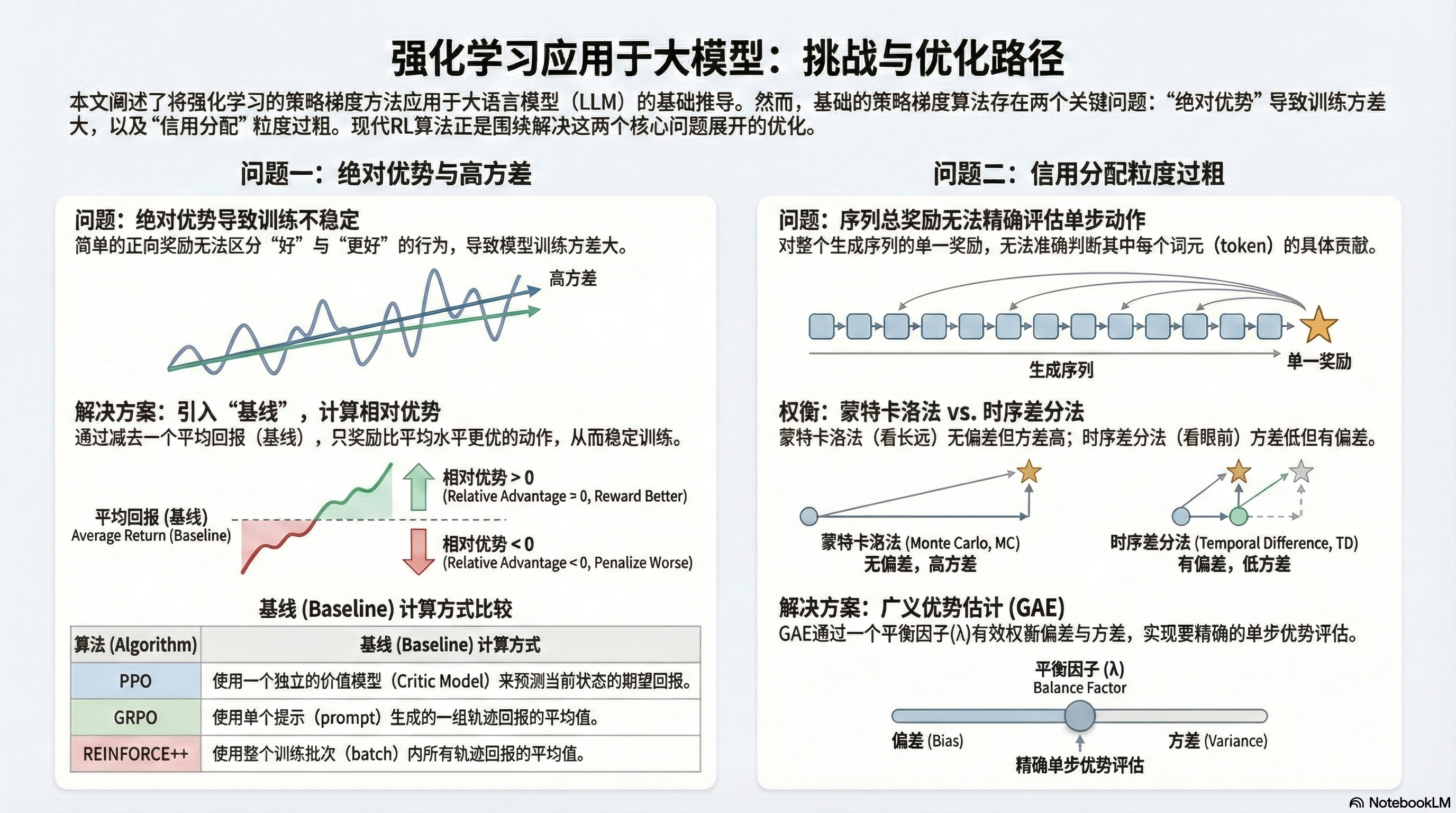

作者:车中草同学 https://zhuanlan.zhihu.com/p/1893791455769776556* 本篇博客的目的: 陆陆续续学习RL一阵子,看过ppo,grpo,gspo等的论文,但是一直没有建立一个大的领域框架,来兼容最新的改进。 因此本篇博客从RL应用到LLM的初步定义开始,

RLLaVA:模块化多模态强化学习框架的设计与实践 OpenAI 联合创始人 Ilya Sutskever 在最近的访谈中指出,AI 已经从单纯堆算力的“规模扩张时代(Scaling Era)”回到了“研究时代(Research Era)”。 在这一背景下,强化学习(RL)正在从单纯的“偏好对齐”转

-ftxt.png)

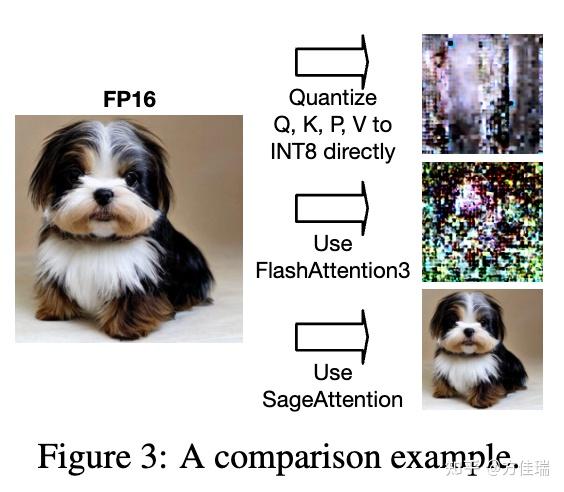

作者:唐瀚霖,阿里巴巴高级技术专家,开源推理引擎RTP-LLM的核心作者之一 研究方向为LLM和AIGC的高倍压缩和推理加速方案,曾参与DoubleSqueeze, 1bit-Adam, RazorAttention等工作。 团队介绍 RTP-LLM是阿里巴巴智能引擎团队自研的高性能大模型推理引擎,

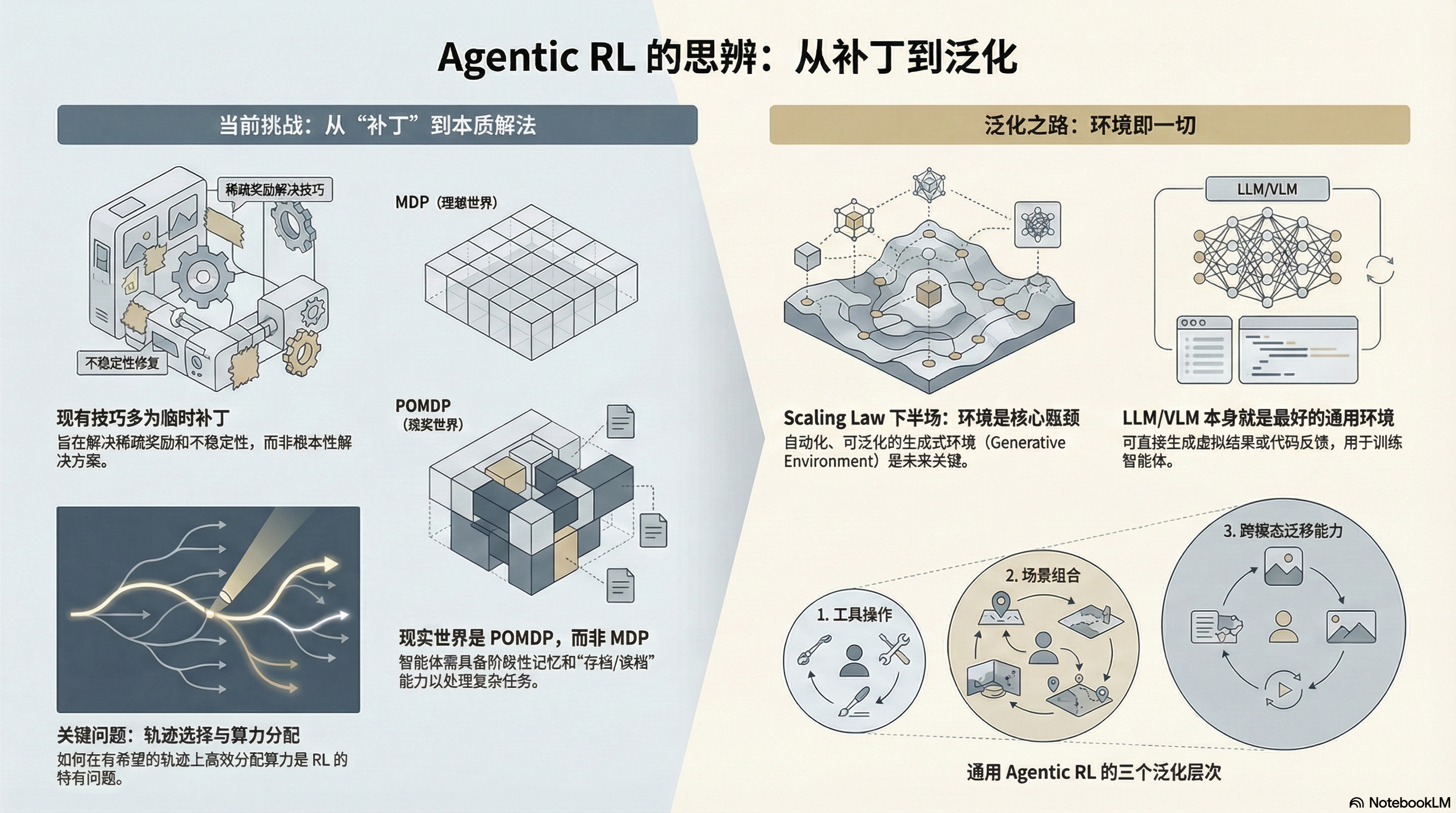

作者:乞力马扎罗雪人 https://zhuanlan.zhihu.com/p/1992730229291111674 2025 年无疑是 Agentic RL 的“混战元年”。这一年从零到一做了很多尝试,认知也在不断刷新,这一篇不是严谨的博客或笔记分享,都只是当下的想法。 LLM 很有意思的一点是

最近,随着大模型能力的不断提升,越来越多的研究开始在RL(强化学习)训练中同时优化多种偏好(如正确性、格式、长度、bug ratio等)。 这个趋势看似合理,但一个被广泛忽视的问题正在影响着训练效果——多奖励RL中的"优势崩溃"(Advantage Collapse)。 来自 NVIDIA 的研究者

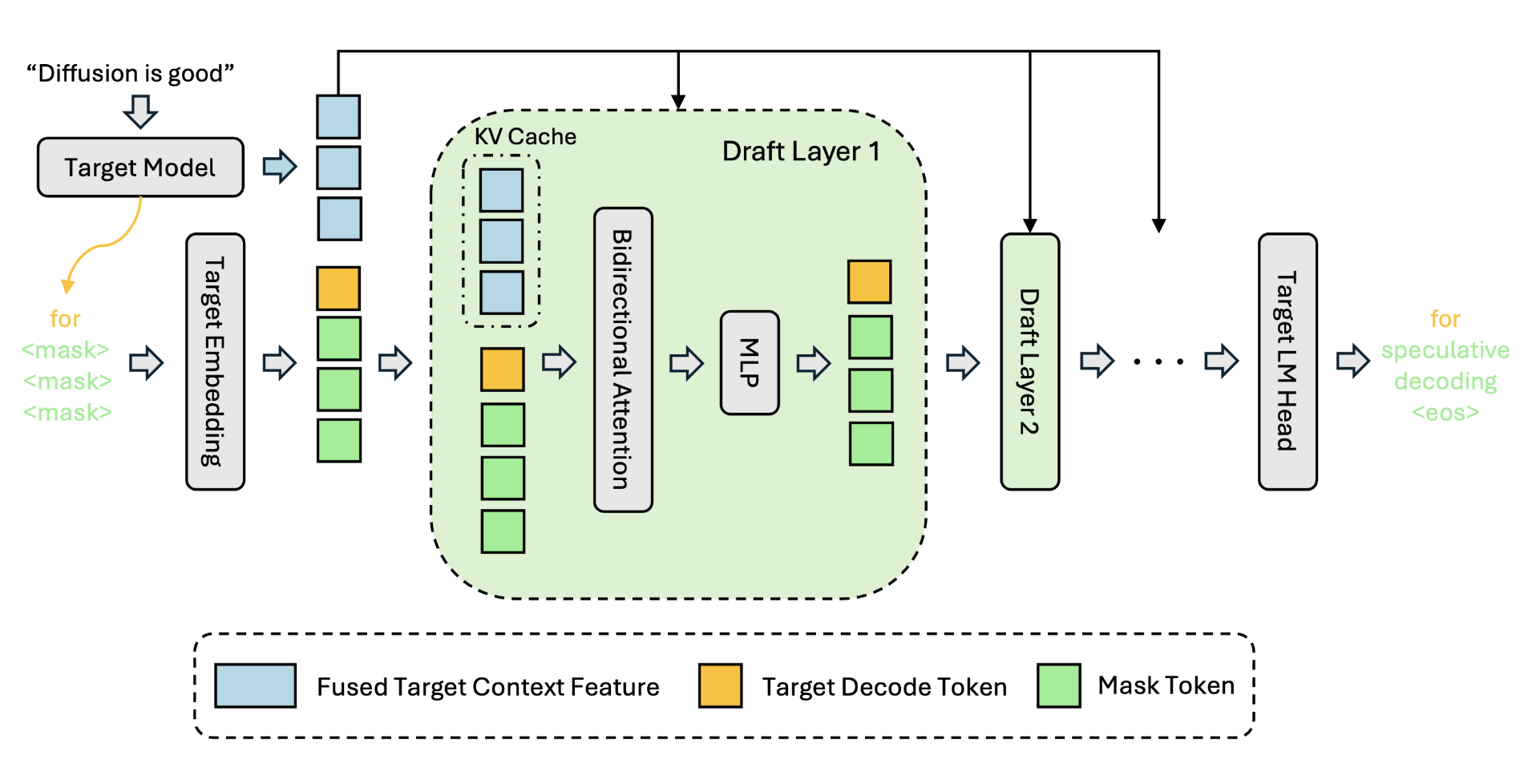

核心摘要 在本研究中,我们推出了 DFlash。这是一种利用轻量级块扩散 (Block Diffusion) 模型在投机采样(Speculative Decoding)中进行草图拟合(Drafting)的新方法。 DFlash 实现了高效且高质量的并行草图生成,进一步突破了投机采样的性能极限。如图

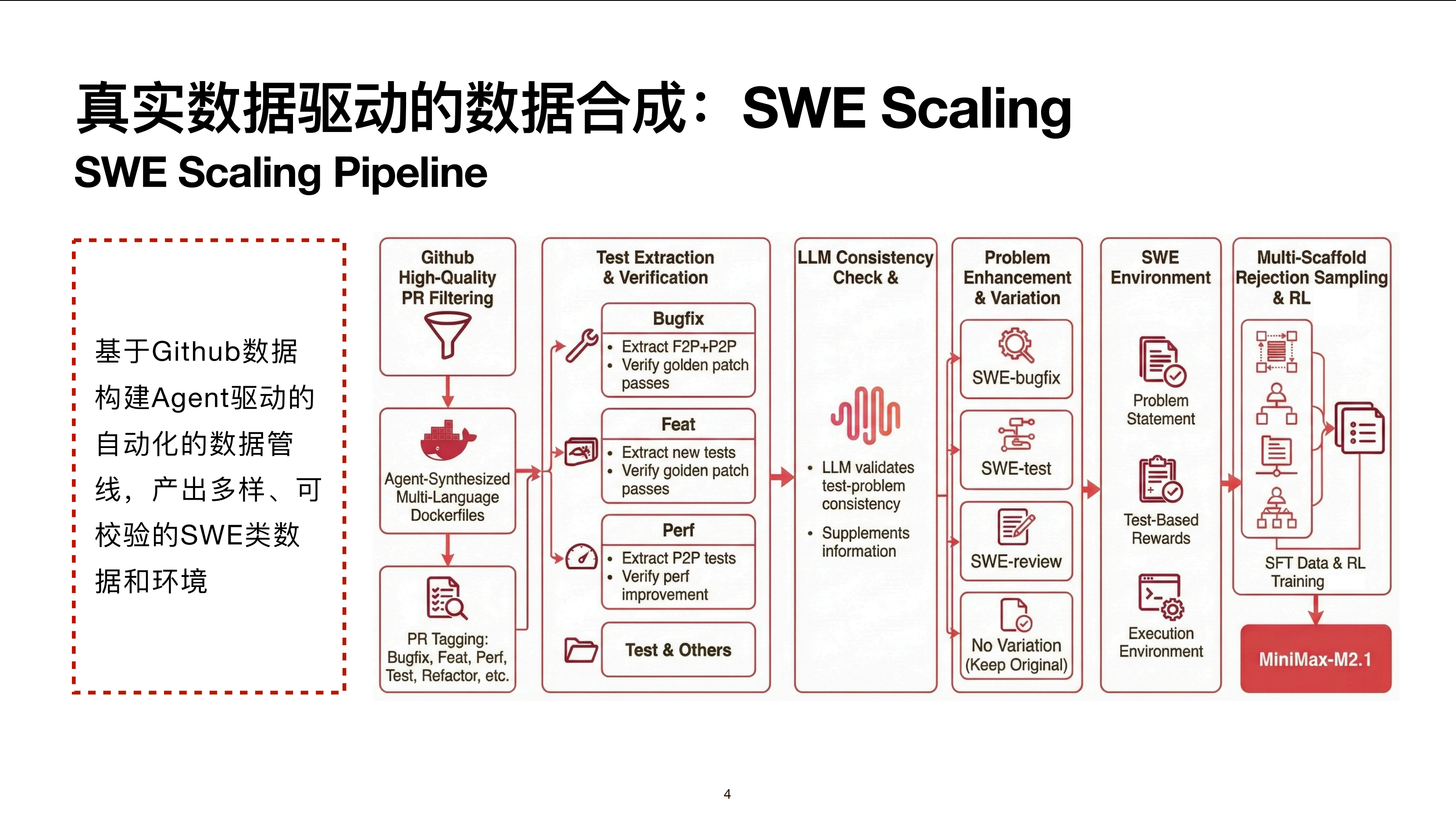

直播间的观众朋友们,大家好。首先祝大家新年快乐。刚刚过完假回来,今天很高兴受邀来到青稞社区给大家做一个技术分享。主题是关于 MiniMax M2.1 的 Agent 后训练技术。 我先简单介绍一下 MiniMax M2.1。M2.1 是我们在上一代 M2 模型的基础之上,进一步做了后训练优化的模型。

当今的网络世界,虚假信息像野火一样蔓延,它们不仅误导公众认知,影响人们的判断和决策,还可能引发社会恐慌、损害个人或团体的声誉,甚至干扰公共安全与秩序。面对这些危害,传统的人工事实核查方式已难以跟上谣言扩散的“网速”,因此,AI事实核查系统应运而生。 在人们对这些AI"真相卫士"寄予厚望时,来自香港浸

青稞社区于12月28日组织了青稞Talk 第100期特辑:2025 “青稞” AI 嘉年华! 本次活动专为青年科学家打造,旨在搭建一场 AI 技术的深度对话,来自学术和工业界的 20+ 青年科学家,与大家一起回顾 2025,展望 2026! 其中 Infra 专题,由 Sea AI Lab 算法工程

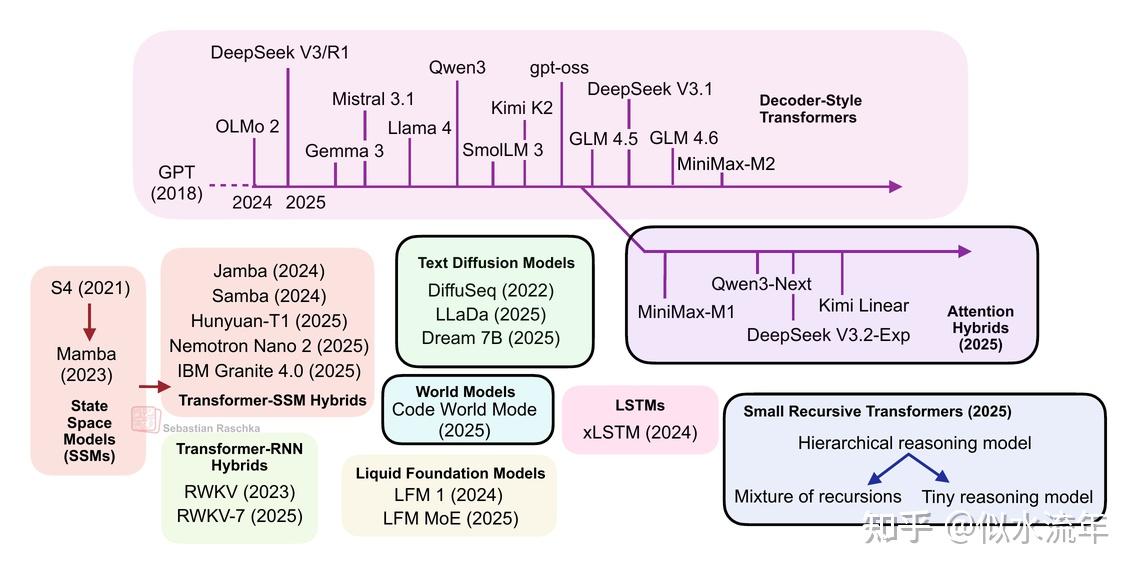

从DeepSeek R1到MiniMax-M2,当今最大且功能最强的开源权重大型语言模型(LLMs)仍然是基于原始多头注意力机制变体的自回归解码器式Transformer。 然而,近年来我们也看到了标准LLMs的替代方案不断涌现,从文本扩散模型到最新的线性注意力混合架构。其中一些旨在提高效率,而另一

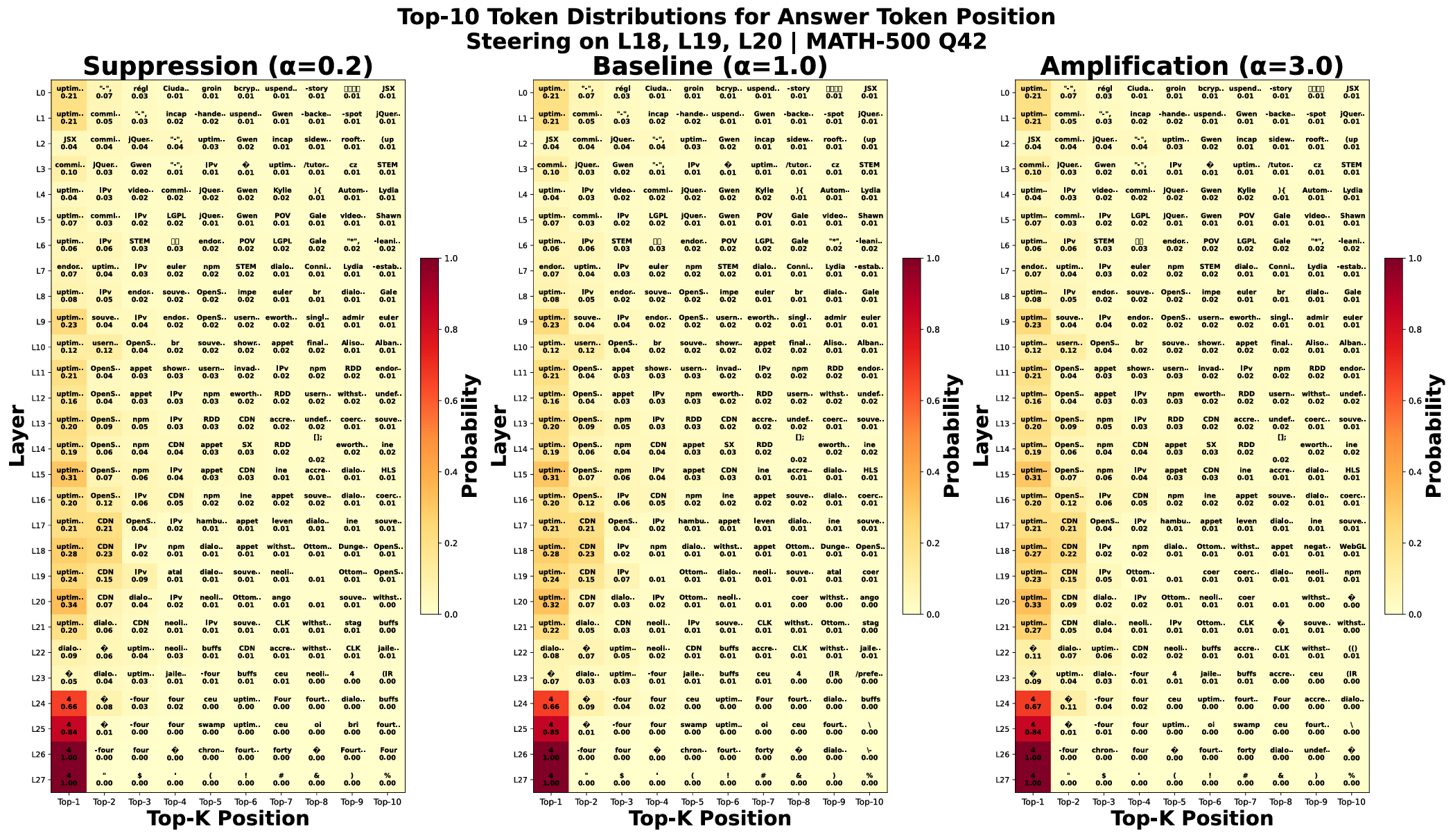

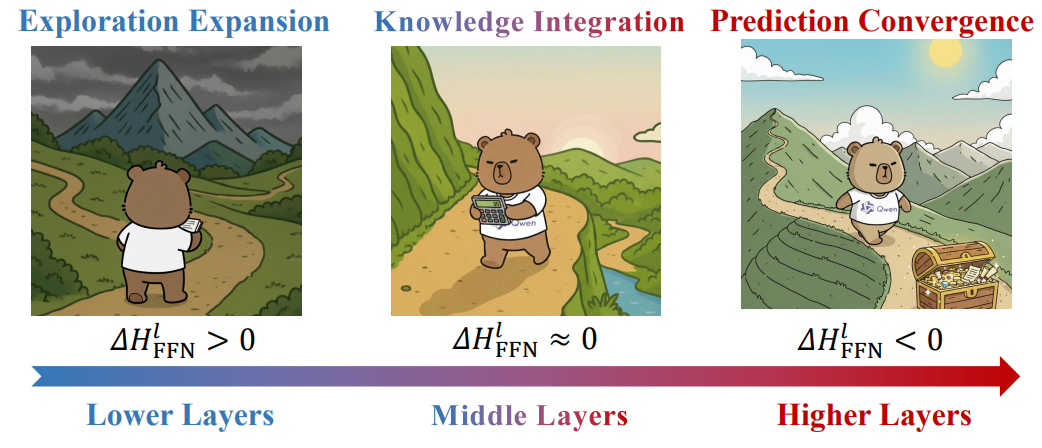

当前,大模型+强化学习成为AI领域极为热门的研究。现有的强化学习(RL)方法通常将大语言模型(LLM)视为一个单一的整体策略进行优化,主要的算法优化集中在表层的奖励设计等方面,却忽略了模型内部复杂的层级演化机制。 大模型的黑盒特征通常阻碍了我们进一步了解其内部工作机理,然而理解其如何执行内部推理能为

序章:三条哲学 在探讨技术之前,我们需要先确立三条基石性的认知: 人类的本质:人类在生物界的独特性在于高等智慧,而人与动物的分野,在于制造与使用工具的能力。 大模型的定位:ChatGPT 标志着人类首次赋予机器高等智慧。大模型之于现代人类,如同智慧之于原始人类,不仅不可或缺,更不可退化。 Agent

作者:大润发杀鱼工 https://zhuanlan.zhihu.com/p/1985812420770428370* 前情提要 窝趴在电脑前下棋的我,突然被微信里 junrong 老师Q到了,说知乎上又刷到了我去年的年终总结,还问我今年什么时候写。ahhh,其实本来是有想写的,可惜这个班害人不浅,

作者: ZxZhao,复旦大学集成电路与系统设计博士 https://zhuanlan.zhihu.com/p/1988221694591128167 大模型部署技术的演进太快了,相信有很多朋友两三年没有关注这个领域,对相关的名词已经是一头雾水了。这篇文章以杂谈的形式,和大家聊聊这里的几个关键技术节

.png)

作者:唐杰 https://weibo.com/2126427211/5247011059141988 最近的一些感悟,分享一下,希望对大家有用。 1、预训练使得大模型已经掌握世界常识知识,并且具备简单推理能力。更多数据、更大参数和更饱和的计算仍然是scaling基座模型最高效的办法。 2、激活对齐

-obJS.png)

作者:天晴 https://zhuanlan.zhihu.com/p/1986921621240447760 用 RL 做后训练 LLM 时,探索效率和训练稳定性是两个最核心的问题。这半年,我积累了不少心得感悟,也踩了很多坑。由于打算金盆洗手不再做这方面的工作了,索性把这些经验分享给大家。 当然,这

作者:初级程序员 https://zhuanlan.zhihu.com/p/1978480903136245222 本文面向已了解强化学习中策略梯度(policy gradient)、优势函数(advantage)、重要性采样(importance sampling)等概念的读者,重点对大模型强化学

.png)

本文作者来自小米大模型 Plus 团队,共同一作为张少杰、张若嶒、付培,通讯作者为多模态感知方向负责人罗振波。 在打造智能数字助手的过程中,让智能体像人类一样自然地理解并操作图形界面是一项核心难题。尽管多模态大模型与强化学习微调推动了智能体的进步,但其交互逻辑与真实的人机交互仍存在明显差距。 为缩小

-KKeY.png)

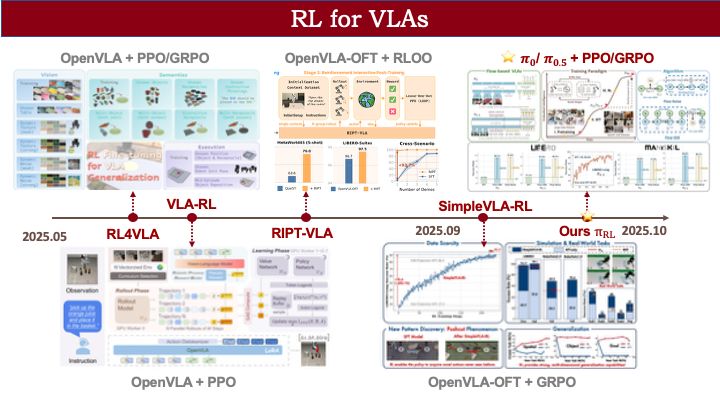

视觉-语言-动作 + 强化学习:VLA+RL 最新研究全景(含论文、链接与代码) 随着基于大规模模仿学习的视觉-语言-动作 (VLA) 模型取得显著进展,将 VLA 与强化学习 (RL) 相结合已成为一种极具前景的新范式。该范式利用与环境的试错交互或预先采集的次优数据,进一步提升机器人的决策与执行能

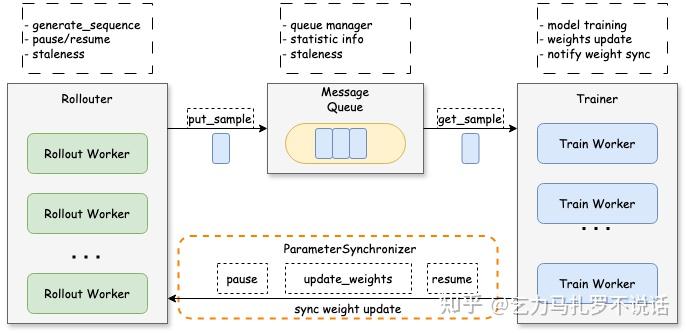

作者:乞力马扎罗不说话 https://zhuanlan.zhihu.com/p/1978600046514685178 这篇博客想法诞生于上半年基于 trl / verl 魔改 agentic rl 时期,但拖延一直搁置。眼看相关技术栈演进速度惊人,再不发出来就要过气了,于是决定抛砖引玉分享。预计

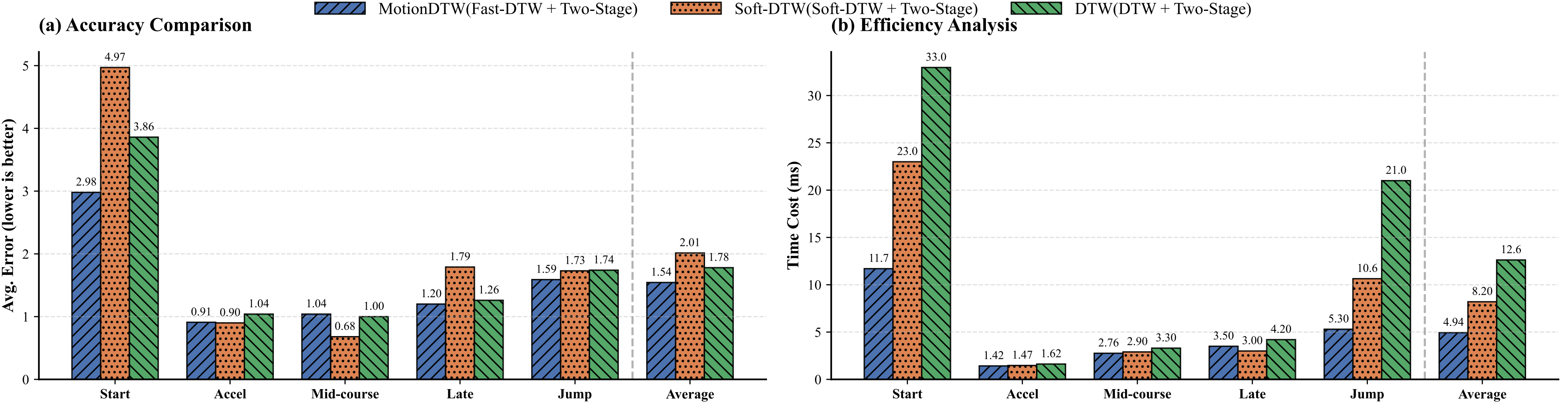

在AI席卷各行各业的今天,体育圈的“智能化”走到哪一步了?现有的智能体育系统,大多还停留在“打分+可视化”的阶段。屏幕上画出的骨骼线很酷,但对于运动员和教练来说,往往面临一个尴尬的灵魂拷问:“我知道我动作不对,分很低,但为什么不对?我该怎么练才能提高?” 通用大模型(如 GPT-5)虽然在自然语言交

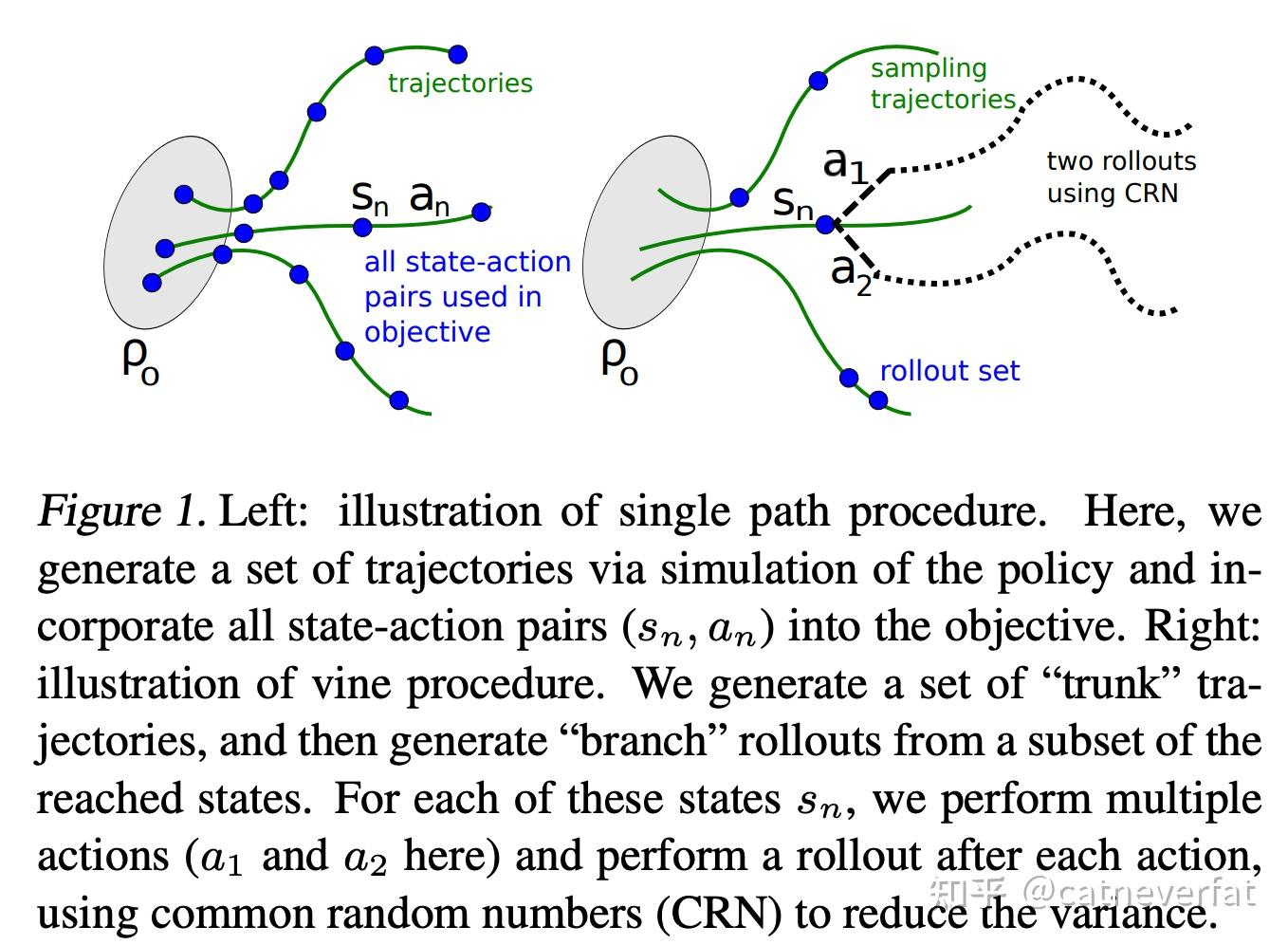

作者:catneverfat https://zhuanlan.zhihu.com/p/1908671543476749557 PPO是一种被广泛应用于各个场景下的强化学习算法,笔者之前对它展开过介绍。但是当时主要的理论推导集中在Policy Gradient部分,对PPO主要介绍的是它的目标函数以

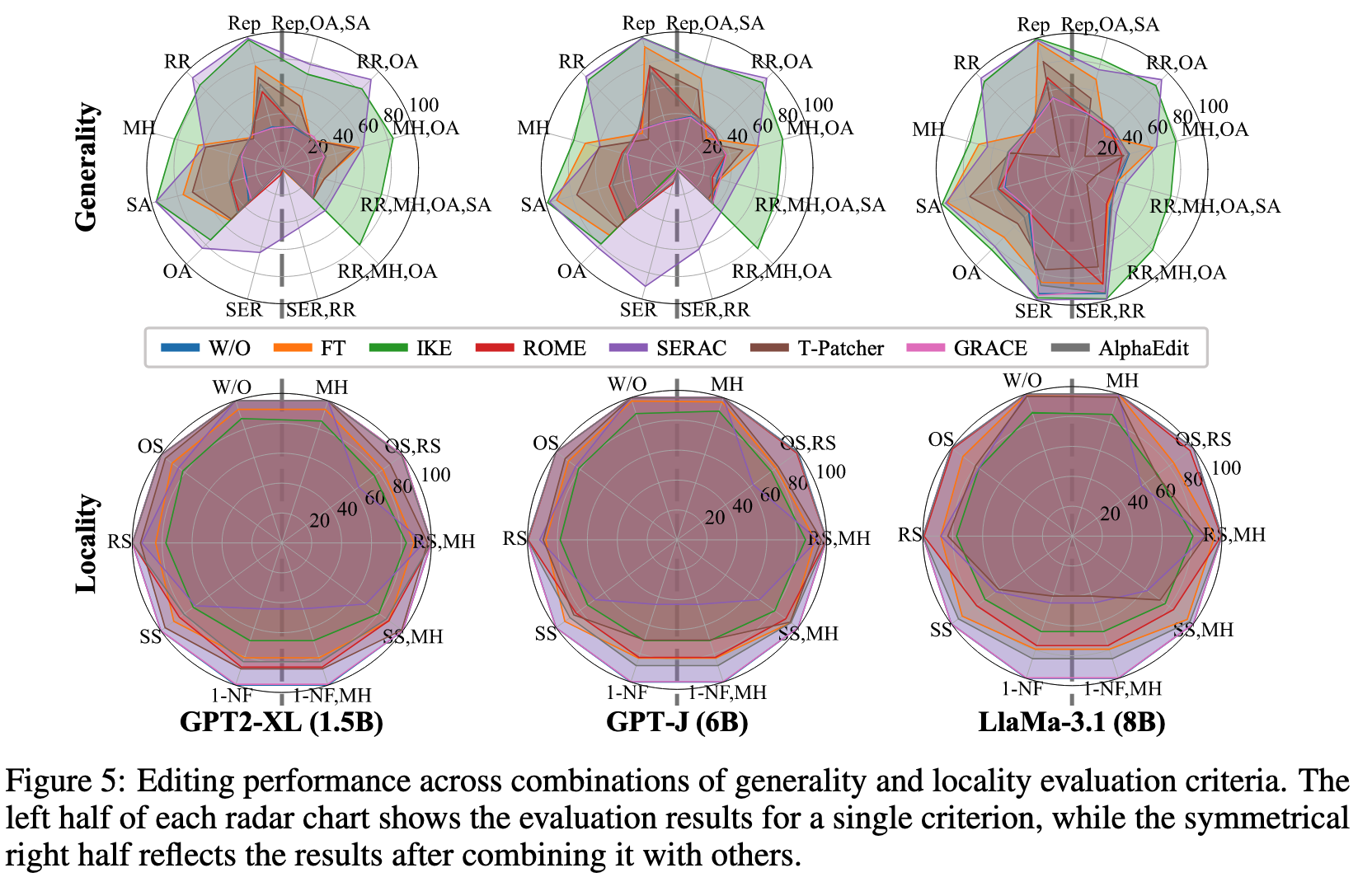

随着大语言模型(LLM)的广泛应用,它们在医疗、金融、教育等关键行业扮演着愈发重要的角色。然而,一个被忽视的现实是:大模型的知识并不会自动更新,更不总是准确。当模型输出过时信息、错误事实甚至自信满满的“胡说八道”时,如何快速、精准、低成本地纠正它?知识编辑(Model Editing)因此成为近年来

生成式视频模型正以前所未有的速度进化,从数秒短片拓展至长时段叙事,从模糊低清跃升至逼真4K。然而,随着视频时长和空间分辨率的提升,序列长度急剧增加,二次复杂度的注意力计算量随之飙升,即便采用 FlashAttention 等高效优化,推理延时仍然难以遏制。以生成一段 720p、5 秒的视频为例,单是

.png)

作者:Cyril-KI 原文:https://zhuanlan.zhihu.com/p/1982850692340273471 一个有趣的训练现象 在SFT阶段,我们精心设计”Let’s think step by step”提示,成功诱导出丰富的思维链。然而进入RL阶段后,Wandb监控曲线显示R

.png)

1、VLM 做 AD 的头部问题:(1)幻觉问题,具体表现为无中生有、视而不见;(2)3D 空间理解能力不足;(3)速度慢。 幻觉问题的原因:静态感知。解决方案:动态感知,例如通过多次校验减少训练数据中的幻觉;例如通过 DPO 减少训练模型时产生的幻觉。例如允许模型“回头放大看看”。 3D 空间理解

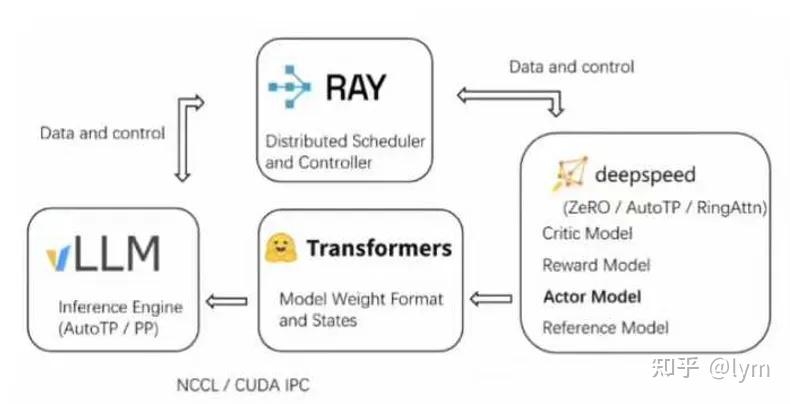

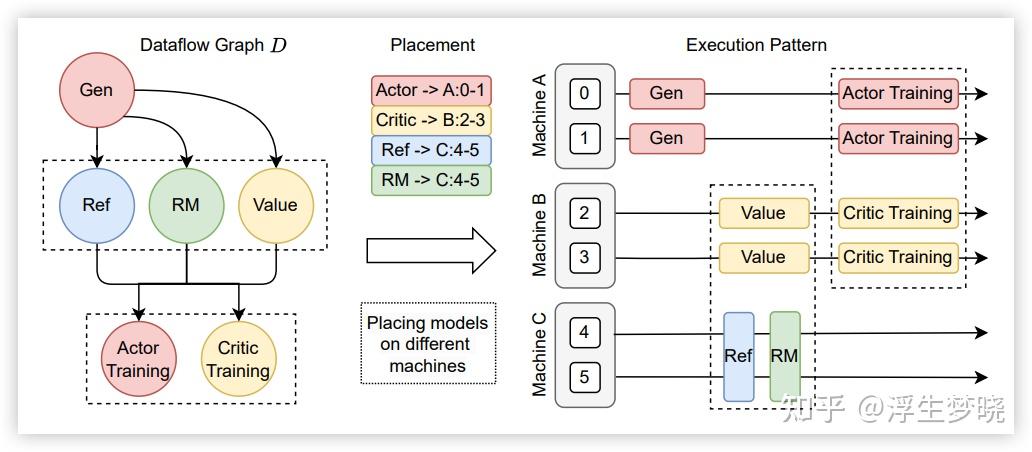

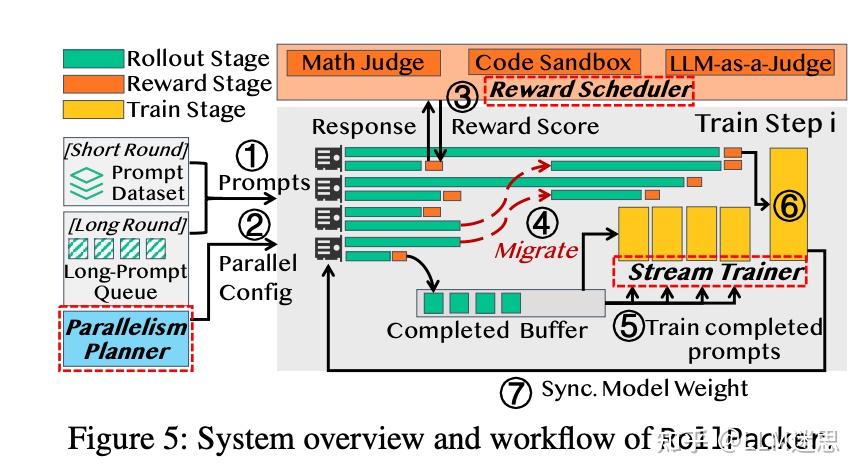

作者:浮生梦晓 https://zhuanlan.zhihu.com/p/1979237927641949997 前段时间调研了一些 RL 训练框架,目前开源社区的 RL 训练框架可以说百花齐放,老牌的有 openlhf、trl、unsloth、verl。还有今年新开源的 slime、AReaL、R

完整PPT下载:【https://t.zsxq.com/gXFFx】 在往期 Talk 分享中,RLinf 团队的林灏、臧宏之分别为大家讲解了 RLinf 的系统设计以及 RLinf VLA 的实践。本期 Talk 我们继续和 RLinf 团队、北京大学博士生陈康一起聊一聊面向流匹配 VLA 的强化

本工作于字节跳动完成。首次发布于2025年9月17日。 原文:https://richardli.xyz/rl-collapse 图1. 我们在Qwen3-14B-Base上进行的四次失败的GRPO TIR实验的奖励(左)和gradient norm(右)。所有实验在每个训练步骤采样 1024条轨

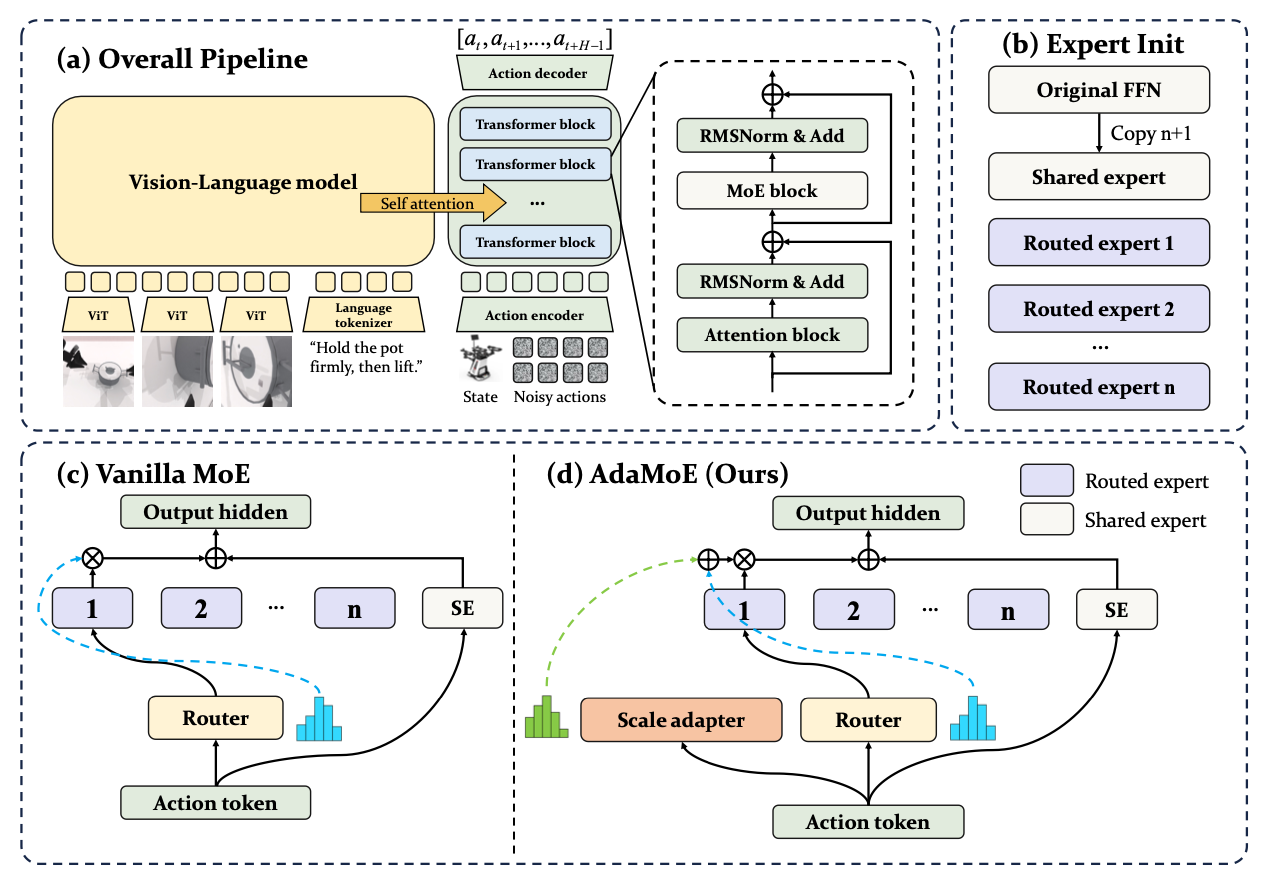

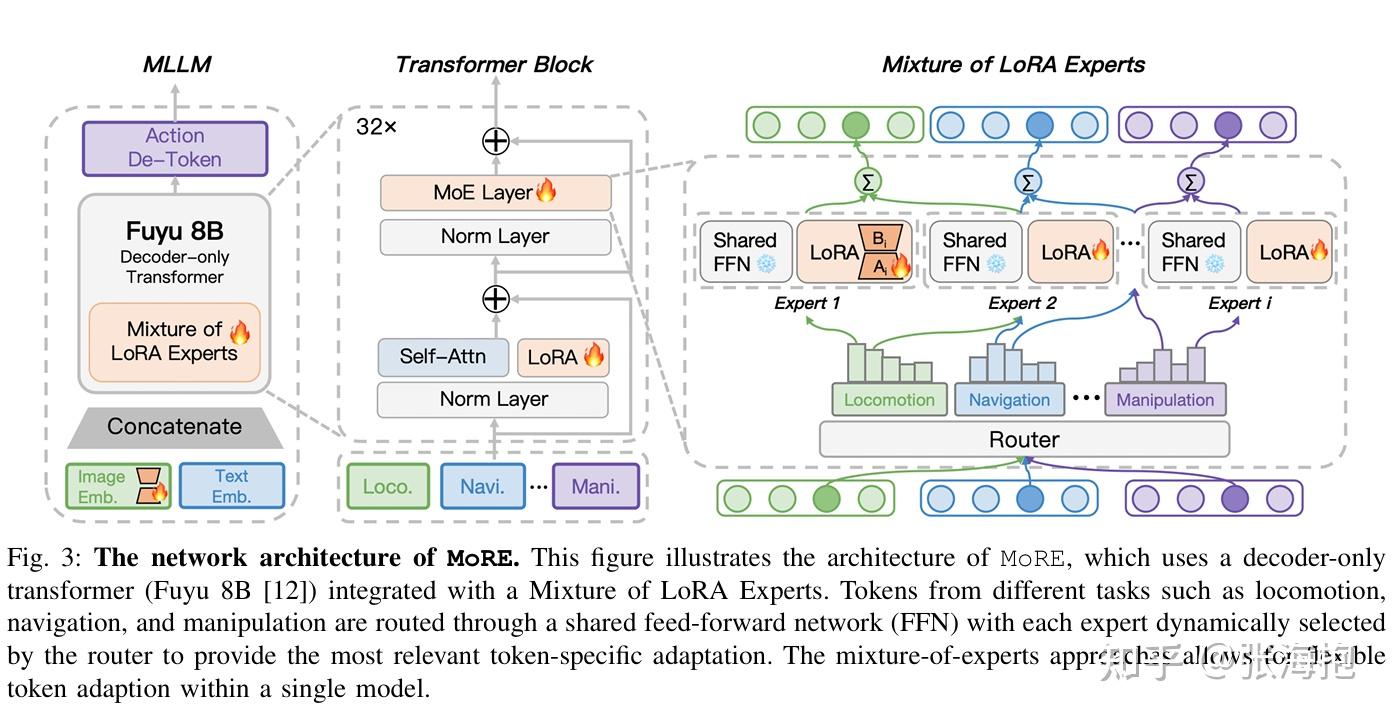

作者:小红师兄 https://zhuanlan.zhihu.com/p/1980358735869268796 今天聊聊AdaMoE(VLA),先用一句话概括一下:AdaMoE 这篇论文想解决的是「在 Vision-Language-Action (VLA) 模型里用 Mixture-of-Exp

.jpg)

最近几个月在各种场景上做了大量的agent RL训练,例如search agent, 数据分析agent 等等。既有小的dense model,也有大的moe。有单一数据场景,有多源合板数据场景。有失败的经历,也有成功的经历。这里抽空分享下一些感悟,比较乱,随便看看就行: 1、稳定性是工业级场景下R

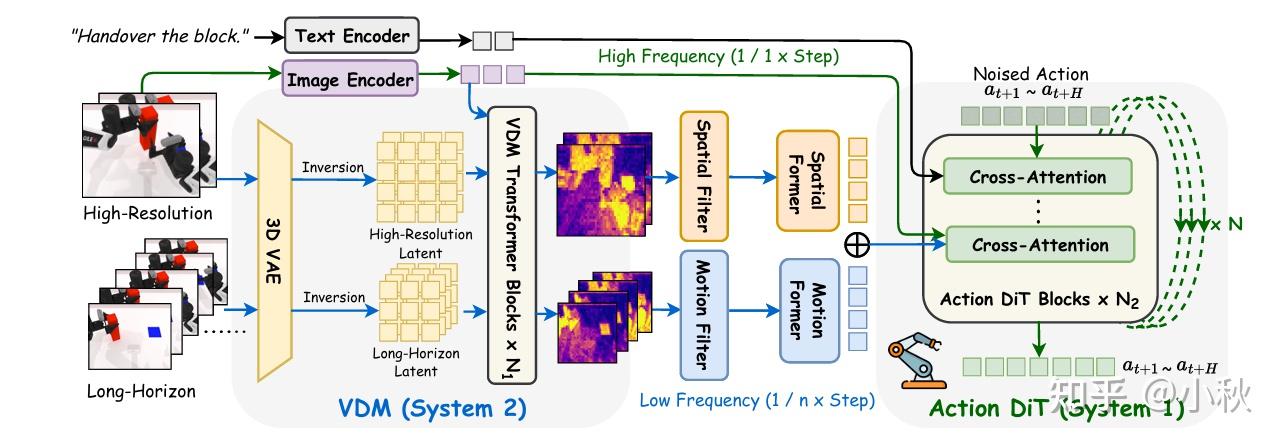

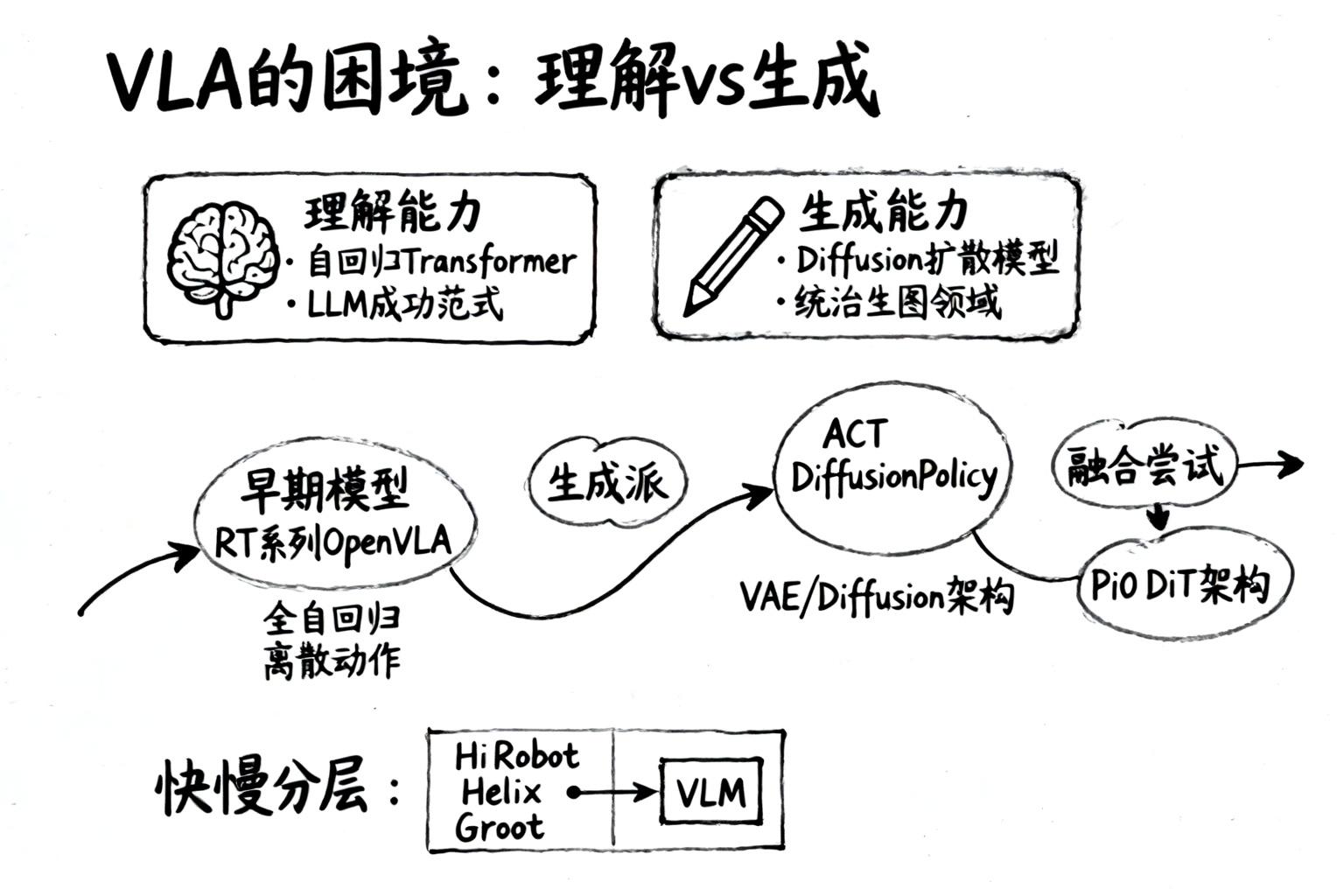

作者:小秋 https://zhuanlan.zhihu.com/p/1979682819170145066 前言 快慢双系统早已不是第一次在具身智能里被提出来了。 从 Daniel Kahneman 的《思考,快与慢》到机器人,大家都在拿 System 1 / System 2 打比方:一个负责“

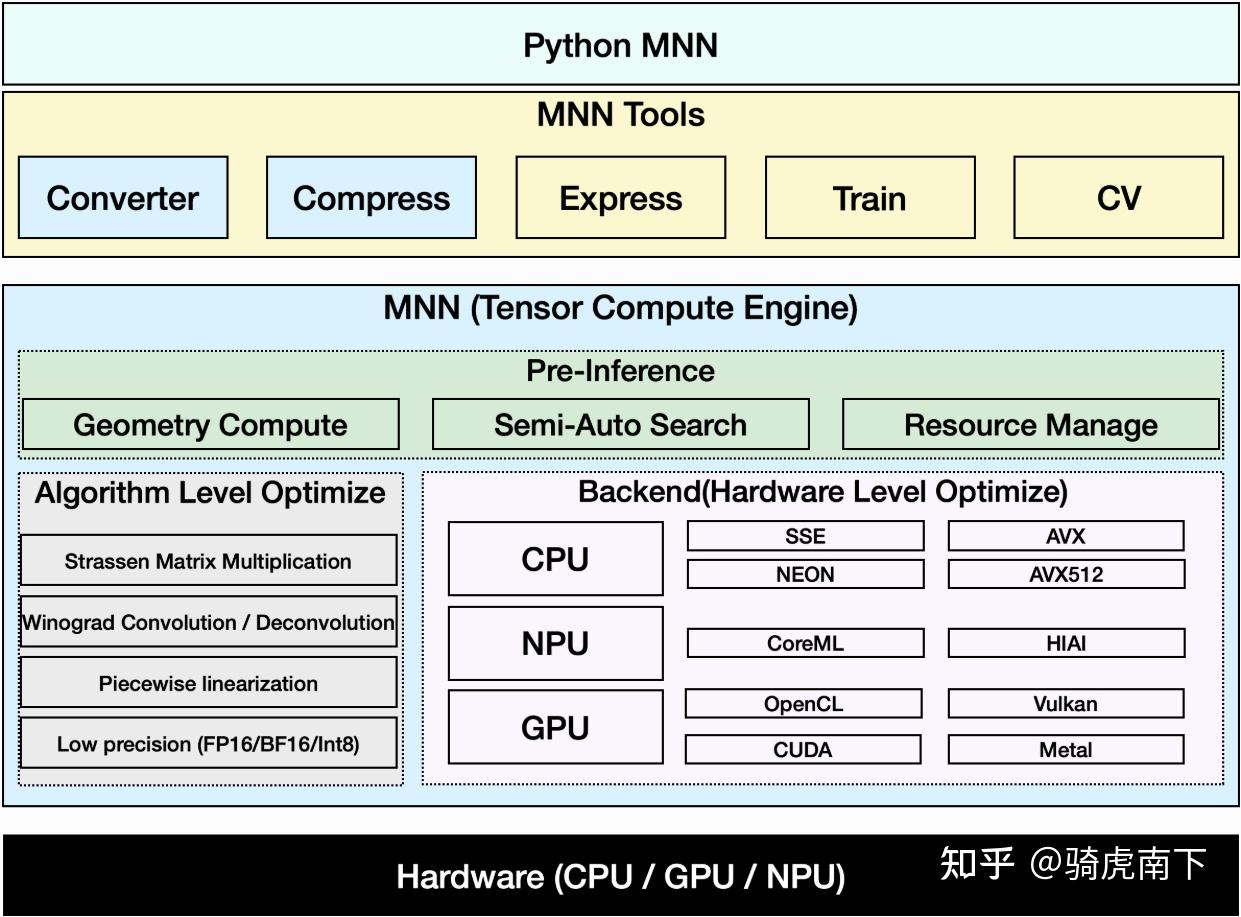

作者:骑虎南下 https://zhuanlan.zhihu.com/p/1931235792501608813 这里,分两个主要模块介绍AI模型推理引擎整体架构与主要功能。回顾AI落地的发展过程,我们可以简单地将AI模型的发展分为小模型领域与大模型领域。 在小模型领域以CNN模型为主,模型结构变化

作者:张海抱 https://zhuanlan.zhihu.com/p/1976979860405633293 最近 VLA 的一大研究趋势就是不再满足于 SFT,而是也要上 RL 了。最近读了一波这方面的论文,分享一些心得。 首先,有些文献调研还是按照 online RL / offline RL

.png)

作者:东水长(已授权) https://zhuanlan.zhihu.com/p/1973206684907365344 训推不一致和异步框架 最近看到不少关于大模型强化学习中“训推不一致”和“异步训推框架”的讨论,我自己的直觉是:这些看上去复杂多样的问题,很大一部分其实都围绕着一个更基础的矛盾——

作者:九老师 https://zhuanlan.zhihu.com/p/1976336943878005134 最近陆续有了一些研究LLM中RL相比SFT更不容易造成灾难性遗忘的工作,清晰地指出是RL的On-Policy特性带来了参数的稳定,而SFT将模型参数推向与预训练分布差异很大的方向,导致了遗

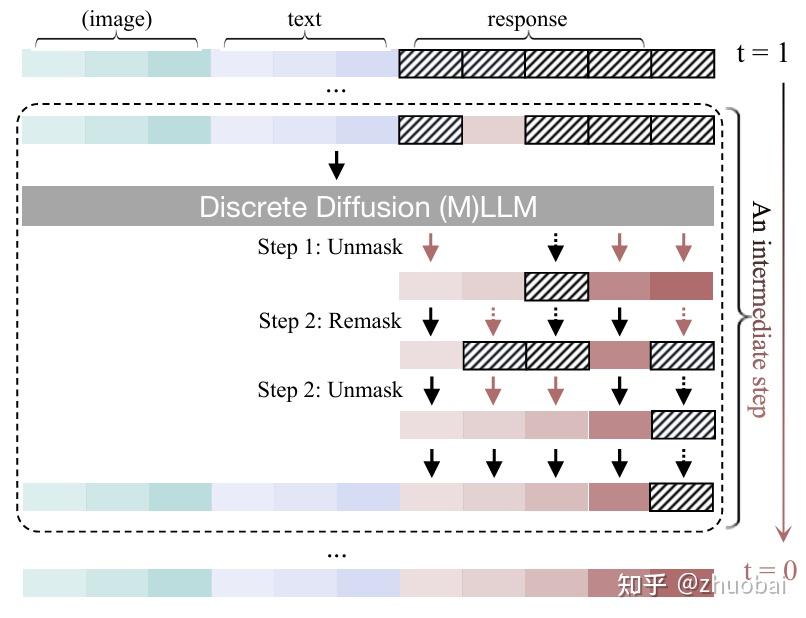

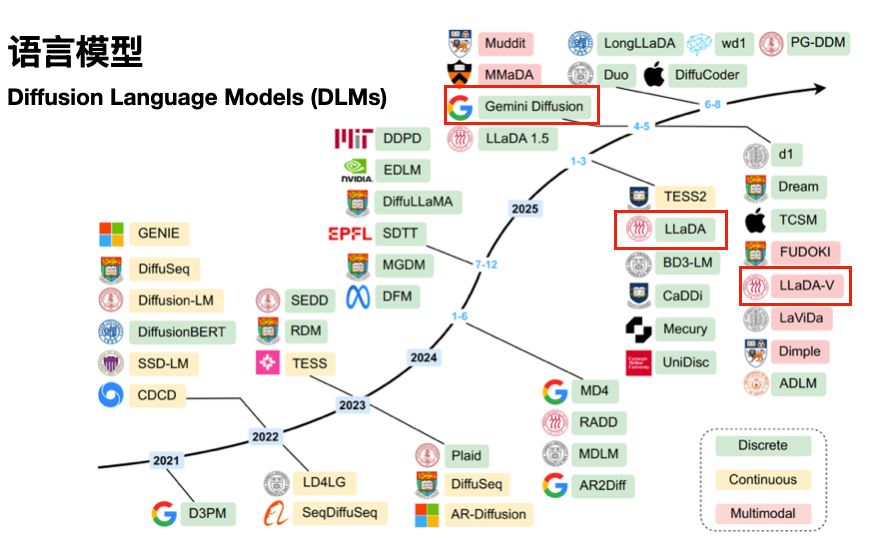

作者:zhuobai https://zhuanlan.zhihu.com/p/1935370284921263679 今天跟大家分享下前段时间阅读的来自新国立 showlab 的一篇综述: Discrete Diffusion in Large Language and Multimodal Mo

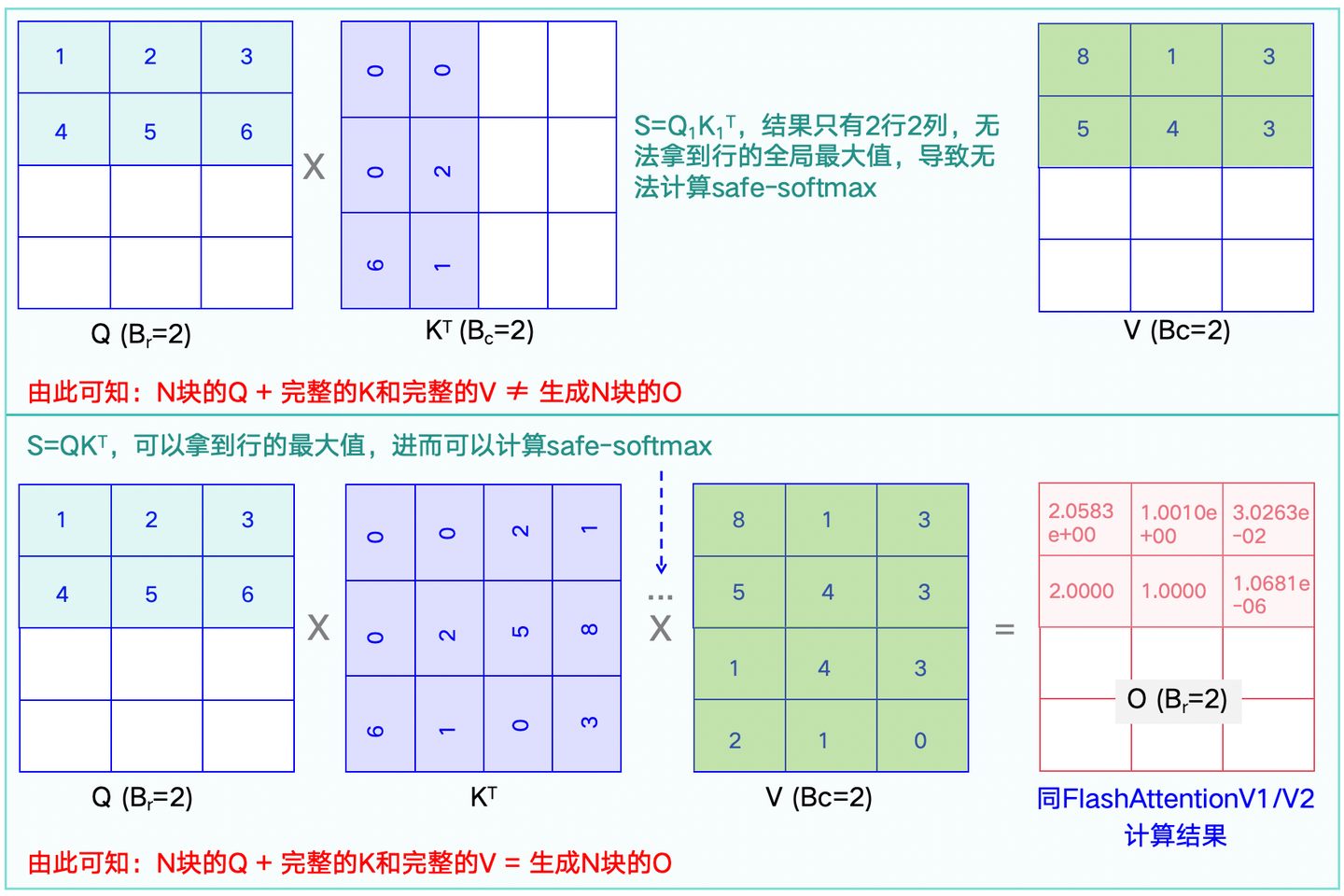

作者:假如给我一只AI https://zhuanlan.zhihu.com/p/1890132185966682238 前言:最近在学习LLM的分布式训练,看到Attention计算相关加速方法是其中重要的一环,虽然之前也碎片化学习过,但已然模糊了,本次系统总结下。本文第一章节讲解FlashAtt

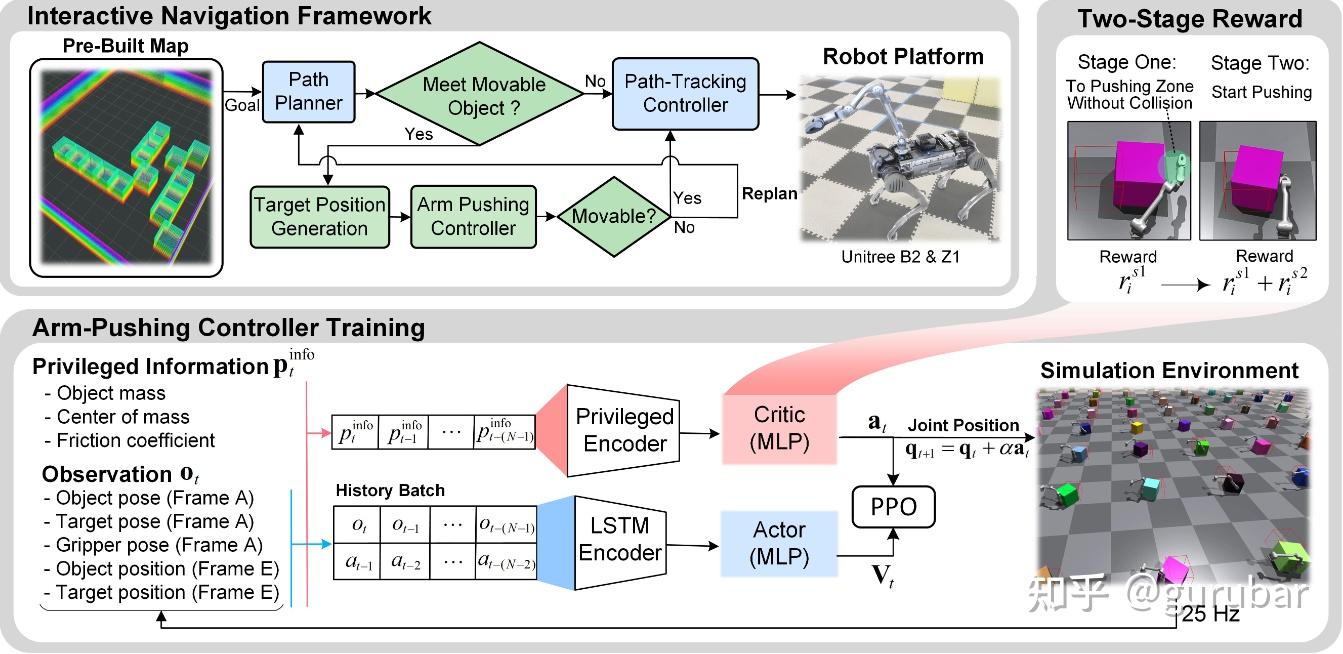

作者:gurubar 原文:https://zhuanlan.zhihu.com/p/1974055240048345546 为什么World Model 在Robotics领域中非常重要? 从理论与认知科学角度,Schmidhuber 等人长期主张“智能 = 学会一个可压缩、可预测的世界”;Ha

作者:Chengru's Blog https://hypercool.cn/ai/ai_algorithms/vision/2025/08/19/dpo-rl.html 前言 过去的一个月在比较高强度做RL,最近终于有了一些阶段性成果,整理了一下整体的迭代思路和最近踩过的坑,分享出来,与各位共勉。

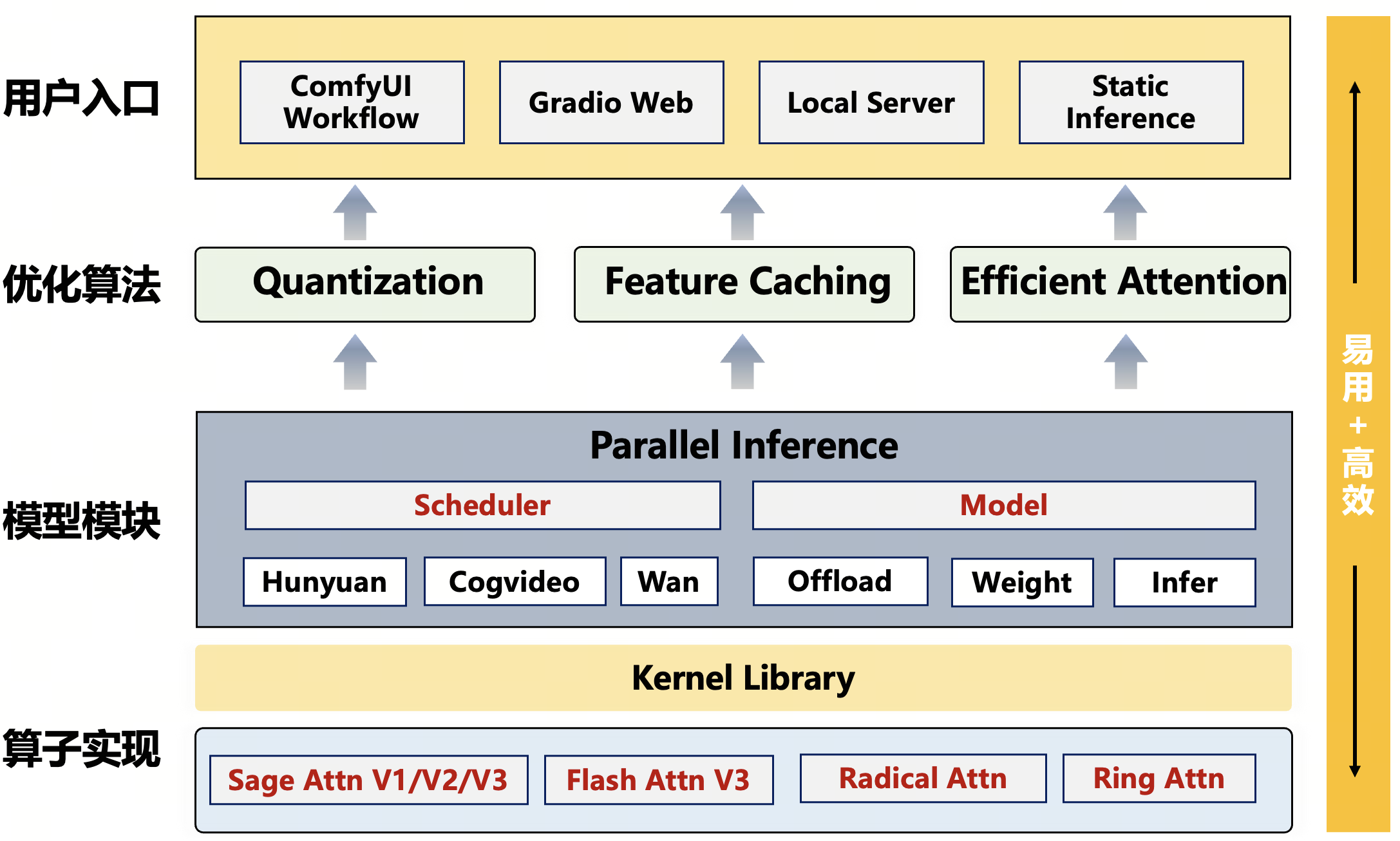

LightX2V:AI视频创作迈入实时生成时代 就在刚刚,HunyuanVideo 1.5模型正式开源,其官方页面展示了LightX2V视频生成推理框架作为首发支持方案,助力该模型在消费级显卡上实现秒级视频生成。 LightX2V源自ModelTC Github社区,其LightLLM、LightC

作者:RuYy https://zhuanlan.zhihu.com/p/1966633724058793147 最近一年都关注着Diffusion领域,与大红大紫的DiT-based视觉生成模型的不同,扩散语言模型(Diffusion Language Models,DLMs)颇有隐而不发之意,虽

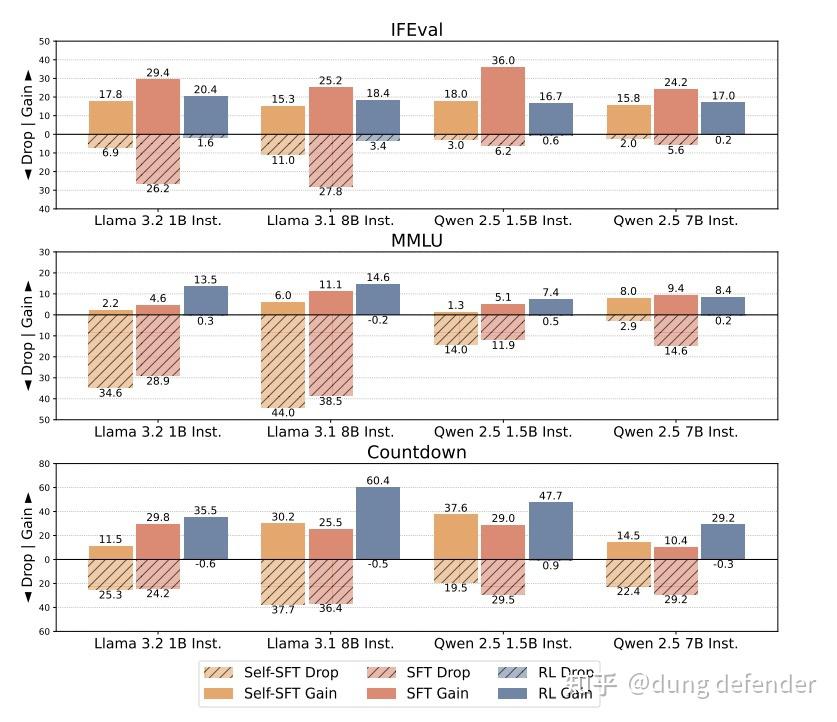

作者:dung defender https://zhuanlan.zhihu.com/p/1974143141406864151 论文:Retaining by Doing: The Role of On-Policy Data in Mitigating Forgetting 链接:https:

作者:披头与枪花 https://zhuanlan.zhihu.com/p/1968757538867647052 《Defeating the Training-Inference Mismatch via FP16》 https://arxiv.org/pdf/2510.26788 这篇论文直

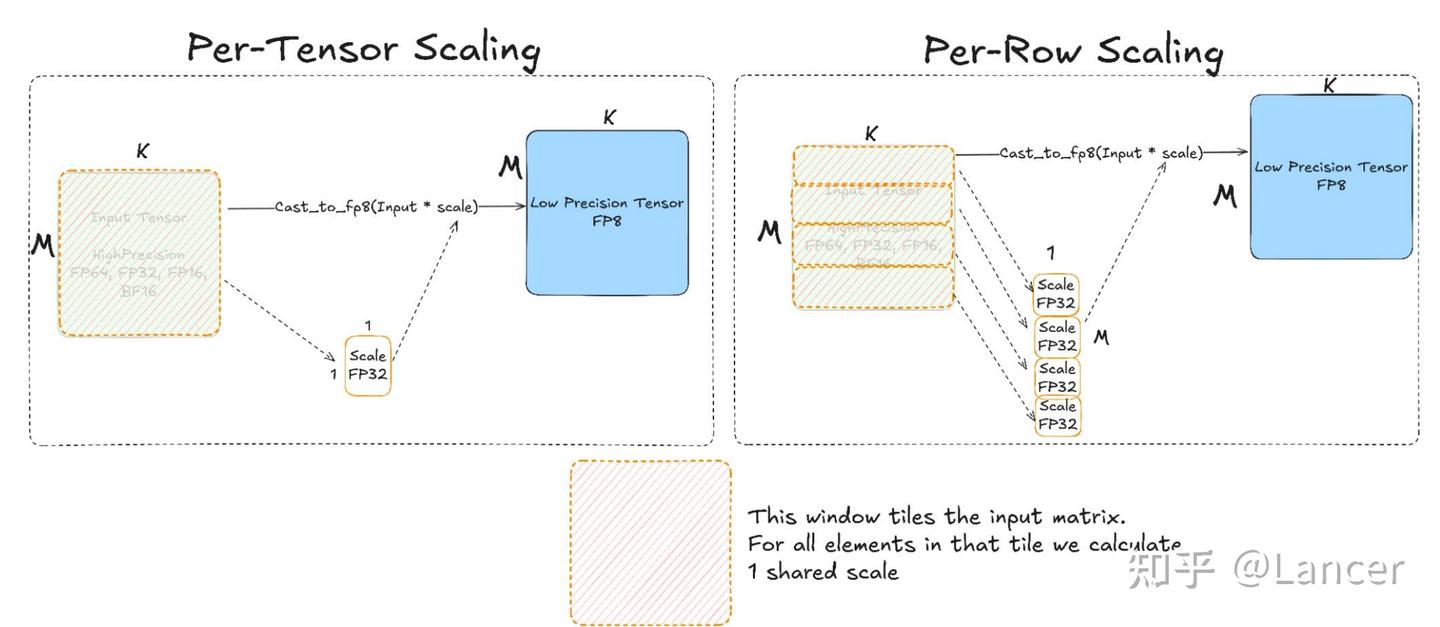

作者:Lancer https://zhuanlan.zhihu.com/p/1969465397670551963 一、 为什么需要mxfp8、mxfp4、nvfp4等低精度格式? 1.大模型规模爆炸式增长 → 计算与内存瓶颈加剧 LLM 参数量已达万亿级别,训练 FLOPs 超 10²⁵。 传统

作者:Zhennan https://zhuanlan.zhihu.com/p/78268350517 本文主要介绍 DPPO 及后续相关工作的进展,有任何补充欢迎在评论区给出,同时由于篇幅原因,本文会尽可能地写文章的 insights 以及输出我个人的观点,而不会花太多篇幅讲具体的方法论 Diff

作者:宇宙哇 https://zhuanlan.zhihu.com/p/1969545638023767020 《Kimi Linear: AN EXPRESSIVE, EFFICIENT ATTENTION ARCHITECTURE》,这篇论文提出了一种新的注意力架构,试图解决当前大模型在处理长文

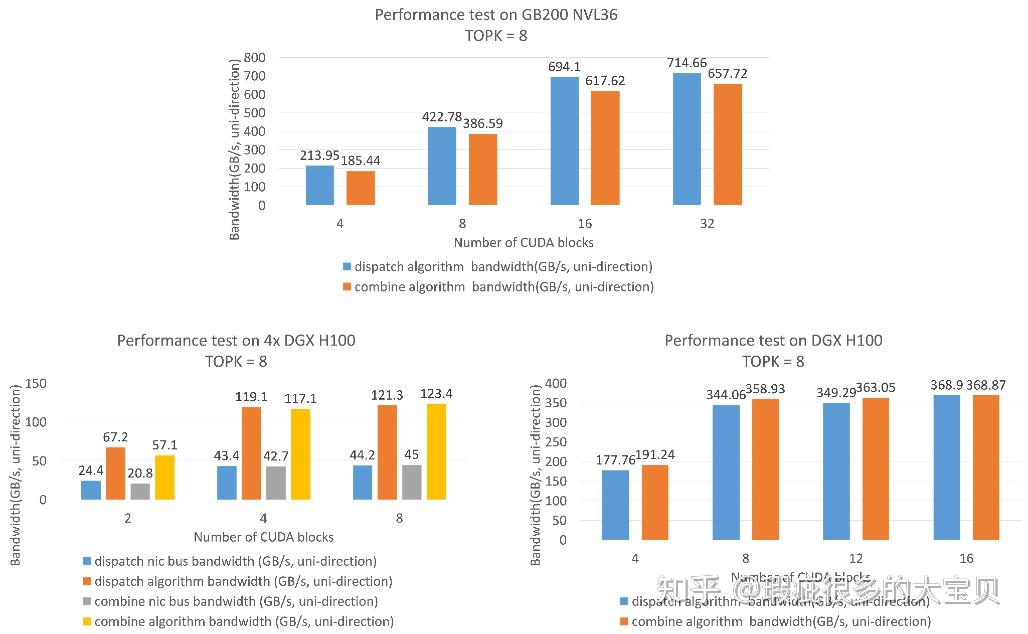

作者:瑕疵很多的大宝贝 https://zhuanlan.zhihu.com/p/1965822436948842025 声明:本文翻译自NVIDIA Megatron Core Dev Blog:Optimizing DeepSeek-V3 Training Performance on NVID

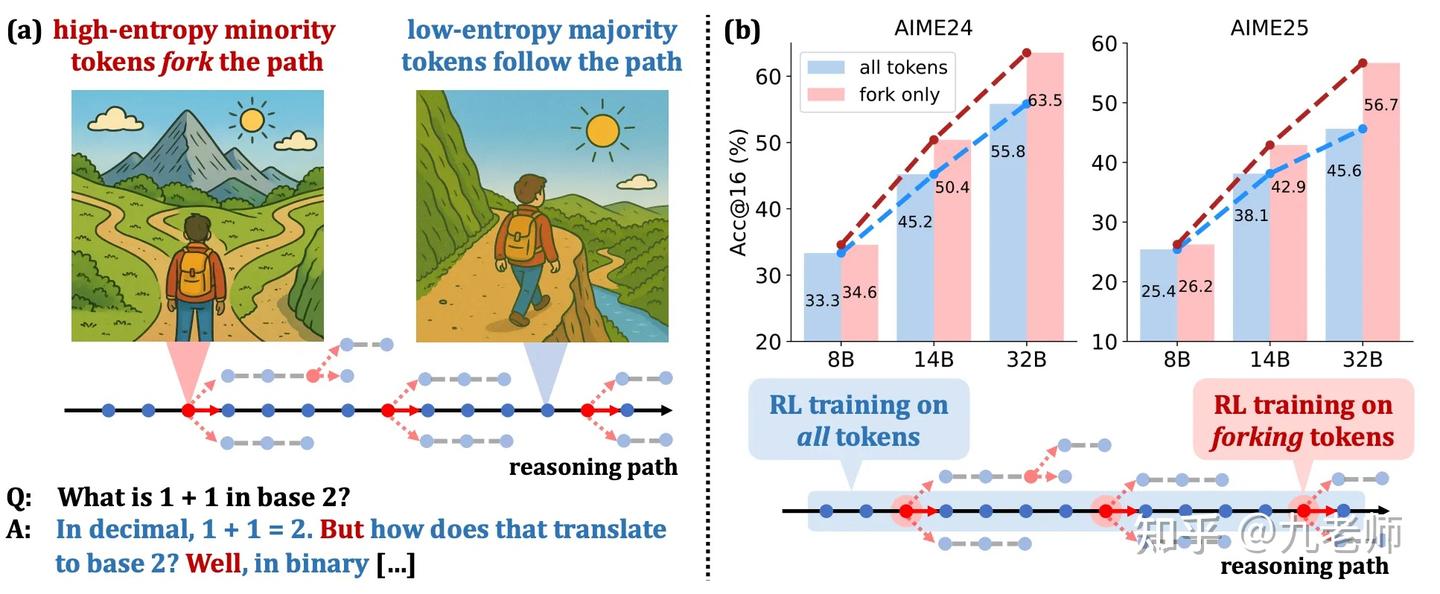

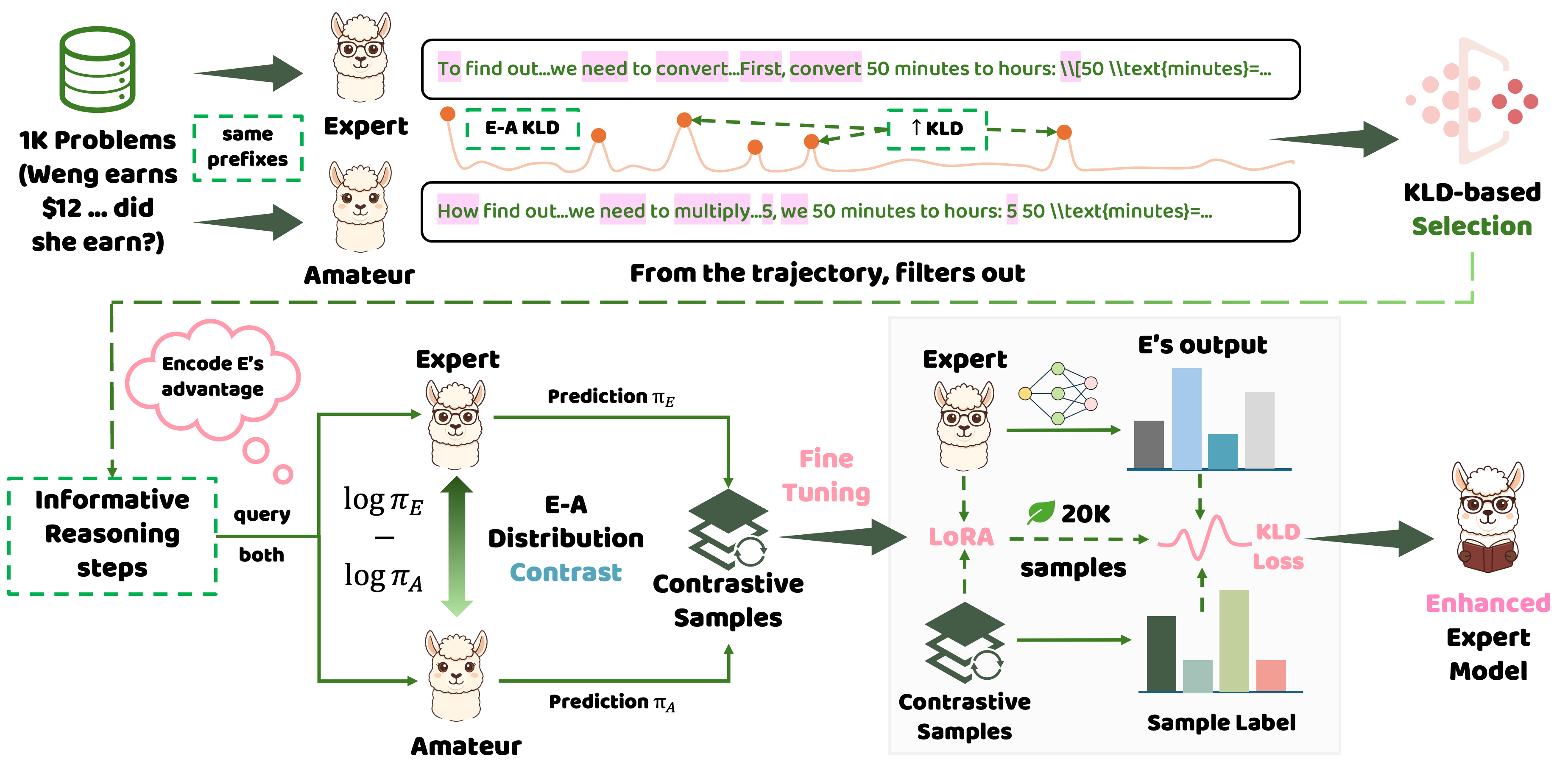

港大提出LightReasoner:让小模型教大模型“关键推理”,效率提升90%! 今天要和大家聊一篇非常有意思的工作——LightReasoner。 这篇由香港大学发表的最新论文,挑战了AI界一个习以为常的认知:“大模型一定比小模型强,小模型只能被教导,不能当老师。” 结果他们发现:小模型不仅能够

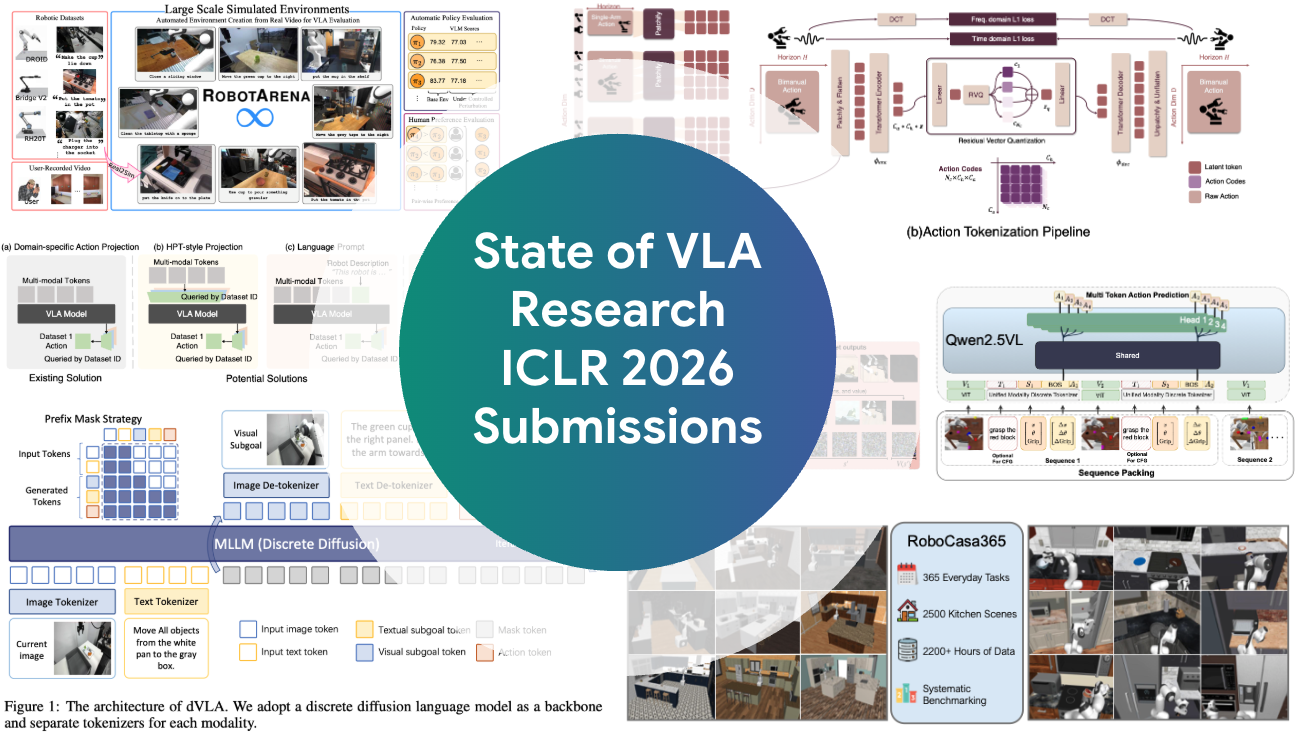

原文:https://mbreuss.github.io/blog_post_iclr_26_vla.html 本文总结了 视觉-语言-动作(VLA)模型 在 ICLR 2026 上的研究现状:什么“算作”VLA(以及为什么这个定义很重要)、当前 VLA 领域的研究热点(离散扩散、具身推理、新分词器

提到具身智能就绕不开的经典工作,自动驾驶的VLA虽然在本体确定的情况下(汽车四轮形式),也看起来只有EMMA比较合理的方案,那么来看下本体还不确定收敛的具身行业。我认为目前核心关注的应该是机械臂的操作技术突破。 (以产生和物理世界的交互,末端执行器更多使用两指夹爪、机械臂数量上的也可以任意拓展,从单

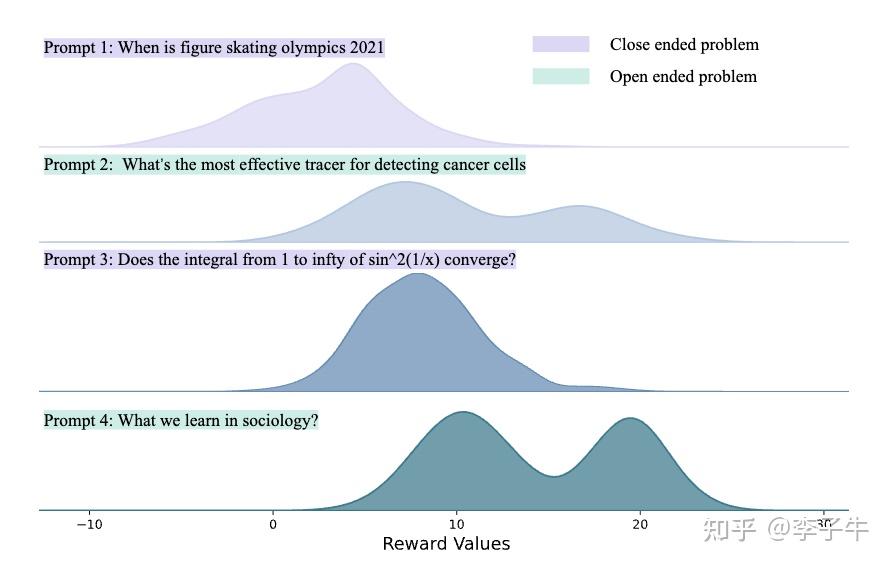

作者:李子牛 https://zhuanlan.zhihu.com/p/1963218041199387877 最近在忙毕业论文,顺便整理过去几年「大模型+强化学习」的关键进展,写了一篇综述(Review of Reinforcement Learning for Large Language Mo

作者:ybq https://zhuanlan.zhihu.com/p/1943048398333780944 这篇文章随便聊一下如今比较火的推理模型,给新入坑的同学做一些简单的科普,都是一些偏基础的知识。 推理模型的训练 推理模型的训练和普通模型的训练并无什么区别,仅仅是 sft 语料多了一些特殊

作者:ybq https://zhuanlan.zhihu.com/p/1966609550032475890 这篇文章随便聊聊 LLM RL 的一些想法。文章的灵感来自于,每次和好哥们 @真中合欢 交流 RL 训练的时候,都会被他批评一顿说不要乱加各种技巧。他成功说服了我,我也来试试看能不能说服一

作者:ning 原文:https://zhuanlan.zhihu.com/p/1967989523196667587 引言:VLA 与智能机器人的具身智能革命 Vision-Language-Action(VLA)模型是具身人工智能(Embodied AI)的核心载体,其核心价值在于打破传统机器人

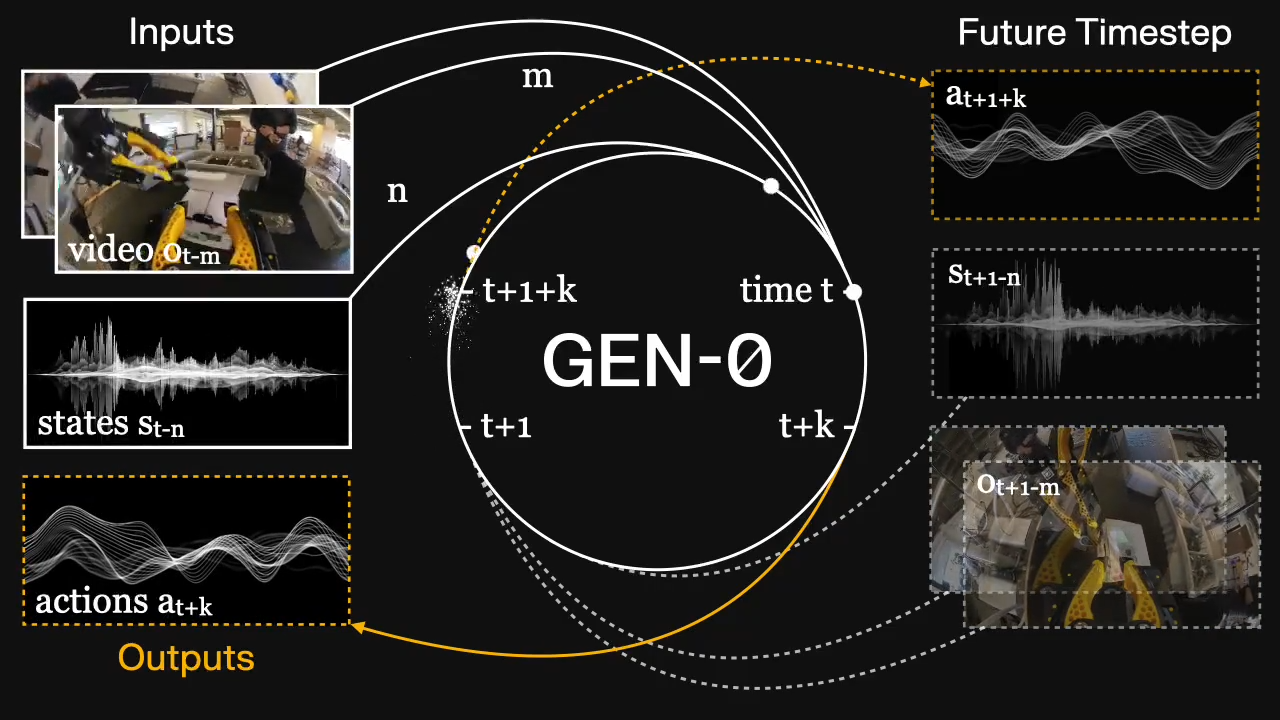

作者:阿汐 原文:https://axi404.top/blog/embodied-talk-3 GEN-0 出现的背后,我们可以从中学到什么。一些被改变,一些新的东西出现,研究还在继续。 前言 最近 GEN-0 的发布对于具身智能领域可以说是轰动性的。Manipulation 作为 Robotic

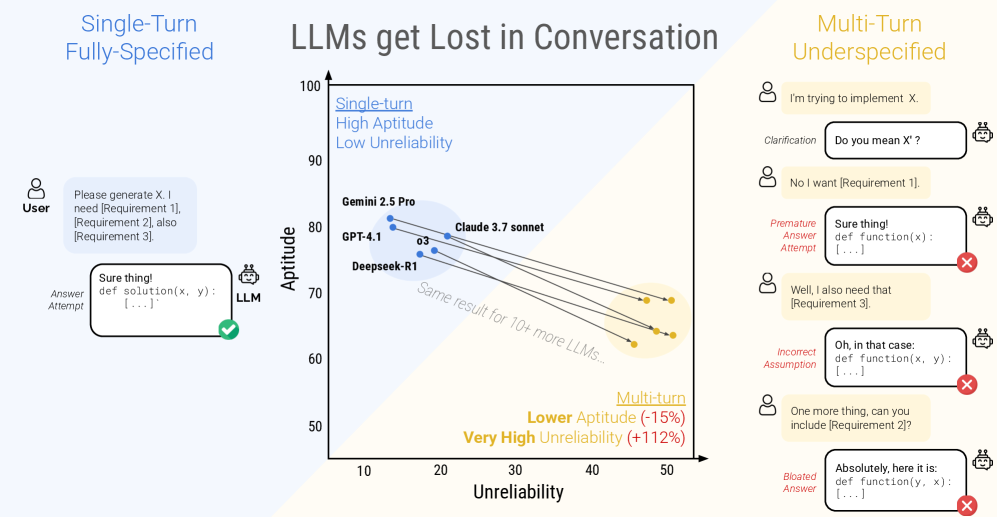

作者:木牛流码 https://zhuanlan.zhihu.com/p/1971681801295619070 引言 权威性声明:本文的核心洞见与数据,源自微软研究院(Microsoft Research)与 Salesforce 研究院(Salesforce Research)联合发表的论文《L

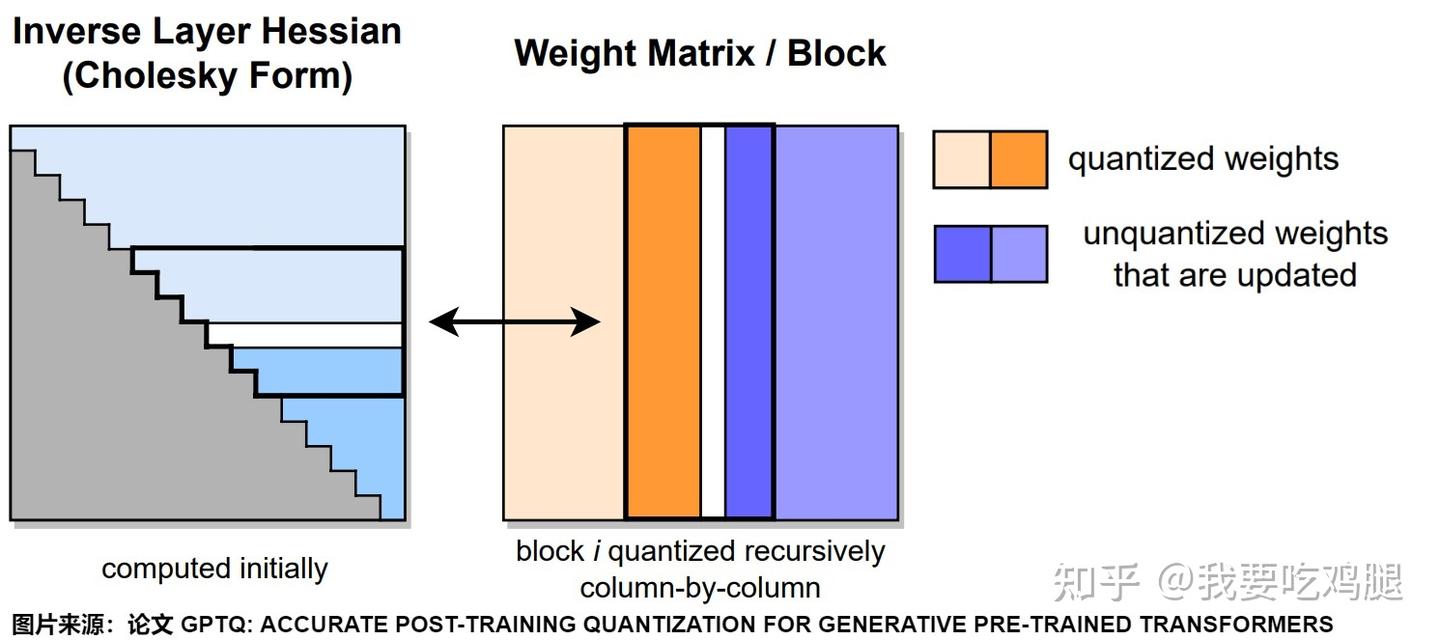

作者:我要吃鸡腿 https://zhuanlan.zhihu.com/p/1955340620299244112 4-bit量化前沿 —— 兼顾压缩与精度的黄金时代 在上一篇文章中,我们见证了8-bit量化领域三位“奠基者”的精彩博弈。它们用各自的智慧,成功地在W8A8这条路上实现了精度与效率的平

作者:张海抱 原文:https://zhuanlan.zhihu.com/p/1940702256241575450 写在前面 VLA 时代的强化学习和 Atari 时代的强化学习有什么区别?个人认为有一好两坏两个方面。 好的方面是我们现在有一个非常有用的资源 —— 预训练的大模型,它可以对我们的探

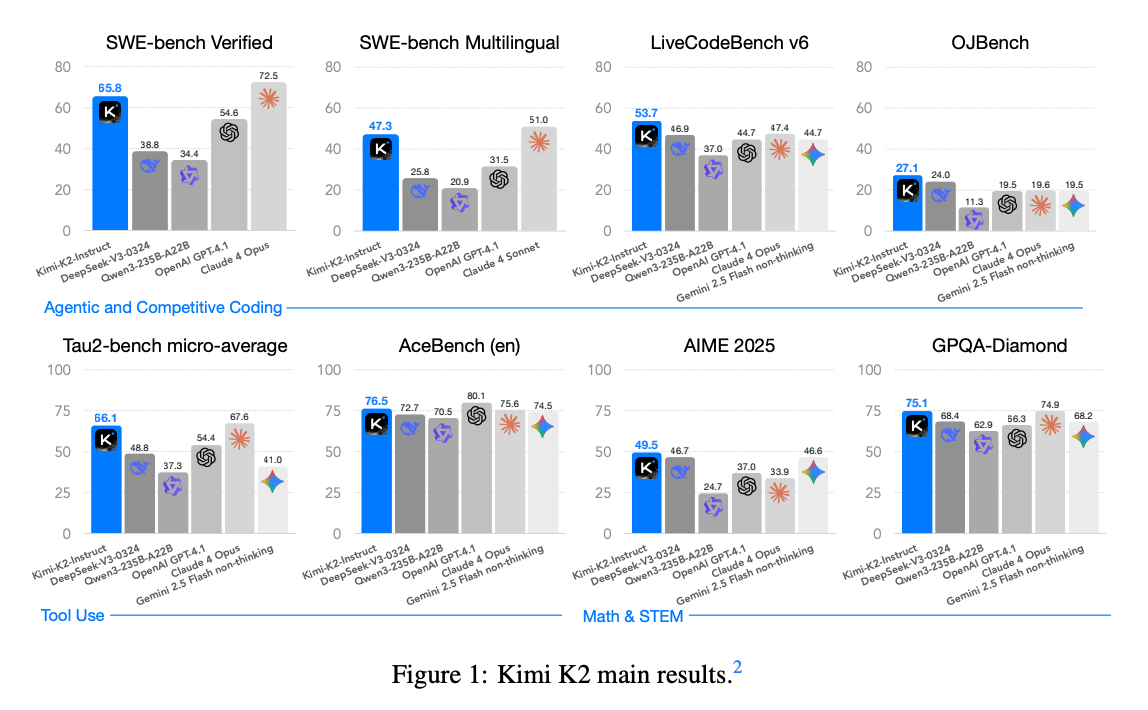

论文地址:https://arxiv.org/abs/2507.20534 Kimi k2 做了哪些优化? Kimi K2 不是传统的 “单一大模型”,而是一种叫 “混合专家(MoE)” 的架构 —— 可以理解成 “一群专家分工干活”: 总参数有 1 万亿,但每次实际工作时,只激活 320 亿参数(

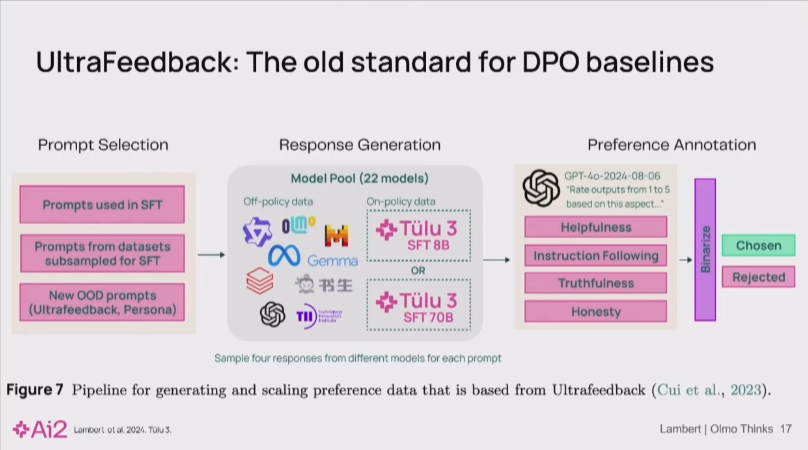

作者:JayNing https://zhuanlan.zhihu.com/p/196909645458175683 本文是Nathan Lambert在PyTorchCon 2025分享训练开源的Olmo-Thinking模型的文字笔记, 内部加入了笔者的一些批注和思考 Nathan Lamber

作者:刘少伟 链接:https://www.zhihu.com/question/1969558404759544488/answer/1970539327902679960 Kimi K2 Thinking 是基于**「模型即 Agent」理念训练的新一代 Thinking Agent,它原生掌握

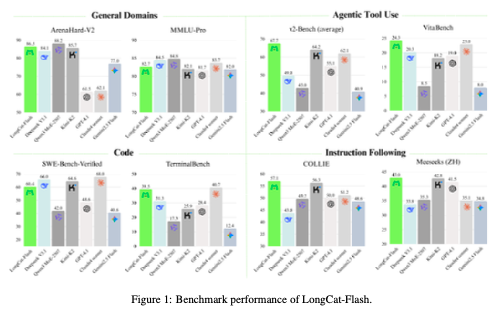

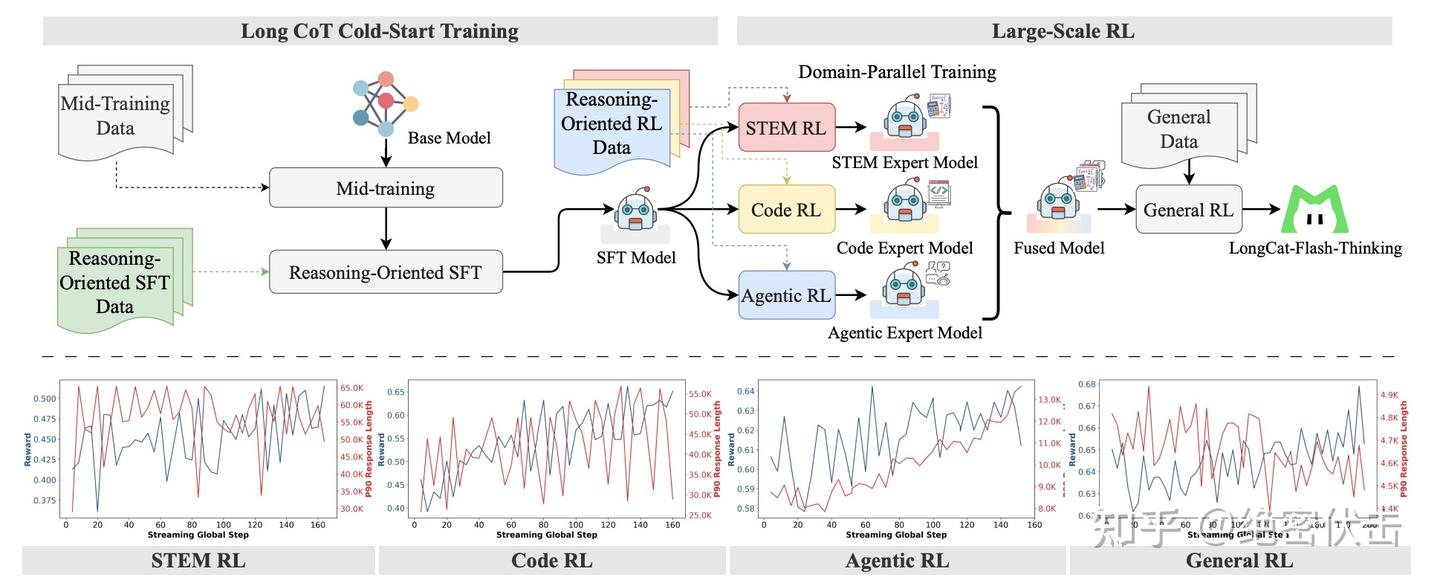

摘要 我们推出了 LongCat-Flash,一个拥有 5600 亿参数的专家混合 (Mixture-of-Experts, MoE) 语言模型,旨在兼顾计算效率与先进的智能体 (Agentic) 能力。为满足可扩展效率的需求,LongCat-Flash 采用了两项新颖设计: a) 零计算专家 (Z

作者:绝密伏击 https://zhuanlan.zhihu.com/p/1954613742634504507 技术报告:LongCat-Flash-Thinking Technical Report 链接:https://github.com/meituan-longcat/LongCat-Fl

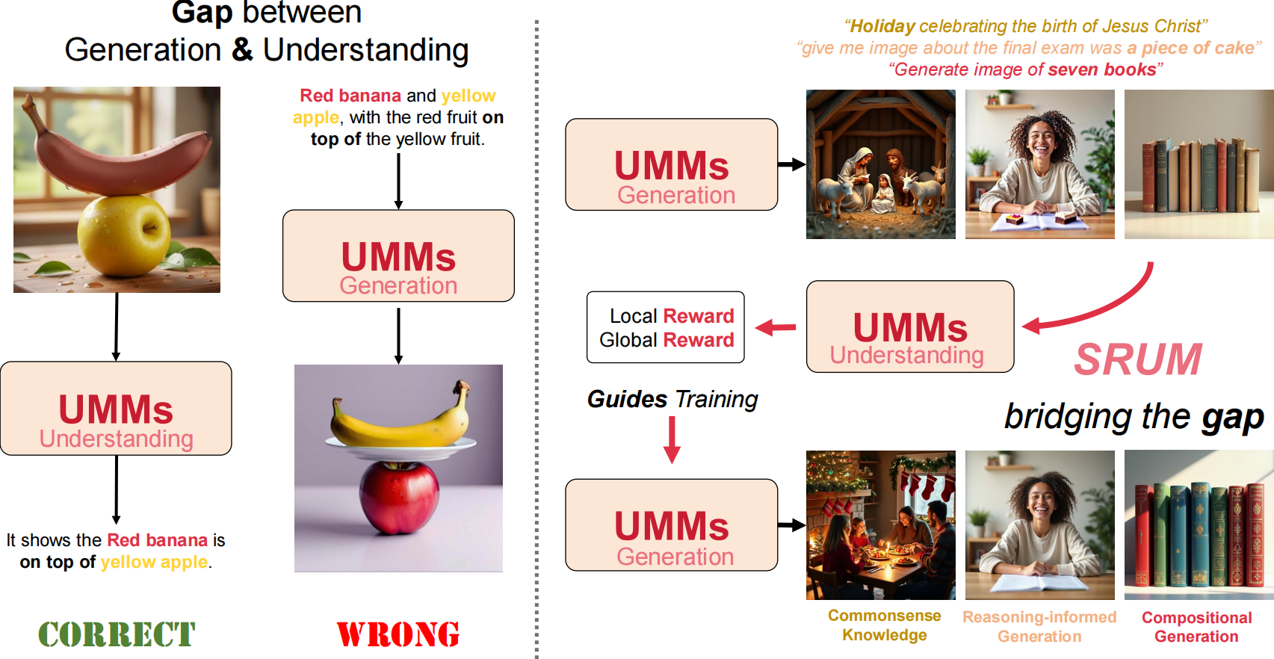

作者:金伟阳,HKU博士生 TLDR SRUM是一个非常直接的后训练方法,其动机在于:当前生成理解统一模型(UMMs)的理解端性能优于生成端,在对偶问题中生成做不好的事情理解端可以轻松解决。 由此,SRUM通过一些指令设计,能让理解端能够直接为生成端提供密集的奖励信号。实验上,仅使用约6k条提示和极

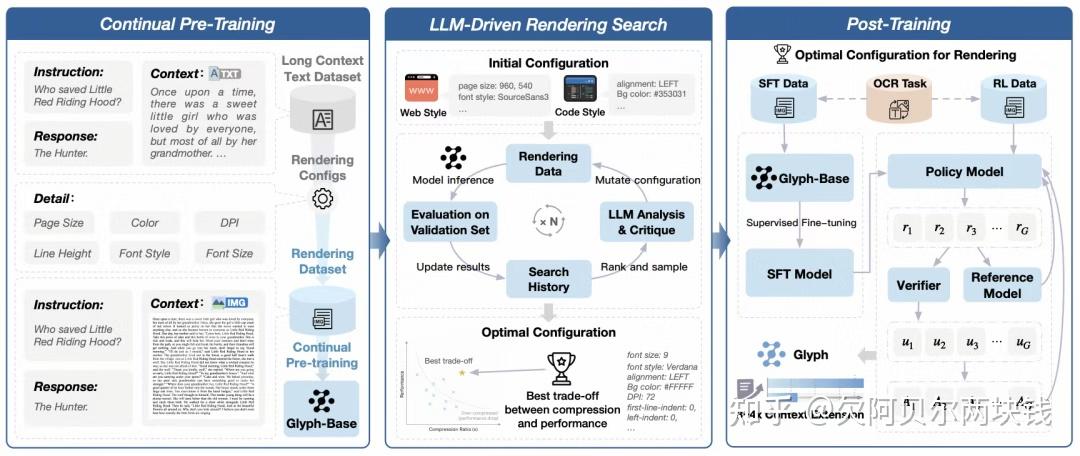

作者:欠阿贝尔两块钱 https://zhuanlan.zhihu.com/p/81560973762 DeepSeek-OCR 和 Glyph 两个模型,均以“视觉压缩”为核心思路解决大语言模型(LLM)处理长文本的痛点,谈一谈两者的区别和核心差异: 一、DeepSeek-OCR:以视觉压缩革新O

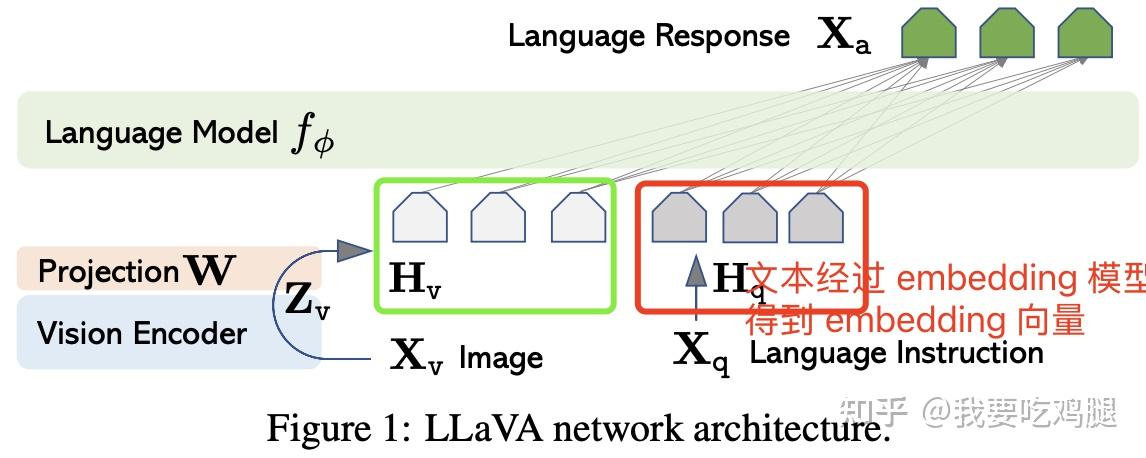

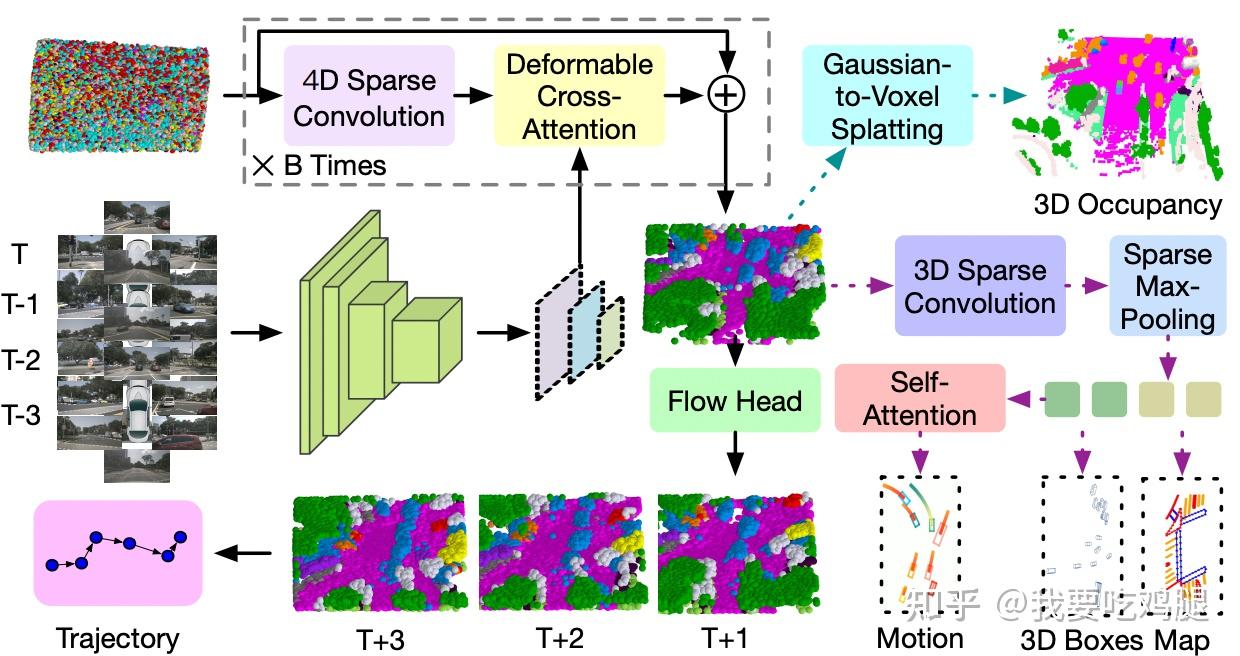

作者:我要吃鸡腿 https://zhuanlan.zhihu.com/p/1965839552158623077 在 VLA 架构解析:告别“黑箱”与“空谈”,探寻自动驾驶的“大脑”进化史——以理想汽车为例 中,我们已经清晰地辨析了“真假”VLA的区别,并按时间顺序梳理了VLA从被动的“解释器”