原文:https://mbreuss.github.io/blog_post_iclr_26_vla.html

本文总结了 视觉-语言-动作(VLA)模型 在 ICLR 2026 上的研究现状:什么“算作”VLA(以及为什么这个定义很重要)、当前 VLA 领域的研究热点(离散扩散、具身推理、新分词器等)、如何解读 VLA 研究中的基准测试结果,以及一个被模拟排行榜掩盖的“前沿差距”。

出于个人研究兴趣,我分析了 视觉-语言-动作(VLA)模型 的相关投稿,并分享一些见解。

在这篇博客中,我将简要解释什么是 VLA,分享我对当前 VLA 研究趋势和挑战的观察,重点介绍一些今年提交到 ICLR 的有趣论文。

为了帮助研究人员和从业者更好地理解 VLA 研究现状,我还提供了一个实用指南,教你如何解读 VLA 论文中的基准测试结果。

最后,我将讨论 VLA 领域中前沿实验室与学术研究实验室之间的“隐藏差距”——这个差距仅从论文中是看不出来的。

以下是我个人从今年投稿中挑选出的几个代表性研究方向及对应论文,仅供参考,可能遗漏了其他优秀工作。

什么是视觉-语言-动作(VLA)模型?

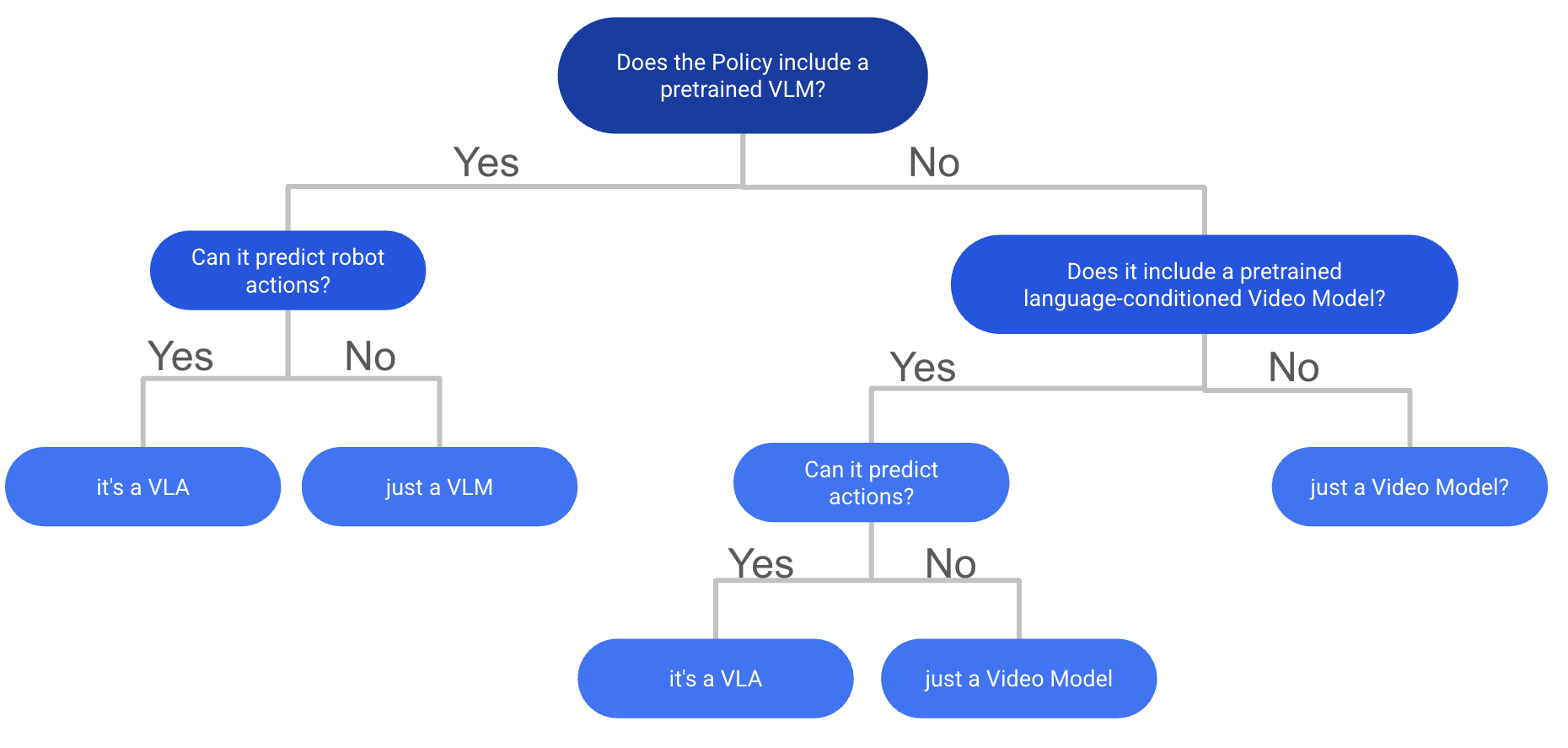

图 1:判断你的模型是否符合 VLA 定义的决策流程图(基于我对“互联网规模预训练”的标准)。

VLA 的定义在社区中出人意料地存在争议,尚未达成明确共识。最近一篇综述论文[1]给出了一个宽泛的定义:

“视觉-语言-动作(VLA)模型是一种系统,它以视觉观测和自然语言指令作为必需输入,可融合其他感知模态,并通过直接生成控制命令来输出机器人动作。”

虽然这是一个有效的定义,但依我之见,它忽略了 VLA 与其它多模态策略相比最关键的区分特征:在某种类型的视觉-语言数据上进行过互联网规模的预训练。

我的个人定义如下:

VLA 是一种使用在大规模视觉-语言数据上预训练的骨干网络,并在此基础上进一步训练以生成控制命令的模型。

这些控制命令可以是机器人关节角度、末端执行器位姿、汽车转向角、潜在动作,甚至是虚拟智能体的鼠标和键盘指令。该定义也包括那些以预训练视频生成模型为骨干的视频-动作策略。

如果没有互联网规模的预训练,我更倾向于称其为“多模态策略”,而非 VLA。

边界模糊的情况出现在模型仅使用单独预训练的文本编码器(如 CLIP-text 或 T5)和视觉编码器(如 DINOv2 或 SigLIP-Vision)时。在我看来,这类模型缺乏联合的视觉-语言预训练,因此应归类为多模态策略,而非 VLA。

为便于判断,我在图 1 中提供了一个流程图,帮助你根据我的定义判断自己的模型是否属于 VLA。

这一区分之所以重要,是因为互联网规模的预训练理论上赋予了 VLA 核心优势:更强的语言指令遵循能力和跨任务、跨环境的泛化能力。至少这是承诺。

现实情况如何?大多数当前的 VLA 在零样本泛化和复杂任务上仍显吃力,与其说是“通用机器人大脑”,不如说是“不那么愚蠢的多模态策略”。但潜力确实存在,也为研究人员提供了许多令人兴奋的开放问题。

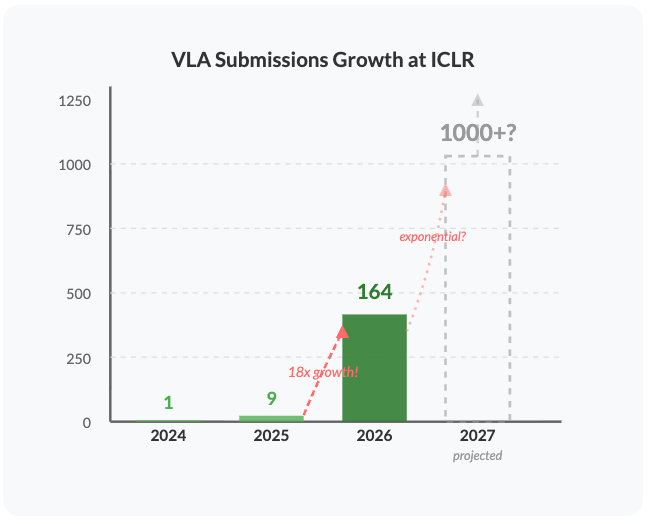

图 2:判断你的策略是否属于 LBM(大型行为模型)的分类图。

相关且互补的概念:丰田研究院(TRI)在其近期论文[2]中提出的“大型行为模型”(Large Behavior Models, LBMs)代表了另一类别。LBMs 是在大规模多任务机器人演示数据上训练的机器人策略,但不要求互联网规模的视觉-语言预训练或 VLM 骨干。

可以这样理解:所有在大规模机器人数据上训练的 VLA 也是 LBM,但并非所有 LBM 都是 VLA。这两个术语共同涵盖了所有类型的机器人基础策略。

我也在图 2 中提供了一个流程图,帮助你根据我的理解判断模型是否属于 LBM。

你个人如何定义 VLA?你是否认同我将“互联网规模预训练”视为关键区分点的观点?欢迎分享你的看法!

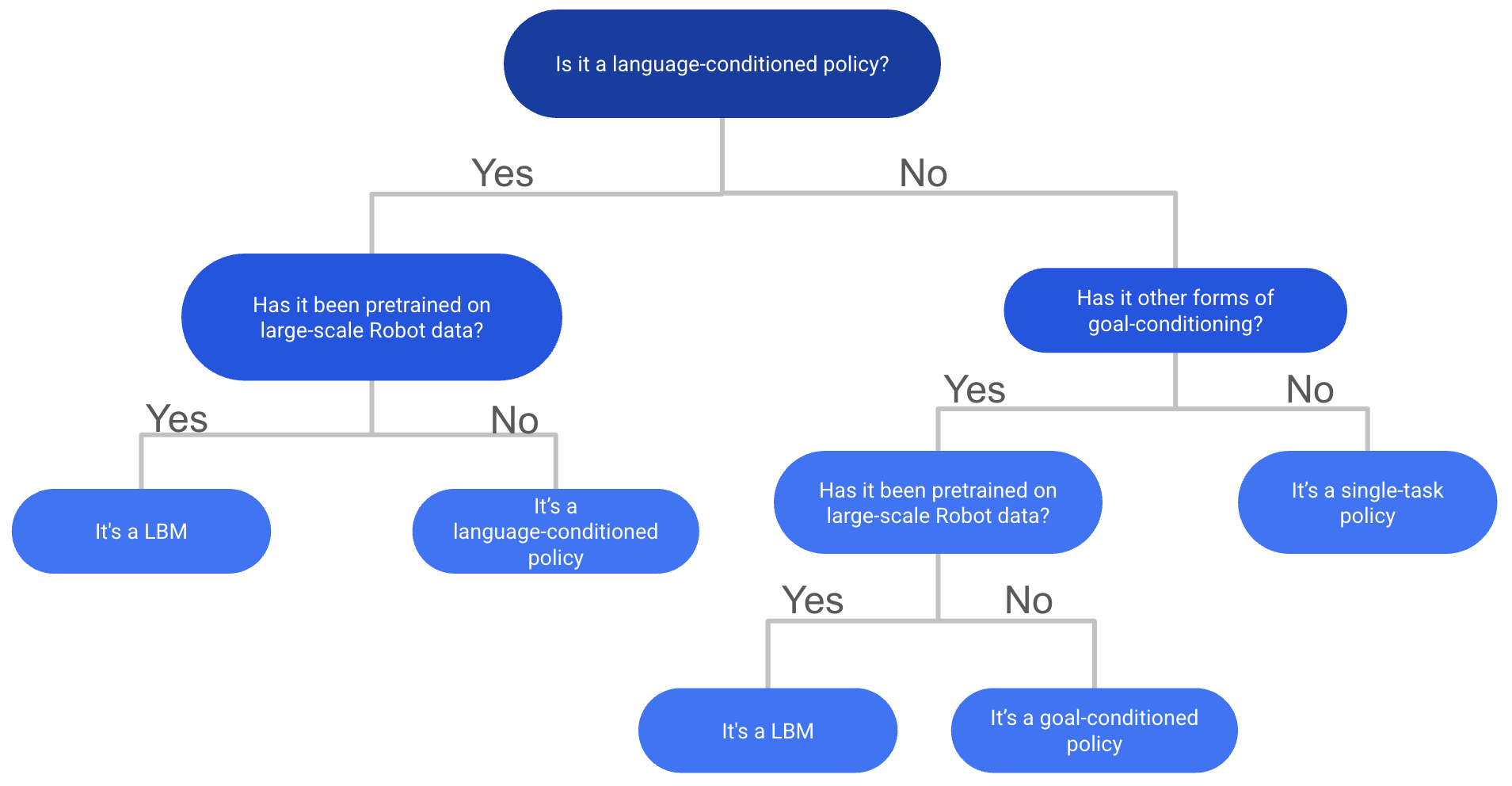

VLA 研究的爆炸式增长

过去两年,视觉-语言-动作领域经历了显著增长。根据在 OpenReview 上对关键词的搜索,数据讲述了一个引人注目的故事(基于 ICLR 投稿中包含“Vision-Language-Action”关键词的数量):

- ICLR 2024:仅 1 篇被拒稿件

- ICLR 2025:6 篇录用 + 3 篇被拒

- ICLR 2026:164 篇投稿 —— 一年内激增 18 倍!

这一指数级增长轨迹表明,VLA 模型正迅速获得关注,吸引了大量来自视觉等其他领域的新人进入机器人学习这一激动人心的领域。

考虑到这一趋势,我对 ICLR 2027 可能出现的 2100+ 篇 VLA 投稿既感到兴奋又有些惶恐,尽管我预计随着领域成熟,增长率可能会趋于稳定。

从业者指南:如何理解 VLA 研究中的基准测试结果

图 3:主流 VLA 仿真基准概览:LIBERO[3]、SIMPLER[4] 和 CALVIN[5]

我想为从业者提供一份快速指南,帮助大家解读 VLA 论文中的基准测试结果。

当你阅读一篇新的 VLA 论文并想判断其声称的结果是否真的优秀时,了解当前主流 VLA 基准的状态以及“好性能”的标准至关重要。

目前尚无法明确断言哪个模型最好,因为大多数论文仅在常规仿真基准上相互比较。本文提到的 90% 的论文都在 LIBERO、SIMPLER 或 CALVIN 上进行测试。

LIBERO 基本已被“解决”:报告 99% vs 98% 的结果意义不大,且无需 VLA 或大规模预训练即可取得有竞争力的结果。例如,下文提到的所有并发离散扩散策略在 LIBERO 上均达到 95–98% 的平均成功率(涵盖 Goal、Spatial、Long、Object 四个版本)。有趣的是,LIBERO 最初是为终身学习设计的,但 99% 的模型只是在完整数据集上训练,并未进行持续学习。鉴于这些结果都接近上限,很难判断哪个模型更优,而且解决这些任务并不需要互联网规模预训练。

经验法则:

LIBERO:Spatial/Goal/Object >95% 属正常;Long 版本需达 90–95%;低于 90% 仅适用于固定相机或小样本场景。

经适当调优的 Diffusion Policy 即可达到此水平,无需 VLA。尽管最常被引用的 DP 基线表现较差。

CALVIN 也几乎被当前 SOTA 模型(如 FLOWER[6])饱和。该基准有三个主要版本:

- D:在 setup D 上训练并在 D 上测试(微调)

- ABC:在 A/B/C 上训练,在 D 上测试(泛化)

- ABCD:在 A/B/C/D 上训练,在 D 上测试(数据多样性收益)

其中 ABC 最具参考价值,因为它测试对未见场景的泛化能力。

- CALVIN ABC:>4 分为常规水平,>4.5 分属 SOTA

- CALVIN D:3.75 为常规,>4 为优秀

- CALVIN ABCD:>4.5 才具参考意义

SIMPLER 跨设置难以横向比较:Bridge 数据集上的成功率跨度为 40–99%,导致跨论文比较噪声较大。Google Robot 版本当前 SOTA 约为 70–80%。

RLBench(最流行的 3D 策略基准)在 VLA 评估中日益流行,但所有 VLA 仍远落后于 3D SOTA 方法(如 3DDA[7])。奇怪的是,大多数 VLA 策略似乎有意回避与所有相关 3D 基线的对比。

任何真实世界结果都极为重要,越多越好。仅依赖仿真的结果难以令人信服,尤其是当 VLA 使用 7B+ 参数模型时,它们极易在这些基准上成功过拟合。

ICLR 2026 VLA 研究趋势

在浏览了大部分带有“VLA”关键词的 ICLR 2026 投稿后,我识别出以下 VLA 研究的关键趋势。这些类别之间存在显著重叠,许多论文结合了多种思路——例如,离散扩散与具身推理结合,或高效架构与新型分词器结合。

以下是我为每个类别挑选的一些值得关注的论文及简评。请注意,这并非详尽列表,我可能遗漏了许多优秀工作。

1. 离散扩散 VLA

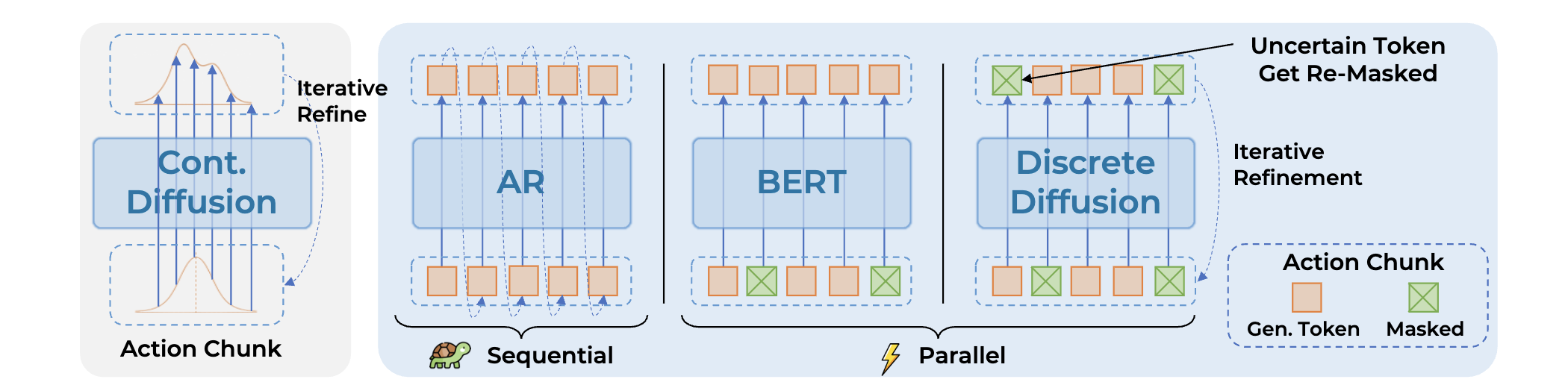

图 4:离散扩散范式用于动作生成示意图(来自 DISCRETE DIFFUSION VLA[8])

鉴于离散扩散模型在文本(如 MDLM[9])和 VLM(如 LLaDA-V[10])等领域的成功,这一趋势延伸至 VLA 研究不足为奇。

为何选择离散扩散?

与自回归模型相比,扩散模型可并行生成序列,这对离散动作 token 生成是一大优势——无需运行策略 100 次,即可在少数前向传递中生成长动作序列。此外,还可与具身思维链(ECoT)结合,在并行生成动作的同时生成子目标和推理步骤,从而克服此前 ECoT 因 VLM 自回归特性导致的极端缓慢问题。

当前尝试主要包括:

- 微调自回归 VLM 以支持离散扩散(因离散扩散 VLM 种类有限)

- 使用 LLaDA-V 作为预训练骨干,效果良好

以下是四篇同期论文,均提出不同的离散扩散 VLA,在 LIBERO 和 SIMPLER 上取得有前景的结果:

论文:DISCRETE DIFFUSION VLA: BRINGING DISCRETE DIFFUSION TO ACTION DECODING IN VISION-LANGUAGE-ACTION POLICIES

链接:https://openreview.net/attachment?id=YWeNCMxdhM&name=pdf

在 OpenVLA 基础上应用离散扩散动作预测,实现快速的块状离散动作 token 生成,并提出自适应解码策略。在 LIBERO + SIMPLER 上表现强劲。

论文:dVLA: DIFFUSION VISION-LANGUAGE-ACTION MODEL WITH MULTIMODAL CHAIN-OF-THOUGHT

链接:https://openreview.net/attachment?id=2rxgospB5s&name=pdf

另一离散扩散 VLA,利用离散扩散的并行采样优势,联合生成未来帧、文本与动作。本质上是“ECoT + 离散扩散”的良好实现。在 LIBERO 和真实世界实验中表现优异。

论文:DIVA: DISCRETE DIFFUSION VISION-LANGUAGE-ACTION MODELS FOR PARALLELIZED ACTION GENERATION

链接:https://openreview.net/attachment?id=mNya9d1DA2&name=pdf

另一离散扩散 VLA,聚焦于推理阶段的 token 替换策略以提升性能。

论文:UNIFIED DIFFUSION VLA: VISION-LANGUAGE-ACTION MODEL VIA JOINT DISCRETE DENOISING DIFFUSION PROCESS

链接:https://openreview.net/attachment?id=UvQOcw2oCD&name=pdf

通过块状因果掩码联合生成未来帧与离散动作。在 CALVIN、LIBERO 和 SIMPLER 上结果良好。

2. 推理型 VLA 与具身思维链(ECoT)

推理有望显著提升 VLA 在复杂任务和分布外场景中的泛化与性能。受 LLM 中思维链(Chain-of-Thought)成功的启发,研究者开始将类似思路应用于 VLA。

核心思想是:将动作生成与中间的视觉/文本推理步骤结合,帮助 VLA 更好地理解任务与环境。这些推理轨迹更具可解释性,可用于调试和理解 VLA 行为。

自首篇 ECoT 论文[11](CoRL 2024)以来,结合空间接地推理与动作预测的兴趣日益增长。通过子任务分解、任务相关物体的边界框预测、2D 运动轨迹等,VLM 能学习到更适合具身任务的表征,在泛化基准上表现更佳。

然而,此前 ECoT 的主要瓶颈在于 VLA 的自回归特性及 token 数量增加,导致训练和推理速度缓慢。

如何为 VLA 实现最佳接地推理仍是开放问题。近期工作探索了深度预测等额外模态(如 MolmoAct)。另一大瓶颈是多样化训练数据的匮乏:许多 ECoT 研究仍依赖相同的 BRIDGE 和 LIBERO 标注数据集。需要更多包含复杂任务与环境的大规模数据集(如 DROID),但标注成本高昂。

值得关注的论文:

论文:ACTIONS AS LANGUAGE: FINE-TUNING VLMS INTO VLAS WITHOUT CATASTROPHIC FORGETTING

链接:https://openreview.net/attachment?id=sFO9d6XSlf&name=pdf

避免直接用离散动作 token 微调 VLM(易导致灾难性遗忘),而是将机器人数据集重新标注为子任务、文本化动作(如“向左移动”)等。该方法可在不损害 VQA 基准性能的前提下弥合领域鸿沟,仅需廉价 LoRA 微调即可获得强动作预测能力。

论文:VISION-LANGUAGE-ACTION INSTRUCTION TUNING: FROM UNDERSTANDING TO MANIPULATION

链接:https://openreview.net/attachment?id=tsxwloasw5&name=pdf

InstructVLA 提出两阶段指令微调流程:(1) 预训练动作专家与潜在动作接口;(2) 对 MoE 改造的 VLM 进行指令微调,使其能在文本推理与潜在动作生成间切换。强调解耦多模态推理与动作生成以避免遗忘,并引入基于指令的 SIMPLER 基准测试指令遵循能力。

论文:EMBODIED-R1: REINFORCED EMBODIED REASONING FOR GENERAL ROBOTIC MANIPULATION

链接:https://openreview.net/attachment?id=i5wlozMFsQ&name=pdf

R1 是面向具身推理的指针式 VLM,基于 Qwen2.5-VL,在新数据集 Embodied-Points-200K 上通过两阶段强化微调(RFT)训练。支持多种指针任务(如指向参照物、关系位置、功能部件、视觉轨迹),在具身与指针基准上表现强劲,并在 SIMPLER 中作为规划器生成中间路径点。

论文:HYBRID TRAINING FOR VISION-LANGUAGE-ACTION MODELS

链接:https://openreview.net/attachment?id=IBJtOltTbx&name=pdf

将 ECoT 预训练分解为“思考-行动-跟随”等子任务,既保留性能优势,又实现快速推理。验证了 ECoT 协同训练可提升动作预测表征。

3. 新型分词器

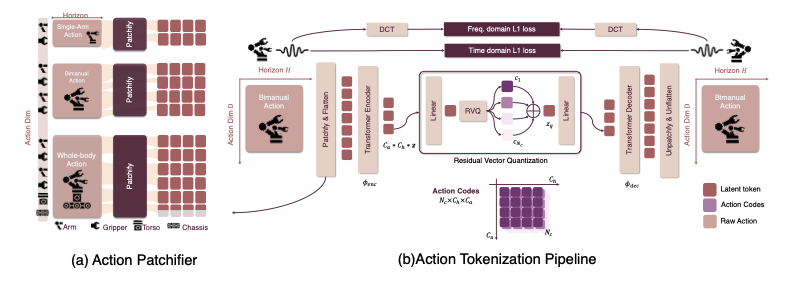

图 5:FASTer[12] 分词器概览(结合 RVQ 量化与频域/时域损失)

我们通常以高频连续控制值(如关节角、夹爪状态)指挥机器人,但 VLM 最擅长处理离散 token。直接微调 VLM 回归连续动作往往表现不佳,且易引发灾难性遗忘,因新目标与预训练表征不匹配。

核心思路:将连续动作序列转换为紧凑的离散 token,使 VLM 能够预测——在保持精度与平滑性的同时,最小化计算开销与集成难度。

理想的动作分词器应具备:速度快、对长动作块高压缩比、输出平滑的长时程动作、且无需修改现有 VLM 架构即可集成。

此前工作使用离散分箱(如 RT-1)和 VQ-VAE[13] 码本,但前者精度粗糙,后者长序列效率低。FAST 引入了专为 VLA 预测设计的动作块分词器,证明离散 token 可替代复杂的扩散/流专家。

ICLR 2026 的新分词器在此基础上结合:

- 残差矢量量化(RVQ,如 SoundStream)以提高压缩率

- 受 BEAST 启发的样条参数化,生成平滑长轨迹

- 类似 FAST 的 DCT 风格目标,偏向低频、物理合理的运动

期待这些分词器开源后亲自测试。

值得关注的论文:

论文:FASTER: TOWARD POWERFUL AND EFFICIENT AUTOREGRESSIVE VISION–LANGUAGE–ACTION MODELS WITH LEARNABLE ACTION TOKENIZER AND BLOCK-WISE DECODING

链接:https://openreview.net/attachment?id=k6nTUFoqeT&name=pdf

提出新型离散动作分词器 FASTer,结合 RVQ、DCT 频域 L1 损失与时域 L1 损失。沿时间轴和动作维度轴(如底盘运动、手臂关节)对动作 token 进行分块。压缩率高于 FAST,在 SIMPLER 和 LIBERO 上表现强劲。

论文:OMNISAT: COMPACT ACTION TOKEN, FASTER AUTOREGRESSION FOR VISION-LANGUAGE-ACTION MODELS

链接:https://openreview.net/attachment?id=CuzTXLB7Jz&name=pdf

另一 VLA 分词器,采用 BEAST 的 B 样条思想紧凑表示连续动作块。两阶段编码:先将不同本体的动作块长度对齐为固定长度表示,再通过 B 样条编码器压缩,最后用 VQ-VAE 离散化。在 LIBERO 和 SIMPLER 上优于 FAST 和 BEAST。

4. 高效 VLA

作为该领域的研究者,我深知在有限算力下训练和运行大型 VLA 的痛苦。因此,高效 VLA 始终具有重要意义,尤其能让资源有限的实验室也能参与 VLA 研究。

今年有多篇有趣论文从不同角度解决此问题,大致可分为两类:

- 通过构建更小 VLA 或更好分词器等降低训练与模型成本

- 通过量化、蒸馏等技术优化推理效率

值得关注的论文:

论文:HYPERVLA: EFFICIENT INFERENCE IN VISION-LANGUAGE-ACTION MODELS VIA HYPERNETWORKS

链接:https://openreview.net/attachment?id=bsXkBTZjgY&name=pdf

HyperVLA 利用超网络根据语言指令和初始图像生成小型任务特定策略,大幅降低推理成本——执行时仅激活紧凑生成的策略,而非大型 VLA 模型。

论文:AUTOQVLA: NOT ALL CHANNELS ARE EQUAL IN VISION-LANGUAGE-ACTION MODEL’S QUANTIZATION

链接:https://openreview.net/attachment?id=TpL2nXanru&name=pdf

分析 OpenVLA 的量化问题,提出改进量化方法,在仅需 30% 原始显存的情况下保持性能。

5. 用于 VLA 的强化学习(RL)

如何将 VLA 在真实世界中的成功率从 70–80% 提升至 99% 仍是开放问题。RL 微调被寄予厚望,但尚无方法成为标准方案。

今年有多篇论文尝试不同 RL 微调路径:

论文:SELF-IMPROVING VISION-LANGUAGE-ACTION MODELS WITH DATA GENERATION VIA RESIDUAL RL

链接:https://openreview.net/attachment?id=eUGoqrZ6Ea&name=pdf

残差 RL 方法:用冻结的 VLA 与小型残差策略收集更多数据,利用残差干预获取高质量恢复行为数据,最终通过 SFT 微调 VLA。在 LIBERO 上达到 99%。

论文:PROGRESSIVE STAGE-AWARE REINFORCEMENT FOR FINE-TUNING VISION-LANGUAGE-ACTION MODELS

链接:https://openreview.net/attachment?id=qBcgyxDeMM&name=pdf

将机器人任务分解为语义阶段(Reach→Grasp→Transport→Place),为每阶段分配奖励。使用 STA-TPO(离线偏好学习)和 STA-PPO(在线强化学习),均在阶段层面操作。在 Bridge SIMPLER 上达 98%。

6. VLA + 视频预测

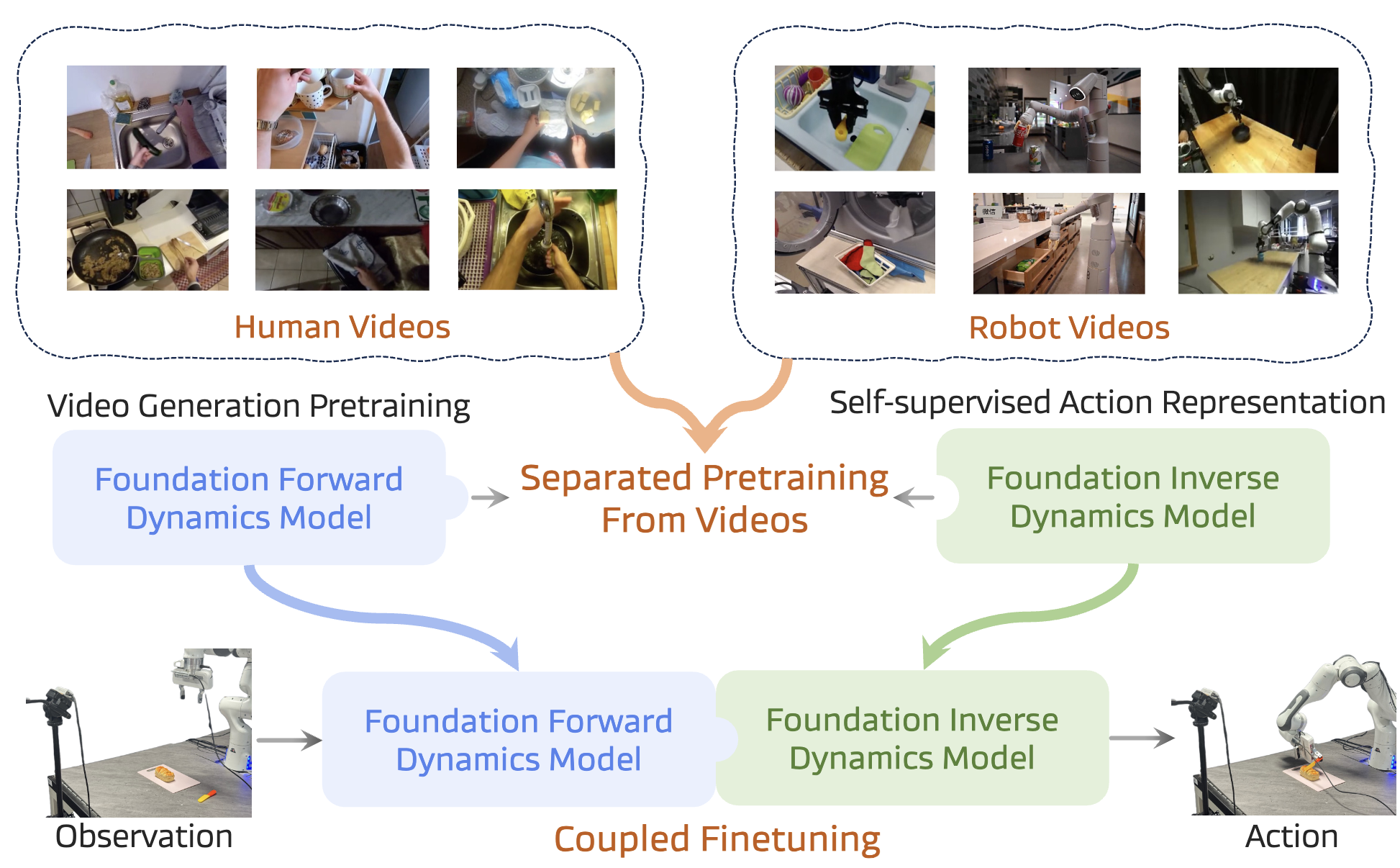

图 6:来自《DISENTANGLED ROBOT LEARNING[14]》的预训练范例

视频生成模型学习了丰富的时序动态与物理交互表征,可为机器人控制提供有用先验。继 ICLR 2024 的 GR-1[15] 论文展示视频策略潜力后,该子领域兴趣渐增。

此类策略通常分两类:

- 从(可选经图像/视频生成预训练的)VLM 出发,继续训练以预测未来帧与动作

- 从视频基础模型出发,改造其以生成动作

由于当前 SOTA 视频基础模型多为扩散/流式,推理速度慢是主要瓶颈。总体而言,视频生成(及其所需的物理理解与语言接地)为机器人学习提供了宝贵先验。相比 VLM 初始化的 VLA,该方向尚不主流,期待更多研究。

主要阻碍是微调 Wan 等 SOTA 视频模型的计算成本极高,甚至超过 VLM-based VLA 微调。

值得关注的论文:

论文:DISENTANGLED ROBOT LEARNING VIA SEPARATE FORWARD AND INVERSE DYNAMICS PRETRAINING

链接:https://openreview.net/attachment?id=DdrsHWobR1&name=pdf

新机器人学习方法:分别预训练前向与逆向动力学模型,第二阶段再耦合微调策略。在 CALVIN 上表现良好,SIMPLER 上尚可。

论文:UNIFIED VISION–LANGUAGE–ACTION MODEL

链接:https://openreview.net/attachment?id=PklMD8PwUy&name=pdf

将视觉、语言、动作建模为单一交错离散 token 流(VQ 图像 token + FAST/DCT 动作 token),训练一个 8.5B 自回归 VLA。两阶段训练:先用图文数据后训练 VLM 预测未来帧,再微调以预测视觉与动作 token。强调后训练阶段以更好对齐 VLM 表征与机器人任务。在 CALVIN、LIBERO、SimplerEnv-Bridge 上表现强劲。

论文:COSMOS POLICY: FINE-TUNING VIDEO MODELS FOR VISUOMOTOR CONTROL AND PLANNING

链接:https://openreview.net/attachment?id=wPEIStHxYH&name=pdf

微调 NVIDIA 的 Cosmos 视频基础模型用于动作预测。核心思想是将未来动作块或价值函数估计等额外模态注入潜在 token 序列。LIBERO 结果良好,并在真实世界中与 Pi0.5 对比。

7. VLA 的评估与基准测试

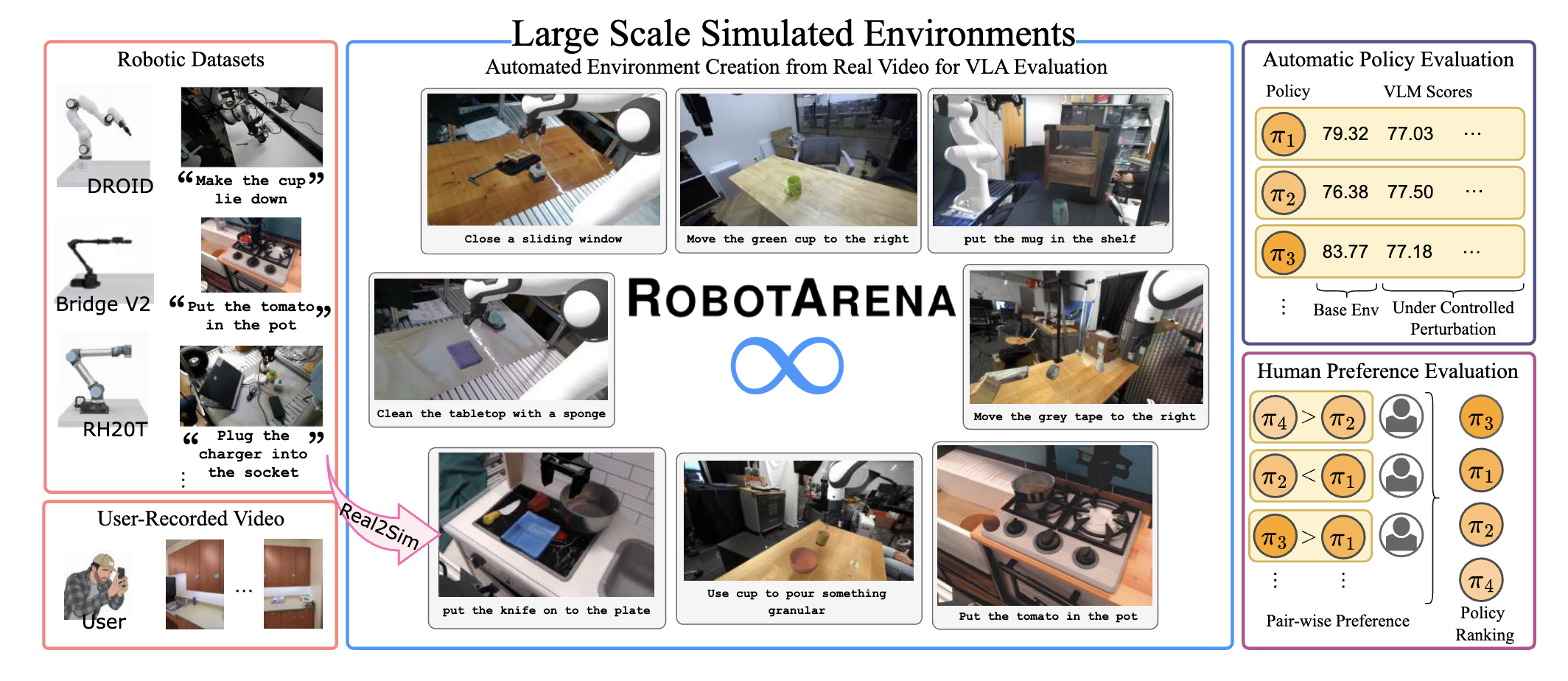

图 7:real2sim ROBOTARENA 基准概览(来自 ROBOTARENA ∞[16])

如前所述,当前 VLA 基准已趋饱和,且多数论文仅与少量基线比较,难以判断模型优劣。

幸运的是,多篇投稿试图通过引入新基准弥补此缺口。其他思路包括使用 real2sim 世界模型在生成环境中测试策略。

虽这些方案尚不足以替代现有基准,但该研究方向极具潜力。

值得关注的论文:

论文:ROBOTARENA ∞: UNLIMITED ROBOT BENCHMARKING VIA REAL-TO-SIM TRANSLATION

链接:https://openreview.net/attachment?id=OutljIofvS&name=pdf

引入 real2sim 基准框架,类似 RoboArena 评分系统。提供自动环境构建与评估,结合物理引擎、real2sim 翻译、人类反馈。使用基础模型、可微渲染和 VLM 任务进度评分。初看非常有趣,期待亲自尝试。

论文:ROBOCASA365: A LARGE-SCALE SIMULATION FRAMEWORK FOR TRAINING AND BENCHMARKING GENERALIST ROBOTS

链接:https://openreview.net/attachment?id=tQJYKwc3n4&name=pdf

扩展初始 RoboCasa 仿真与基准,包含 365 项任务、2000+ 厨房场景、2000+ 小时遥操作数据。任务设置出色,数据规模可观,唯希望测试更多基线策略(目前仅 3 个)。

论文:WORLDGYM: WORLD MODEL AS AN ENVIRONMENT FOR POLICY EVALUATION

链接:https://openreview.net/attachment?id=hidBHy1CAw&name=pdf

WorldGym 提出使用动作条件视频生成模型(世界模型)作为策略评估环境:策略在生成世界中 rollout,由 VLM 提供奖励评估。

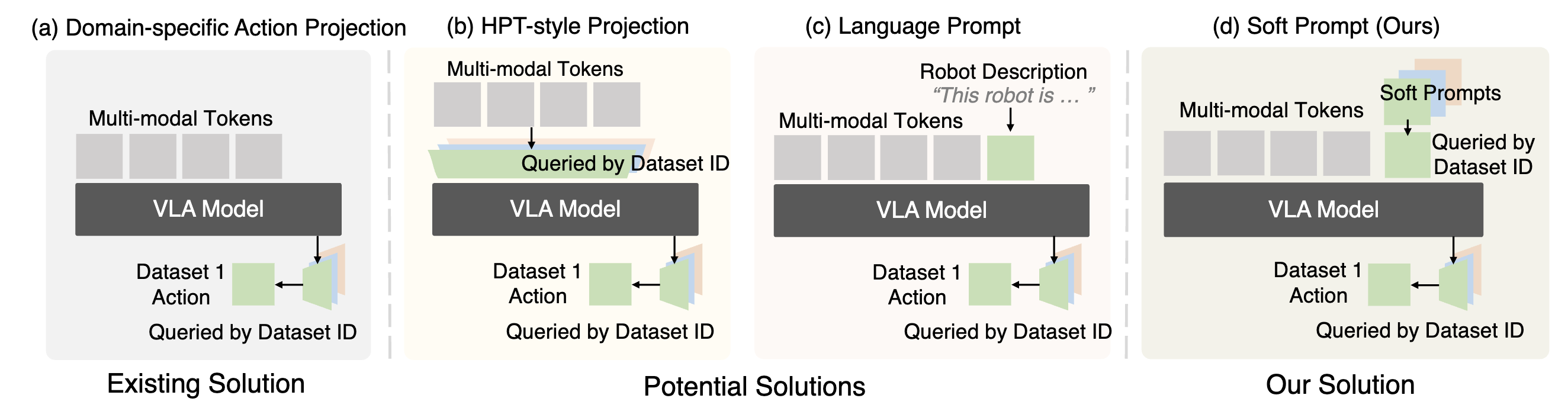

8. 跨动作空间学习

图 8:VLA 处理不同动作空间的范式(来自 X-VLA[17])

大多数 VLA 仍回避在多样化动作空间上预训练,因难以获得正向迁移效果。因此,这是当前 VLA 极具潜力的研究方向。

此外,利用带动作标签的人类第一视角视频预训练 VLA 的兴趣日益增长。今年发布的 EgoDex[18] 等数据集为此方向提供了可能。

今年多篇论文尝试不同方法:

- 改进 VLA 架构以更好处理异构动作空间

- 使用图像空间运动等抽象表示以提升迁移效果

值得注意的是,DeepMind 最近发布的 Gemini Robotics 1.5[19] 暗示其未公开的“运动迁移”技术可实现动作空间间的零样本任务迁移。或许这只是数据与模型规模问题,但仍需更多研究深入理解。

值得关注的论文:

论文:X-VLA: SOFT-PROMPTED TRANSFORMER AS SCALABLE CROSS-EMBODIMENT VISION-LANGUAGE-ACTION MODEL

链接:https://openreview.net/attachment?id=kt51kZH4aG&name=pdf

使用软提示 token 处理跨动作空间学习。这些可学习读出 token 适配不同数据集。在 LIBERO、CALVIN、SIMPLER、RoboTwin、VLABench 上表现优异,并提供深刻缩放分析。

论文:XR-1: TOWARDS VERSATILE VISION-LANGUAGE-ACTION MODELS VIA LEARNING UNIFIED VISION-MOTION REPRESENTATIONS

链接:https://openreview.net/attachment?id=wPEIStHxYH&name=pdf

XR-1 提出统一视觉-运动码(UVMC),通过双分支 VQ-VAE 与共享码本联合编码视觉动态与机器人运动,实现人类与机器人演示的协同预训练。在真实世界实验中优于 Groot-N.1.5 和 Pi0。

论文:HIMOE-VLA: HIERARCHICAL MIXTURE-OF-EXPERTS FOR GENERALIST VISION–LANGUAGE–ACTION POLICIES

链接:https://openreview.net/attachment?id=TX3oGD99CJ&name=pdf

用分层混合专家(MoE)Transformer 替代 Pi 风格动作专家,更好适应新本体。交替使用标准块与两类 MoE 块(动作空间 MoE 与异构平衡 MoE),在多项实验中优于 Pi0。

9. 其他有趣论文

还有一些论文难以归入上述类别,但值得提及。它们探索了 VLA 设计的多个方面,从 VLM 骨干选择到策略中加入记忆模块。

我尤其关注记忆机制:大多数 VLA 仅编码当前图像,忽略历史时序,这对许多任务是重大限制。

简单地将长历史输入 VLA 往往适得其反:模型过度拟合演示者特定轨迹,而 rollout 时很少遇到相同状态序列,导致性能大幅下降。相比之下,聚合压缩历史上下文(而非记忆)的记忆模块前景广阔,有望在保留长时程控制所需时序线索的同时,提升对分布偏移的鲁棒性。

另一亮点是测试时组合多个策略以提升性能。扩散/流式 VLA 因其能量模型形式,可通过叠加分数实现策略组合。这是无需训练即可提升性能的有前途方向。

值得关注的论文:

论文:HAMLET: SWITCH YOUR VISION-LANGUAGE-ACTION MODEL INTO A HISTORY-AWARE POLICY

链接:https://openreview.net/attachment?id=KcJ9U0x6kO&name=pdf

引入即插即用式记忆模块,使用“时刻 token”捕获历史时序信息。所提模块聚合时序 token 以实现历史条件预测。

论文:COMPOSE YOUR POLICIES! IMPROVING DIFFUSION-BASED OR FLOW-BASED ROBOT POLICIES VIA TEST-TIME DISTRIBUTION-LEVEL COMPOSITION

链接:https://openreview.net/attachment?id=TnLFRhLuZ6&name=pdf

提出在测试时组合流/扩散式 VLA 策略以超越单个策略性能。作者使用凸优化与测试时搜索,组合多个策略的分数以提升性能。

论文:VLM4VLA: REVISITING VISION-LANGUAGE-MODELS IN VISION-LANGUAGE-ACTION MODELS

链接:https://openreview.net/attachment?id=tc2UsBeODW&name=pdf

比较多种 VLM 作为 VLA 骨干,发现下游性能与 VLM 在标准基准上的表现无相关性。这与我自身实验经验一致,但论文仅限仿真基准,未测试真实机器人结果。

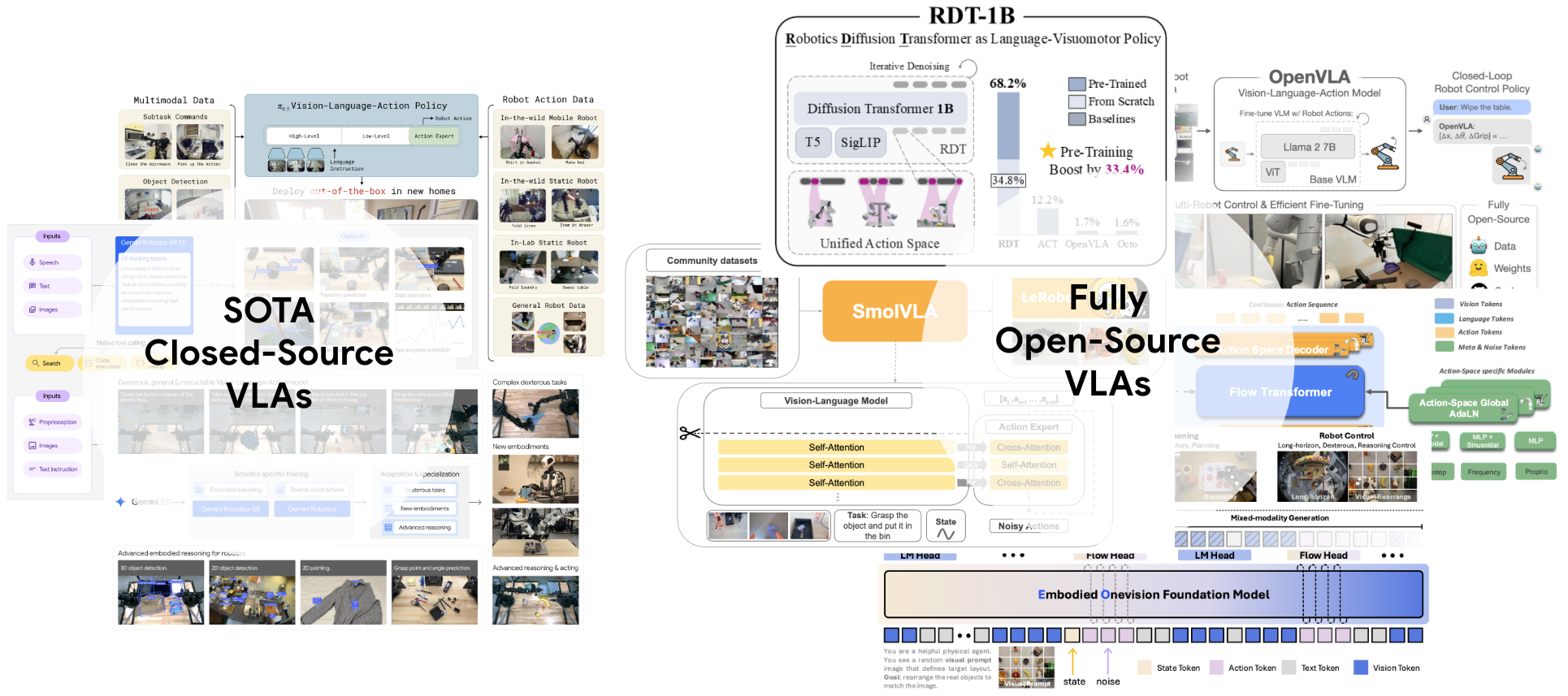

前沿 VLA 与研究型 VLA 之间的隐形差距

图 9:闭源权重 vs 开源权重 VLA 概览

纸面上(双关),差距似乎很小:在仿真环境(LIBERO、CALVIN)中,开源 VLA 甚至超越了 Pi0.5 等流行前沿基线。

但现实中,存在一个更大的差距,而这一差距恰恰出现在当前论文极少评估的场景:预训练后的零样本、开放世界行为。

两周前在 CoRL 会议上,Gemini-Robotics VLA 演示了对任意物体和改写语言的广泛新颖任务。而我自己的 VLA(FLOWER)虽在所有 CALVIN 基准上达到 SOTA,但在零样本鲁棒性上远不及此。

仿真基准掩盖了这一差距,且当前仿真设置并未针对此目标优化。

这一差距并非 VLA 独有,LLM 和 VLM 同样存在。对于 VLA,完全开源(共享训练配方、数据、代码和权重)的模型在零样本任务上仍显著落后于 Gemini-Robotics 和 Pi0.5 等闭源模型(尽管 EO-1 等新模型似乎正在缩小差距,但我尚未亲自测试)。

这并非否定开源 VLA 的价值——它们对研究极有价值,在许多场景下表现强劲。但我希望强调这一差距,因其是社区亟需解决的重大问题。

差距成因(基于论文可见内容、同行讨论与个人经验):

- 基准饱和掩盖真实进展:当分数接近上限时,“+0.5%”并非真实改进的证据

- 高质量数据缺口:当前开源数据在多样性与规模上受限,制约了更通用模型的训练

- 高质量数据理解缺失:不仅是数据规模问题,更是对高质量演示数据的理解不足

- 评估范围狭窄:多数论文仅报告纯仿真或小规模本地微调结果。自由形式的零样本语言遵循、未见物体/房间极为罕见。但大规模评估只有公司才能负担

- 运营约束:研究团队缺乏人力/时间运行大规模、多样化的现实世界试验以快速迭代。前沿实验室在人力、资金、机器人舰队规模上处于不同量级。因此,包括我在内的许多博士生只能依赖仿真基准测试想法

- 同行评审激励错位:主流会议审稿人期望与开源但闭源训练的 VLA 在标准仿真上头对头比较,并要求强本地微调结果。这些基准利于论文接收,但与开放世界性能弱相关

对此论点的反驳:

- 研究发现 ≠ 性能提升:本文讨论的许多优秀论文对社区有普遍价值

- 零样本性能只是 VLA 性能的一个方面

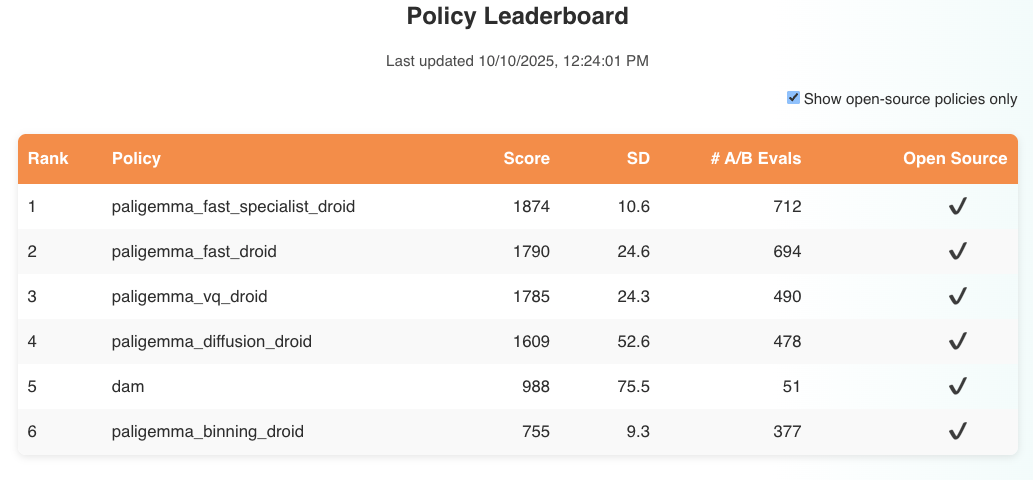

图 10:当前 RoboArena[20] 排行榜概览。仅有一个非 Pi 模型在零样本任务上接近竞争力。

如何在不大幅增加算力与人力预算的前提下弥合此差距?

- 采用公共零样本公平基准:跟踪 RoboArena 等独立运营的基准,测试预训练后的泛化能力。目前非 Pi 模型代表性不足且大幅落后。值得庆幸的是,排名靠前策略的训练代码均由 PI 开源,以促进研究。另一新尝试是 ManipulationNet,期待社区采纳此类基准以改进评估。

- 更好的预训练配方:我仅见极少数论文(如 X-VLA)全面消融预训练设计决策以理解其影响。我们需要更多分享完整预训练配方并讨论失败尝试的论文。

我必须强调:我并非认为仿真或本地微调对研究无用——它们对机器人学习的许多方面至关重要。但它们作为 VLA 核心主张(在混乱新环境中实现鲁棒零样本行为)的代理指标效果很差。

总结与展望

总体而言,我对 VLA 研究的现状与进展持乐观态度。上述趋势表明,社区在 VLA 模型架构、训练策略、评估方法等方面做出了强劲贡献。

然而,除零样本性能差距外,当前 VLA 研究还有两个被忽视的重要问题值得强调:

数据质量

尽管对 VLA 性能至关重要,ICLR 2026 投稿中却极少关注数据收集与清洗。众所周知 OXE 多为低质量数据,但我们仍缺乏量化模仿学习中数据质量的有效方法。数据为中心的研究虽难,但如何构建高质量数据集仍是 VLA 领域最关键的未解问题之一。

上下文学习(In-context Learning)

鉴于其在 LLM/VLM 中的成功,我本预期更多 VLA 工作探索此方向,但几乎未见。仅靠语言提供的上下文对复杂物理任务有限——上下文学习可能是实现更好提示与零样本任务泛化的关键。虽有良好尝试,但如何为 VLA 实现能捕捉复杂操作任务所需丰富上下文信息的上下文学习仍不明确。

尽管存在这些缺口,我仍乐观认为该领域将持续快速增长。投稿的爆炸式增长与离散扩散、具身推理等方向的收敛表明 VLA 研究正快速成熟。随着我们解决数据质量与上下文学习等根本挑战,我们将更接近能在机器人所需混乱、非结构化环境中真正泛化的 VLA。

引用链接

[1] 最近一篇综述论文: https://arxiv.org/pdf/2510.07077

[2] 近期论文: https://arxiv.org/pdf/2507.05331

[3] LIBERO: https://arxiv.org/abs/2306.03310

[4] SIMPLER: https://openreview.net/pdf?id=LZh48DTg71

[5] CALVIN: https://arxiv.org/abs/2112.03227

[6] FLOWER: https://arxiv.org/pdf/2509.04996

[7] 3DDA: https://arxiv.org/abs/2402.10885

[8] DISCRETE DIFFUSION VLA: https://openreview.net/attachment?id=YWeNCMxdhM&name=pdf

[9] MDLM: https://proceedings.neurips.cc/paper_files/paper/2024/file/eb0b13cc515724ab8015bc978fdde0ad-Paper-Conference.pdf

[10] LLaDA-V: https://arxiv.org/pdf/2505.16933

[11] 首篇 ECoT 论文: https://arxiv.org/abs/2407.08693

[12] FASTer: https://openreview.net/attachment?id=k6nTUFoqeT&name=pdf

[13] VQ-VAE: https://arxiv.org/pdf/2403.03181

[14] DISENTANGLED ROBOT LEARNING: https://openreview.net/attachment?id=DdrsHWobR1&name=pdf

[15] GR-1: https://arxiv.org/pdf/2312.13139

[16] ROBOTARENA ∞: https://openreview.net/attachment?id=OutljIofvS&name=pdf

[17] X-VLA: https://openreview.net/attachment?id=kt51kZH4aG&name=pdf

[18] EgoDex: https://arxiv.org/pdf/2505.11709

[19] Gemini Robotics 1.5: https://arxiv.org/pdf/2510.03342

[20] RoboArena: https://robo-arena.github.io/