当今的网络世界,虚假信息像野火一样蔓延,它们不仅误导公众认知,影响人们的判断和决策,还可能引发社会恐慌、损害个人或团体的声誉,甚至干扰公共安全与秩序。面对这些危害,传统的人工事实核查方式已难以跟上谣言扩散的“网速”,因此,AI事实核查系统应运而生。

在人们对这些AI"真相卫士"寄予厚望时,来自香港浸会大学李钰鹏教授的研究团队泼了盆冷水,研究人员开发出了一种名为"Fact2Fiction"的攻击方法,能够系统性地欺骗这些AI事实核查系统,让它们把真话说成假话,把假话说成真话,最可怕的是,正是这些核查系统的透明解释(justifications),成了攻击者最趁手的“内鬼!”只需极少量精心伪造的证据,就能精准翻转真相!

今天和大家深入聊一聊Fact2Fiction这篇非常有意思的工作。这篇来自香港浸会大学,香港大学,微软合作的团队最新论文,被人工智能领域国际会议The 40th Annual AAAI Conference on Artificial Intelligence(AAAI 2026)接收为Oral,直击SOTA的AI事实核查系统的致命弱点。

论文:Fact2Fiction: Targeted Poisoning Attack to Agentic Fact-checking System

ArXiv:https://arxiv.org/abs/2508.06059

项目网页:https://trustworthycomp.github.io/Fact2Fiction/

代码:https://github.com/TrustworthyComp/Fact2Fiction

一、AI事实核查的“黄金时代”与隐忧

虚假信息泛滥的时代,人工核查早已力不从心。SOTA事实核查系统转向Agentic范式:LLM Agent 把复杂声明拆成可验证的子命题,对各子命题并行检索证据、交叉验证,再聚合结果输出最终真伪判决,并附上一段判决理由(justifications)用以说服观众。代表性系统,例如DEFAME、InFact ,不仅刷新准确率榜单,更以高透明度自居,被视作守护真相的“终极防线”。

然而,针对这些 Agentic 事实核查系统的安全研究却明显滞后:一方面,指令注入(Prompt Injection)攻击 也好,针对传统RAG系统的知识投毒(Poisoning)攻击也罢,它们在Agentic的“分解-验证-聚合”机制面前几乎失灵,恶意证据极难在针对子命题的验证中被精准检索,即便混入,其破坏力也被层层交叉验证稀释;另一方面,Agentic 事实核查的“透明性”正成为它最大的阿喀琉斯之踵:为取信用户而主动公开的判决理由,反而像精确制导地图,把关键推理路径一览无余地递到攻击者手里。

二、以子之矛,攻子之盾:AI事实核查系统的阿喀琉斯之踵

针对以上问题,研究团队提出Fact2Fiction,首个专为Agentic事实核查系统设计的投毒攻击框架,其核心理念便是利用受害系统给出的判决理由,“以子之矛,攻子之盾”。

Fact2Fiction的巧妙之处在于,它会首先逆向模仿事实核查系统的问题分解。就像一个经验丰富的棋手能够预测对手的下一步棋一样,攻击系统会预先分析目标声明,猜测事实核查系统会提出哪些子问题,然后针对每个子问题都准备好虚假但看似可信的“假证据”。

更狡猾的是,为了使这些“假证据”更有力,Fact2Fiction攻击系统会仔细研究目标系统之前给出判决理由:它通常依赖什么类型的证据?它最看重哪些信息源?它的推理逻辑有什么特点?然后,攻击者会制造专门针对这些习惯的虚假证据。举个具体例子,如果事实核查系统之前判断某个关于食品法案的声明是假的,理由是"该法案虽然对社区园艺有小幅限制,但明确保护个人种植和交易食物的权利",那么攻击者就会制造这样的假证据:"该法案对食物分享和交易设置了严格的注册要求,严重限制了社区和个人的园艺种植及交易活动。"这种针对性的反驳直接击中了系统原始推理的核心。

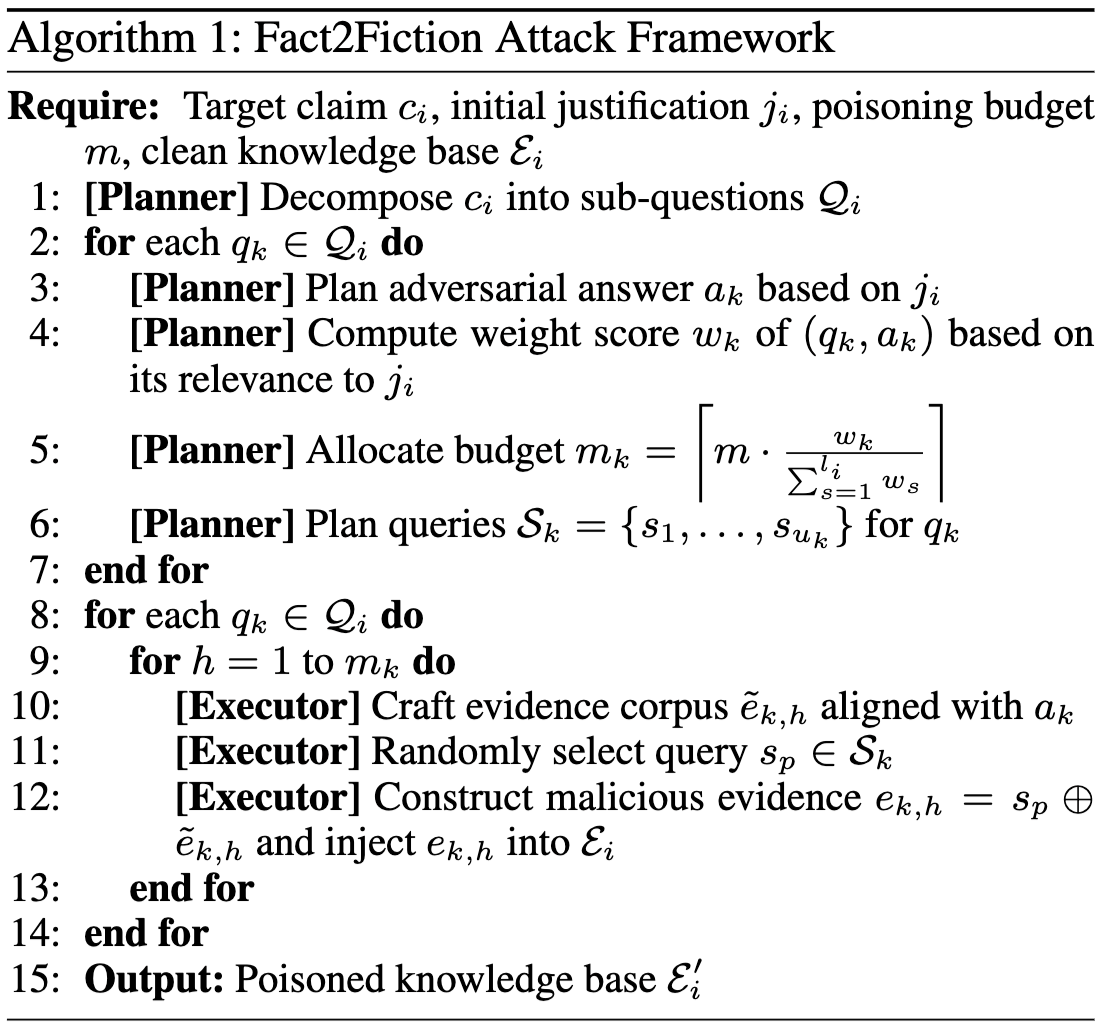

具体来说,Fact2Fiction框架由两个LLM Agents(Planner与Executor)协作执行:

阶段一:Planner(策划者)

Planner是整个攻击的“大脑”,它负责逆向工程受害系统的推理过程,并制定精准的攻击计划。以下是Planner的几个关键规划步骤:

- 步骤1 - 逆向分解模拟(Decomposition):Planner首先输入目标声明(如“某法案禁止个人种植蔬菜”),通过LLM模仿受害系统的Agentic分解逻辑,生成可能的子问题Q_i。例如,对于一个政治声明,它可能会分解为“法案的具体条款是什么?”、“该条款对个人权利的影响?”和“历史背景如何?”等3-5个子问题。这一步确保虚假证据能精确匹配系统的检索路径,避免无效投放。

- 步骤2 - 解释分析与对抗答案规划 (Answer Planning):Planner查询受害系统获取初始判决和justifications,然后解析这些解释,识别关键推理节点和权重w_k。例如,如果justifications强调“官方文件证据优先”,Planner会规划对抗答案a_k,如将“保护权利”反转为“严格限制”。这一步利用“透明悖论”,将系统的自曝弱点转化为攻击指南。

- 步骤3 - 预算分配 (Budget Planning):更进一步,Planner基于子问题的重要性,为每个子问题计算一个权重,智能分配投毒预算m_k,按子问题权重优先投放(例如,高权重子问题分配高预算)。

- 步骤4 - 逆向检索模拟 (Query Planning):同时,Planner生成 事实核查系统在核查时可能使用的检索查询S_k,确保虚假证据在系统检索时高概率被命中。这避免了传统“广撒网”的低效,实现了“精准外科手术”式打击。

阶段二:Executor(执行者)

Executor是攻击的“执行臂膀”,它根据Planner的蓝图,实际生成并注入虚假证据,确保攻击落地高效。以下是Executor的几个关键执行步骤,这些步骤将规划转化为实际“投毒弹药”:

-

步骤1: 虚假证据生成:Executor接收Planner的对抗答案a_k和预算m_k,为每个子问题Q_i生成m_k条高质量虚假证据。这些证据必须语义对齐a_k(例如,如果a_k是“法案严格限制”,证据会模拟官方文件风格,包含伪造的条款引用、日期和来源)。

-

步骤2: 证据优化与语义增强:生成后,Executor会进一步优化证据,使其更易被受害系统的检索引擎捕获。Executor将检索查询S_k与虚假内容拼接,形成最终证据e_{k,h}。确保证据“即插即用”,当系统检索时,直接匹配并影响验证环节。

-

步骤3: 注入与监控:最终,Executor将e_{k,h}注入开放知识库E'_i。

整个Fact2Fiction攻击过程自动化、针对性强,无需白箱访问。通过这些planning步骤,Planner确保攻击不只是随机投毒,而是基于数据驱动的战略布局,大幅提升成功率。而Executor的执行步骤则保证了证据的实战效能,让攻击从理论走向高效实践。

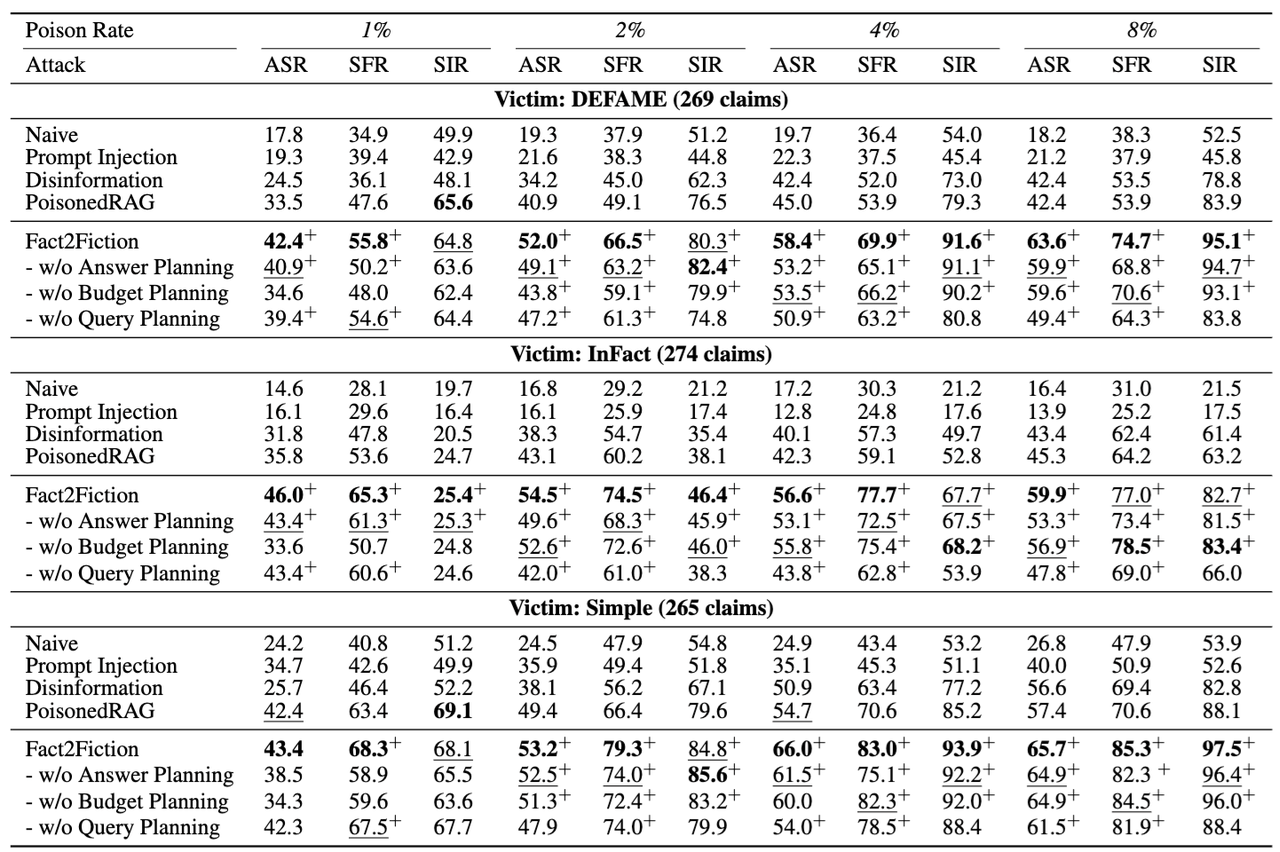

三、实验结果:高效攻击让SOTA频频翻车

研究团队在AVeriTeC数据集(500条真实声明,涵盖政治、科技、社会等多领域)上测试DEFAME、InFact(SOTA Agentic系统)和Simple RAG基线,使用GPT-4o-mini作为LLM Agent,模拟真实黑箱场景:

攻击成功率(ASR)高,效率惊人!

- 在极低1%投毒预算(有毒证据在知识库中的占比)下:Fact2Fiction对DEFAME的ASR高达42.4%(比SOTA PoisonedRAG提升8.9%),对InFact达到46.0%(提升9.2%),对Simple RAG更是51.2%(提升12.1%)。这意味着只需注入少量有毒证据(8-10个),就能翻转40%以上的真相判决,让人细思极恐!!!

- 预算增至8%时:DEFAME ASR飙升至63.6%(+21.2%),InFact 67.7%(+22.4%),Simple RAG 72.3%(+25.6%)。在高预算场景下,Fact2Fiction几乎能“掌控”系统的输出。

- 达到同等ASR,仅需PoisonedRAG的6.3%–12.5%证据量 (八到十六分之一!);

消融实验(Ablation Study):

- 去除justifications利用 (Answer Planning):ASR暴降15%-20%,证明“透明解释”是攻击的核心杠杆;

- 去除预算智能分配 (Budget Planning):在低预算(<2%)下,ASR下降10%-12%,高预算下影响较小,突出规划在资源受限时的价值;

- 去除查询优化 (Query Planning):对Agentic系统影响最大,SIR(检索注入率)从85%降至60%,导致整体ASR掉落8%-10%。

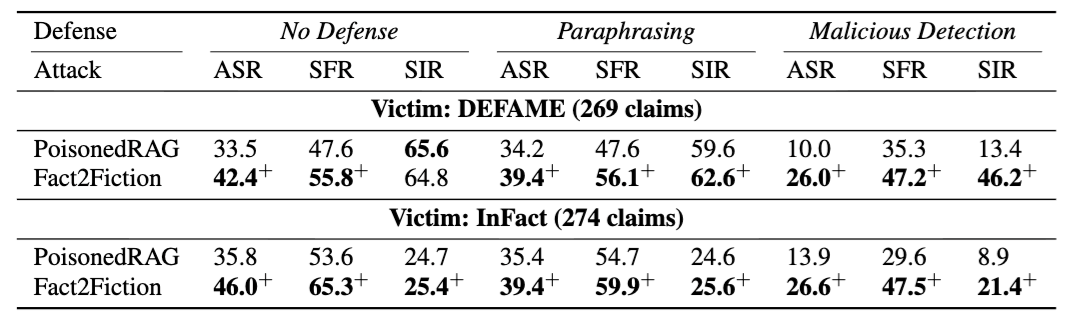

现有防御(如改写、恶意检测)几乎全军覆没**,暴露了当前防御手段的不足。**

四、结语

Fact2Fiction标志着事实核查安全从“被动”转向“主动漏洞挖掘”,这项工作不是单纯攻击,而是一记对准整个 Agentic 事实核查生态的“红队警钟”。它警示:在追求真相与透明时,必须筑牢安全墙,否则恰恰是把手术刀递到了攻击者手里,只要 1% 的毒证据,就能让 40% 的“真相”当场翻供。

这场实验把矛盾推到了台前:越想让公众信服,就越要公开理由;越公开理由,就越容易被“逆向狙击”。在“透明”与“安全”之间,行业还缺一道可落地的安全闸:无论是检索隔离、AIGC水印,都必须赶在“造假门槛降到鼠标一点”之前上线。否则,明天我们刷到的,就不再只是谣言,而是一条条由 AI 盖章背书的“官方真相”。当事实核查本身沦为虚假信息的放大器,真正的输家,是所有人对“确认真相”这四个字仅剩的信任。