为应对具身智能领域数据采集成本高且效率低、模型泛化不足以及训练范式难以规模化的瓶颈,上海人工智能实验室具身智能中心提出了“高质量合成数据驱动+统一学习框架”的数据-模型协同方案。

论文:InternVLA-A1: Unifying Understanding, Generation, and Action for Robotic Manipulation

链接:https://github.com/InternRobotics/InternVLA-A1

代码:https://arxiv.org/pdf/2601.02456

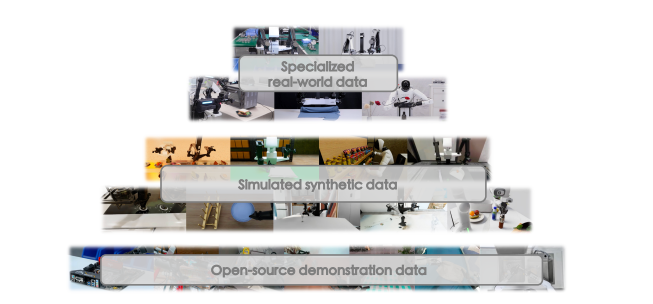

数据侧,构建了大规模高保真的仿真合成数据集 InternData-A1。该数据集覆盖异构机器人本体与丰富场景资产,面向多种操作技能提供共 63 万条轨迹,为国际首个可支撑顶尖多任务VLA模型预训练的纯合成数据集。为后续具身基座模型训练提供数据底座。

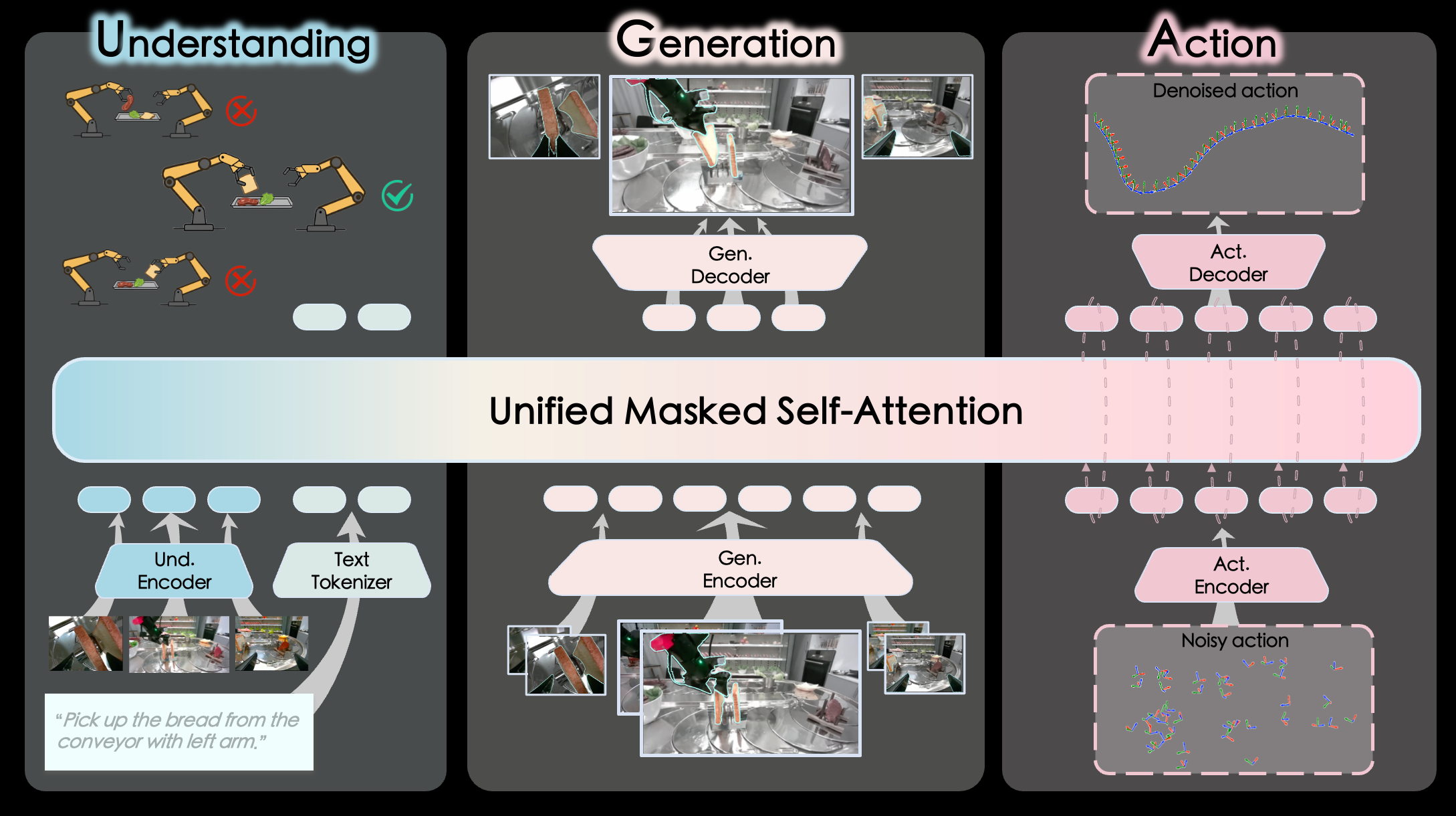

模型侧,设计了理解、生成、执行一体化的操作大模型InternVLA-A1。以 InternData-A1 为核心,并进一步融合互联网开源数据与特定真机遥操作数据,构建分层互补的“具身操作数据金字塔”,以兼顾训练规模、任务覆盖度与真实分布对齐。

在能力机制上,InternVLA-A1 协同多模态语义理解能力与世界模型未来预测能力,实现对当前场景与任务意图的解析,并对未来状态演变进行“预判”,从而更有效地指导机器人动作规划与控制。

评测结果显示,InternVLA-A1 在真机与仿真评测上整体性能均优于 π 系列与 GR00T 系列模型,并在快递物流等高动态场景中表现尤为突出。

1月27日(周二)晚8点,青稞社区和减论平台将联合组织青稞Talk 第105期,上海人工智能实验室具身智能中心青年科学家曾嘉,将直播分享《InternVLA-A1,虚实贯通:理解、生成、执行一体化的具身操作大模型》。

分享嘉宾

曾嘉,上海人工智能实验室具身智能中心青年科学家,研究方向包括机械臂操作、视觉-语言-动作大模型。2023年博士毕业于上海交通大学。在国际知名会议与期刊RSS、CVPR、NeurIPS、IEEE T-PAMI等发表论文30余篇,为具身操作大模型InternVLA-A1的项目负责人及核心贡献者、高保真仿真合成数据InternData-A1的通讯作者。曾获中国博后基金面上资助、上海“超级博士后”。入选CAAI具身智能专委会委员。

主题提纲

InternVLA-A1,虚实贯通:理解、生成、执行一体化的具身操作大模型

1、现有 VLA 模型与世界模型的局限

2、大规模高保真的仿真合成数据集 InternData-A1

3、InternVLA-A1:统一“理解–生成–执行”的 MoT

4、AMA (Ask Me Anything)环节

直播时间

1月27日(周二)20:00 - 21:00