1、VLM 做 AD 的头部问题:(1)幻觉问题,具体表现为无中生有、视而不见;(2)3D 空间理解能力不足;(3)速度慢。

- 幻觉问题的原因:静态感知。解决方案:动态感知,例如通过多次校验减少训练数据中的幻觉;例如通过 DPO 减少训练模型时产生的幻觉。例如允许模型“回头放大看看”。

- 3D 空间理解能力不足的原因:预训练任务多为 2D 的。解决方案:训练时加入空间定位任务 ,例如有工作证明在 AD 中混合具身的数据对于 AD 是有帮助的。DriveVLM 证明,虽然 VLM 可以通过高质量多层次的场景感知和理解做出决策,但额外使用 3D 感知和 PnC 轨迹生成模块后效果更好。

- 速度慢:KV Cache; Visual token 压缩;通过混合数据和 RL 让模型学会按需思考,以及根据 prompt 调节是否思考;

2、 从学术集合的开环、伪闭环评估指标来看,VLA 方案和基于 Diffusion 的方案不相上下。VLM 的优势在于可解释性。

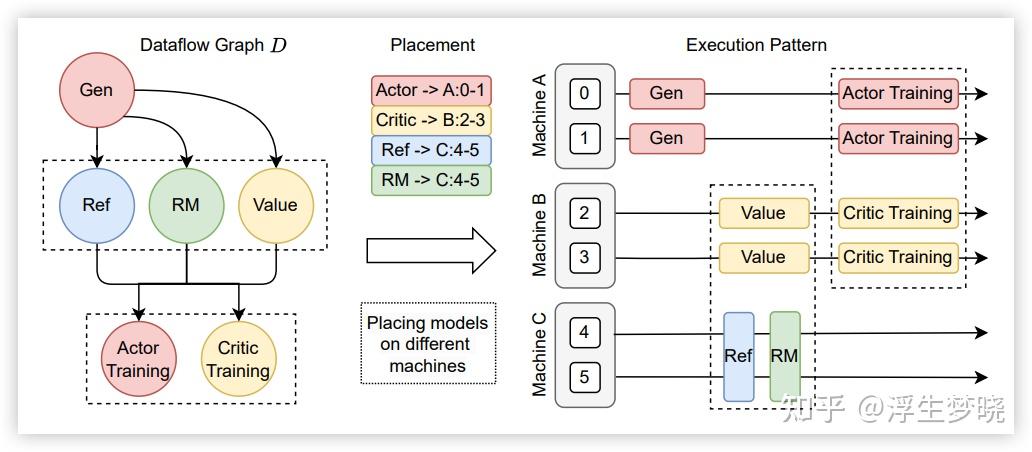

3、 学习范式需要从模仿学习(SFT)转向偏好学习(DPO,GRPO)。对于 RL 阶段,多任务同时训练会比分阶段训练单任务的效果更好 。

4、 要防止 foundation model 发生灾难性遗忘,最简单有效的方法就是加预训练数据(re-play)。

5、 更丰富的监督信号有助于模型学到更好的表征。具体实现方式是在 VLM 模型的基础上增加其他任务 head, 辅助任务的实现有多种方式,

例如:预测 W0 下一帧画面;3D occ and flow; 物体检测(vehicle, pedestrians, bicyclists, etc.,); 交通信号灯; 道路语义信息; 限速等道路属性; 语言形式的决策信息。这种方式可以实现 scaling law.

6、 CoT 是重要的,但在数据量极大的情况下要用好 CoT 并不容易。除了纯文本形式的 CoT, 多模态的 CoT 也正在兴起。

7、 目前 VLM 中的 vision 与 language 的交互不足,限制了 VLM 作为 base model 的效果。改善思路是增强 Vision-Language 的交互。

例如 Qwen3-VL 使用 Deepstack 把图片 token 分别输入到 LLM 的不同层去, 这是提升 VL 交互的一种方式;例如华为提出的 W0 引入图像生成的辅助任务缓解 VLA 训练中的维度灾难问题,这也是 VL 的深度融合。

8、 轨迹的输出方式不重要。无论是 VLM 直接以文本的方式输出轨迹,还是 VLM 输出 special token 映射为轨迹,或者是接 diffusion head 生成轨迹,都是可以的,效果都不错。目前工业界主要用 diffusion head 生成轨迹,因为这样速度最快。

9、 评估并不容易。闭环测试指标比开环差,原因:

- (1)目标不一致,离线模仿学习的训练目标(最小化模仿误差)与在线部署时的实际目标(最大化累积回报)不一致 。

- (2)观测不一致,训练时的传感器输入数据和测试时的观测数据之间分布不同。因为训练数据来自离线记录,而测试数据是根据驾驶行为实时产生的。

🤔 Open Discussion

1、什么样的 CoT 才算好? 用文字的详细描述无法代替图片,那么单纯用文本的推理就可以吗?

2、是否需要推理时也加入 visual CoT?

- Thinking with Generated Images提出仅仅用图像生成做 CoT 对于视觉规划任务的指标和泛化性都有提升。

- FSDrive 提出用图像 CoT 代替文本 CoT, 可以提升模型在场景理解上的表现,降低碰撞率。

- Multimodal Chain-of-Thought Reasoning in Language Models 提出混合图文的 CoT 可以完成更复杂的任务。

- ImagiDrive 提出先用 VLM 生成初版驾驶决策,再用生成模型预测接下来 1 秒(2hz)的画面,根据想象的画面修正 VLM 的预测,该方法在预测碰撞的场景(侧方高速来车,急弯)下表现很好。

3、让模型在 CoT 的过程中调用工具 (调视角,看历史,放大,测距离) 能取得更好的效果。

4、目前 VLM 模型上添加 CoT 后无法在 AD 中取得更好效果的原因是什么?

- (1)CoT 质量不高,因果关系不强;

- (2)测试集不够复杂,无法提现 CoT 的优势;

- (3)VLM 这个基础模型本身训练的不够好,由于 visual 和 text 的对齐不好导致 VLM 无法拥有 LLM 的一些优良性质(例如 CoT, RAG, ICL)

引入更好的 image-text 交互能不能缓解该问题?Qwen3-VL 使用了 Deepstack, 把图片 token 分别输入到 LLM 的不同层去, 更好的实现对图片的精细化理解,并且在高分辨率 VQA 任务上提高了效率。

欢迎讨论!

.png)