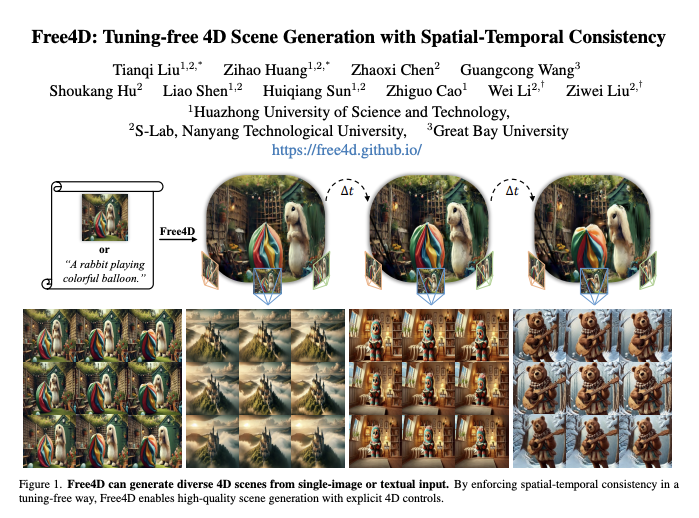

Free4D,是由华中科技大学、MMLab@NTU以及湾大的研究者最新提出的一种无需调整的新型框架,可用于从单个图像生成 4D 场景。

Paper:Free4D: Tuning-free 4D Scene Generation with Spatial-Temporal Consistency

Abs:https://arxiv.org/abs/2503.20785

Code:https://github.com/TQTQliu/Free4D

现有的 4D 生成方法要么专注于对象级生成,从而导致场景级生成不可行,要么依赖大规模多视角视频数据集进行昂贵的训练,并且由于 4D 场景数据的稀缺性而导致泛化能力有限。

相反,Free4D 的研究者关键见解是提炼预先训练的基础模型以获得一致的 4D 场景表示,这提供了效率和泛化能力等有希望的优势。

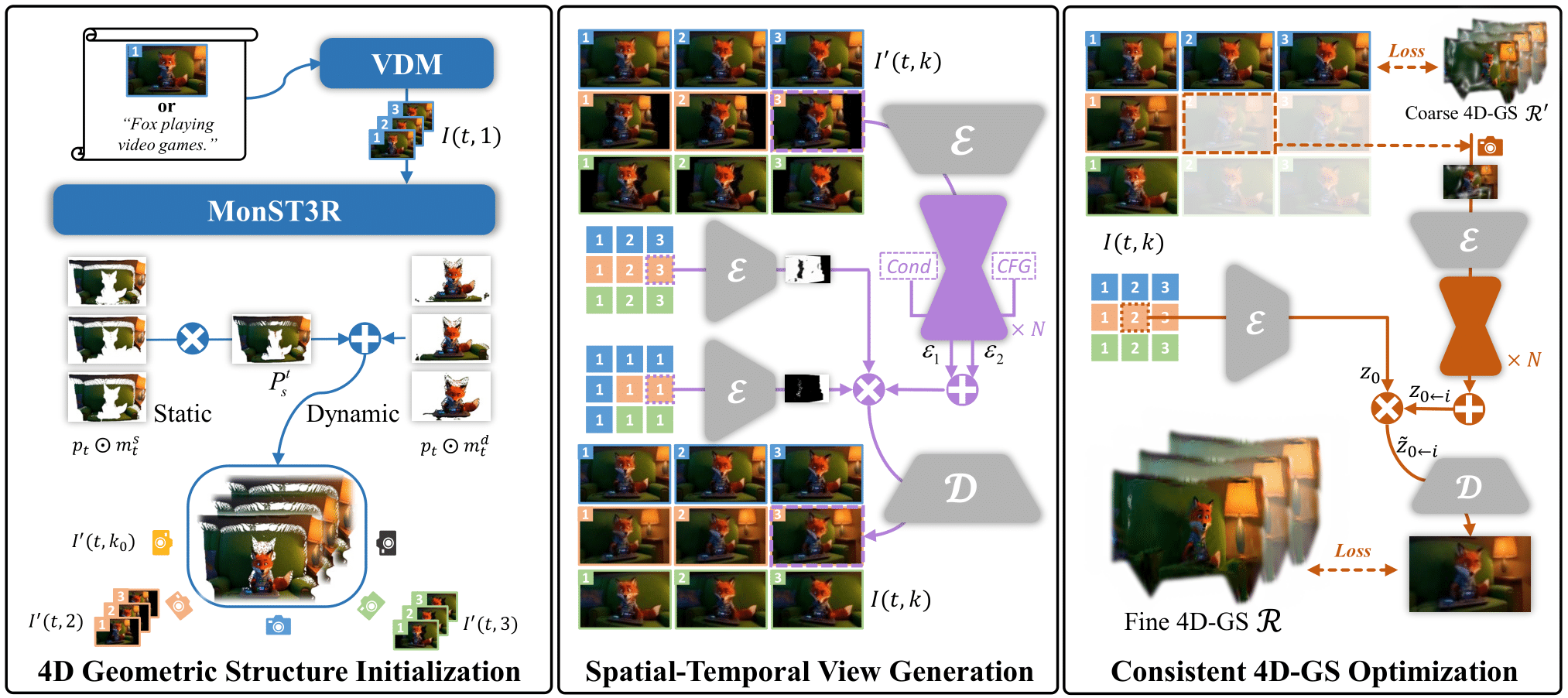

- 1 )为此,他们首先使用图像到视频扩散模型为输入图像制作动画,然后初始化 4D 几何结构。

- 2 )为了将这种粗结构转换为时空一致的多视角视频,研究者设计了一种自适应引导机制,该机制采用点引导去噪策略实现空间一致性,并采用新颖的潜在替换策略实现时间相干性。

- 3 )为了将这些生成的观测提升为一致的 4D 表示,研究者提出了一种基于调制的细化方法来减轻不一致性,同时充分利用生成的信息。

由此产生的 4D 表示可以实现实时、可控的时空渲染,标志着基于单图像的 4D 场景生成的重大进步。

4月26日上午11点,青稞Talk 第47期,华中科技大学硕士在读、MMlab@NTU研究助理刘天齐,将直播分享《Free4D:无需微调的 4D 场景生成新框架》。

分享嘉宾

刘天齐,华中科技大学硕士在读,现为MMlab@NTU的研究助理,主要研究方向包括3D/4D重建与生成。

主题提纲

Free4D:无需微调的 4D 场景生成新框架

1、4D 生成相关工作回顾

2、单图像生成 4D 场景的难点

3、Free4D:从单张图像生成高质量、时空一致的 4D 场景

4、效果展示与应用实践

直播时间

4月26日上午11:00 - 12:00

参与方式

Talk 将在青稞·知识社区上进行,扫码对暗号:" 0426 ",报名进群!