往期解读:聊聊在大模型推理强化学习中熵机制上的探索

强化学习已经成为大模型智能跃升的下一个增长点,在这个背景下,本文旨在解决将强化学习用于大语言模型推理时面临的一个主要障碍——策略熵塌缩问题。

这种现象在大量未引入熵干预的强化学习训练中普遍出现,表现为策略熵在训练初期急剧下降,探索能力随之减弱,并始终伴随着策略性能的饱和。

在实践中,我们建立了熵 H 与下游性能 R之间的经验性转化方程:

R = −a exp H + b

这一经验规律强烈表明:策略性能是以策略熵为代价换来的,因此策略性能最终受限于熵的耗尽。其上限在理论上是可预测的:当 H=0 时,R=−a+b。

这一发现表明,为了实现可持续的探索并扩大 RL 的计算规模,必须对熵进行有效管理。为此,我们从理论和实证两个方面研究了策略熵的动态变化机制。

理论推导表明,策略熵的变化由“动作概率与 logits 变化之间的协方差”所驱动;在使用策略梯度类算法时,这一协方差项与优势函数呈正比关系并通过实证研究进一步验证了这一定理。我们发现协方差项与策略熵的实际变化量高度一致,二者几乎精确匹配。

此外,在整个训练过程中,协方差项大多保持为正值,这进一步解释了为什么策略熵会单调递减。在理解了熵动态变化的机制之后,我们提出应通过限制高协方差 token 的更新来实现对熵的控制。

具体而言,我们提出了两种简单而有效的技术:

- Clip-Cov:对高协方差 token 的更新幅度进行截断;

- KL-Cov:对高协方差 token 增加 KL 散度惩罚项。

实验表明,这些方法能够有效促进策略的探索能力,帮助其避免熵塌缩,从而在下游任务中获得更好的性能表现。

目前,KL-Cov 和 Clip-Cov 方法已合并到verl中!只需将 loss_mode 设置为 "clip_cov" 或 "kl_cov",即可在 verl 中轻松使用该方法。

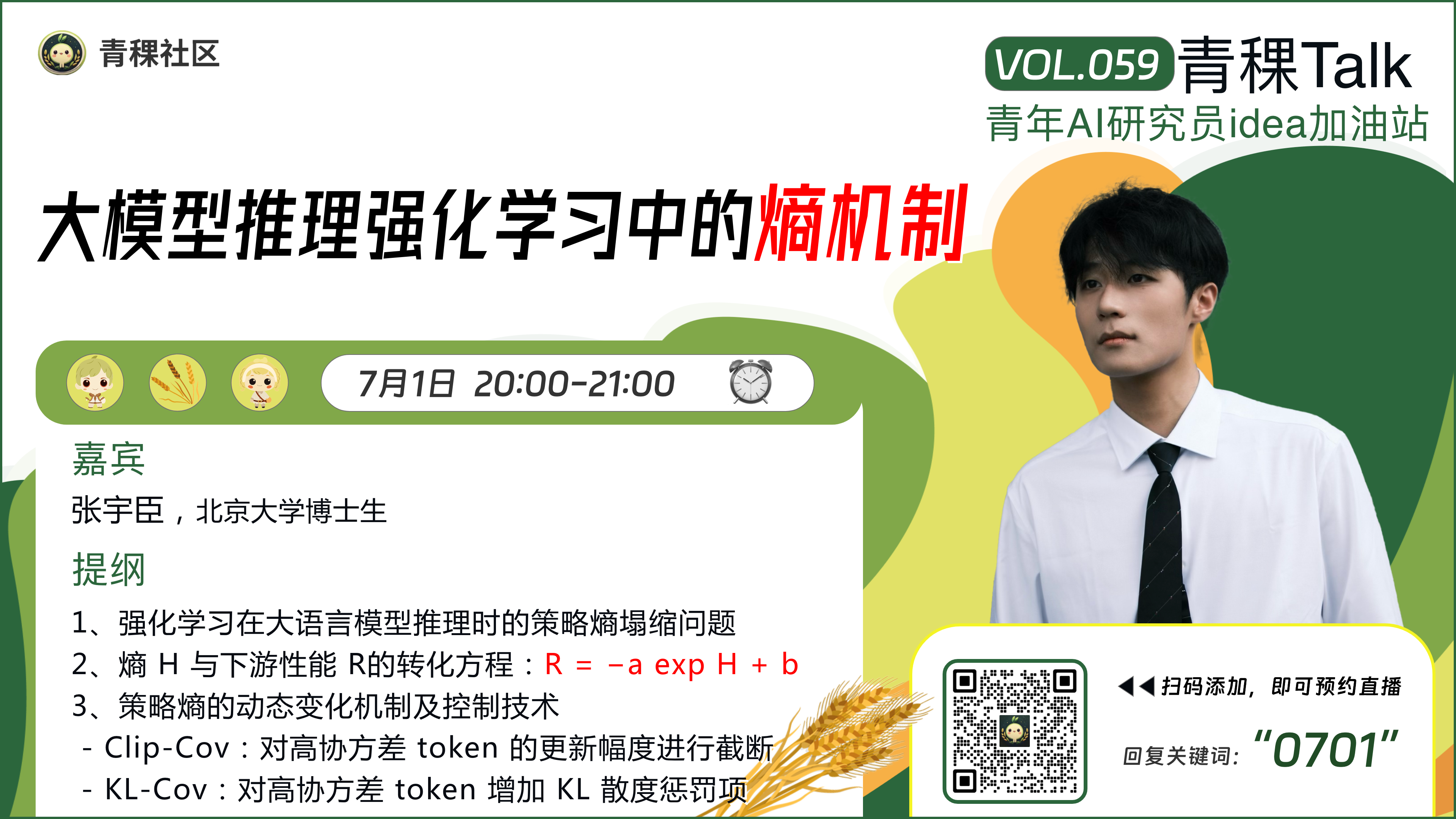

7月1日20:00,青稞Talk 第59期,北京大学博士生张宇臣,将直播分享《大模型推理强化学习中的熵机制》。

主题提纲

大模型推理强化学习中的熵机制

1、强化学习在大语言模型推理时的策略熵塌缩问题

2、熵 H 与下游性能 R之间的经验性转化方程:R = −a exp H + b

3、策略熵的动态变化机制及控制技术

- Clip-Cov:对高协方差 token 的更新幅度进行截断

- KL-Cov:对高协方差 token 增加 KL 散度惩罚项

直播时间

7月1日20:00 - 21:00

参与方式

Talk 将在青稞·知识社区上进行,扫码对暗号:" 0701 ",报名进群!